“L’IA va remplacer les développeurs.” Vous l’avez entendu aussi ? Mais dans le développement logiciel sur-mesure, la réalité est autre. Les projets sont complexes, spécifiques, souvent construits from scratch. Pas question de générer une app complète en trois prompts.

En revanche, ce qu’on voit très concrètement chez Yield, c’est autre chose :

- des cas d’usage IA bien ciblés, qui font gagner un temps précieux ;

- des intégrations simples qui fiabilisent les étapes critiques ;

- des automatisations qui soulagent les équipes, sans alourdir les process.

Pas besoin de former une AI Squad ni de tout repenser. Mais avec les bons outils, et les bonnes idées, l’IA devient un levier très concret pour mieux documenter, mieux tester, mieux comprendre les données, mieux collaborer produit / dev / métier.

Dans cet article, on partage 5 cas d’usage IA réellement utiles dans des projets web sur-mesure. Testés, adoptés, adaptables.

Pourquoi l’IA a vraiment un intérêt dans le dev sur-mesure

Le développement logiciel sur-mesure, ce n’est pas juste “coder une app” — c’est comprendre un besoin spécifique, poser une architecture propre, livrer avec qualité… souvent dans des environnements métier complexes.

👉 Et c’est justement là que l’IA peut faire la différence : pas pour remplacer les développeurs, mais pour accélérer, fiabiliser, et documenter là où ça compte.

Ce qu’on voit sur le terrain, côté Yield :

- Gagner du temps sur les tâches à faible valeur ajoutée : générer des jeux de données de test, formater une documentation, proposer des templates de tests unitaires…

- Rendre visible ce qui ne l’est pas : synthétiser des logs, analyser du legacy, détecter des patterns dans un historique projet.

- Faciliter le lien produit-dev : transformer une spec produit en ébauche de tests, d’API ou de règles métier.

- Automatiser certaines vérifications : reviewer une PR, analyser un prompt, suggérer une correction.

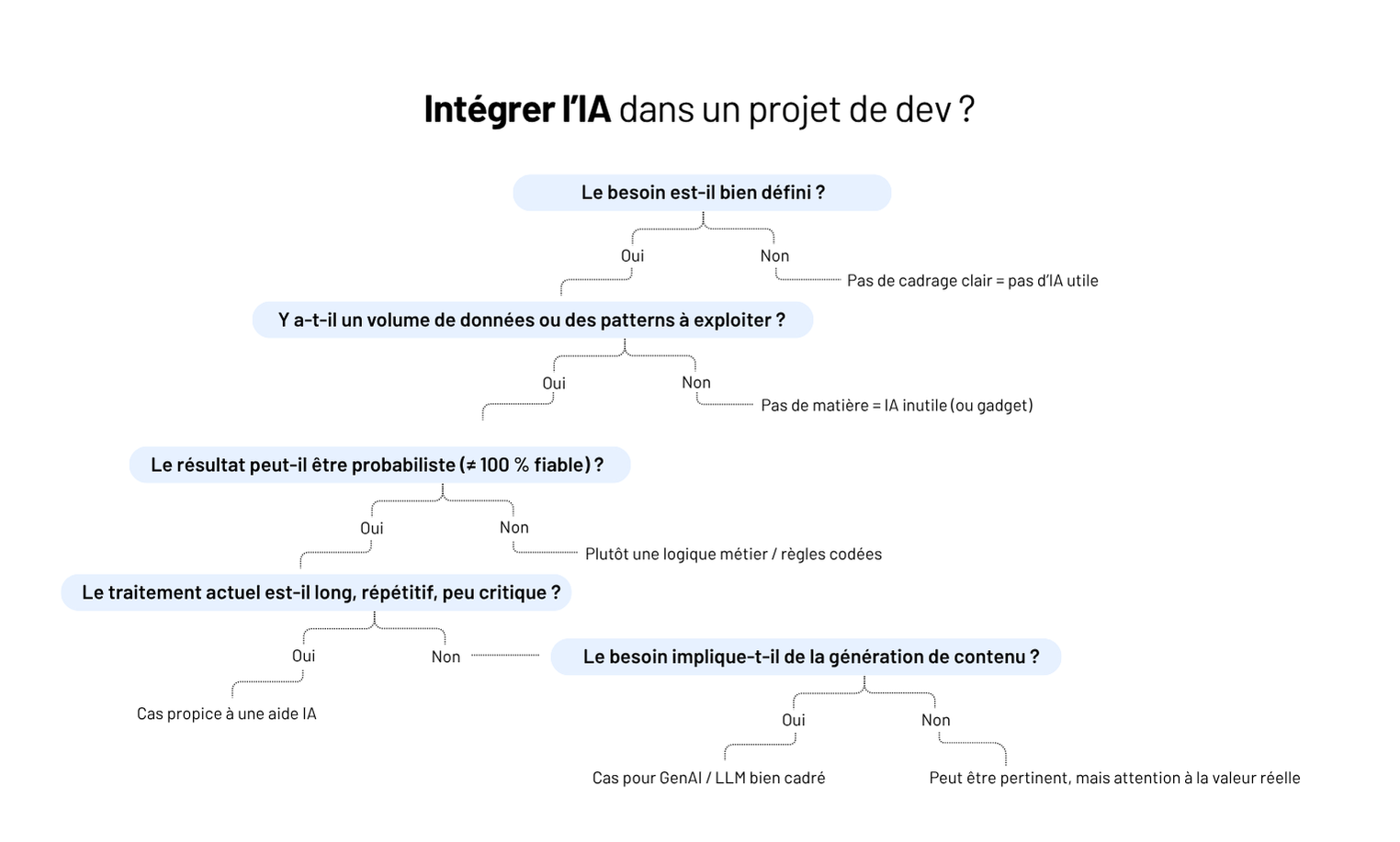

⚠️ Mais tout ça ne marche que si :

- les prompts sont bien cadrés (sinon, l’IA hallucine) ;

- les inputs sont propres (sinon, les réponses sont inutiles) ;

- et les usages sont ciblés (sinon, c’est juste une démo gadget).

💡 Ce qu’on répète souvent : une IA bien utilisée, c’est une IA qui fait gagner du temps sans créer de dette.

Cas #1 - Générer du code répétitif ou boilerplate

Certaines tâches reviennent encore et encore : créer des modèles CRUD, poser la base d’un composant frontend, générer une couche d’API ou d’accès aux données… Rien de complexe — mais beaucoup de copier-coller.

👉 Avec des prompts bien calibrés, une IA comme GPT-4 peut :

- générer un service TypeScript ou Python à partir d’un modèle métier ;

- proposer une structure d’API REST cohérente avec un use case ;

- créer les squelettes de tests unitaires basés sur un fichier de code.

Retour d’XP :

“Sur un projet d’outils RH, on utilisait un prompt maison pour générer les services backend à partir du modèle métier. Ça nous a vraiment accélérés sur la mise en place. Et comme c’était relu derrière, on gardait la maîtrise technique.”

— Simon, Lead Dev @Yield Studio

⚠️ À garder en tête :

- L’IA ne remplace pas les choix d’architecture.

- Il faut toujours relire, adapter, tester.

- C’est un outil pour accélérer, pas pour déléguer des décisions tech.

Bien utilisé, c’est un vrai booster sur les phases d’amorçage — surtout sur des architectures déjà balisées (Clean Architecture, DDD light…).

Cas #2 - Accélérer l’écriture de tests (unitaires, end-to-end, contractuels)

Écrire des tests est essentiel — mais reste parfois perçu comme une contrainte. Et sur des projets où les deadlines sont serrées, c’est souvent le premier poste sacrifié. Pourtant, bien accompagnée, l’IA peut réduire drastiquement le temps passé à écrire les tests… sans rogner sur leur qualité.

Concrètement, elle peut servir à :

- Générer un test unitaire complet à partir d’un service ou d’un composant React.

- Proposer des cas limites à tester automatiquement, y compris les erreurs.

- Suggérer une suite de tests e2e en partant d’un scénario métier rédigé.

Retour d’XP :

“Sur une plateforme de contrats, on a demandé à GPT de générer des tests à partir de nos scénarios Gherkin. C’était pas 100 % plug and play, mais ça posait déjà une bonne base. Le plus dur (la structure) était fait.”

— Claire, QA Engineer @Yield Studio

👉 L’IA est particulièrement utile pour les tests oubliés (erreurs, edge cases), pour produire vite une couverture de base sur un projet existant, pour onboarder une équipe dev sur un projet déjà lancé.

⚠️ À condition d’avoir :

- une logique métier claire (sinon les tests sont à côté) ;

- une stack testable (Cypress, Vitest, Jest…) bien en place.

Cas #3 - Booster la productivité avec un “pair dev IA”

Sur certains projets, surtout en phase de montée en charge, l’IA peut jouer un rôle inattendu : celui de coéquipier technique. Pas pour remplacer — mais pour soutenir le raisonnement, débloquer un problème, ou générer un brouillon de code plus vite.

Ce qu’on voit de plus en plus chez nos devs :

- Besoin d’un snippet rapide pour parser une date ISO complexe ? Le LLM propose plusieurs approches en quelques secondes.

- Une regex tordue à écrire ? On l’obtient en 2 prompts, testée et expliquée.

- Une lib mal documentée ? L’IA peut générer un exemple minimal pour gagner du temps.

Le vrai gain ? On passe moins de temps à chercher, à scroller sur Stack Overflow ou à déchiffrer des documentations opaques. Et plus de temps à réfléchir à la structure du code et aux vrais enjeux du projet.

Retour d’XP :

“Nos devs juniors utilisaient Cursor pour les petits blocages du quotidien. C’est pas magique, mais quand tu galères sur une regex ou un parsing un peu relou, ça te fait gagner 30 minutes. Et côté seniors, on sentait que ça fluidifiait les revues.”

— Hugo, Engineering Manager @Yield Studio

⚠️ Limite à poser impérativement : ne pas “copier-coller” sans relire. L’IA peut halluciner, ou générer du code inutilement complexe. Chez Yield, on garde la règle : ce que l’IA propose, c’est un point de départ — pas un livrable.

Cas #4 - Créer une documentation technique plus fluide (et vivante)

La documentation est souvent le parent pauvre d’un projet logiciel. Manque de temps, flemme, ou difficulté à bien formuler ce qu’on fait… Résultat : des pages obsolètes, des README vides, des devs perdus en onboarding.

C’est là qu’un LLM bien utilisé peut faire gagner un temps précieux.

Cas concrets vus chez Yield :

- Générer un premier brouillon de README à partir des noms de fichiers, commentaires et structure du projet ;

- Résumer une PR complexe en langage naturel pour mieux partager son contenu ;

- Expliquer un morceau de code métier à un·e dev non expert·e du domaine.

👉 L’IA n’écrit pas la doc à votre place. Mais elle vous aide à passer le cap du “syndrôme de la page blanche”. Et à garder une base claire, lisible, accessible à tous.

Retour d’XP :

“Sur un SaaS santé, on avait branché un bot sur nos repos pour proposer un résumé de PR à chaque merge. C’était imparfait, mais hyper utile en relecture ou pour onboarder. On l’a vite gardé dans le process.”

— Lucie, Product Builder @Yield Studio

⚠️ Attention à la dérive “doc générée à l’aveugle”. Ce n’est pas parce que l’IA écrit bien qu’elle comprend. On garde la main pour valider — et on évite les formulations floues ou imprécises.

Cas #5 - Générer des jeux de données de test réalistes

Tester une app avec des données factices, c’est souvent le cauchemar : prénoms bidons, dates incohérentes, données trop propres. Et pourtant, un bon jeu de test fait toute la différence pour détecter les bugs, simuler des cas limites… et valider des features avant la prod.

Là aussi, l’IA peut aider — si elle est bien cadrée.

Cas d’usage concrets :

- Générer des profils utilisateurs complets et réalistes (avec cohérence entre prénom, mail, date de naissance, etc.) ;

- Créer des scénarios métier riches : ex. utilisateurs inactifs depuis X mois, comptes incomplets, transactions en erreur…

- Simuler des comportements “extrêmes” : erreurs saisies, chaînes longues, formats inattendus.

👉 Utiliser un modèle GenAI ou une librairie boostée au prompt engineering permet de produire des jeux de données plus proches du réel, avec moins de scripts maison à maintenir.

Retour d’XP :

“L’IA nous a permis de générer des jeux de données métier avec des cas tordus (incohérences, doublons, profils incomplets). Pour la QA, c’était clairement un plus : on détectait plus de bugs, plus tôt.”

— Antoine, Tech Lead @Yield Studio

⚠️ On ne laisse pas un LLM créer n’importe quoi. On fixe des règles : format, cohérence, diversité. Et surtout, pas de données perso réelles en entrée. Jamais.

Conclusion — L’IA ne remplace pas les devs. Elle leur fait gagner du temps (quand elle est bien utilisée).

Utiliser l’IA dans un projet sur-mesure, ce n’est pas “suivre la tendance”. C’est identifier ce qui mérite d’être accéléré, enrichi, automatisé — sans sacrifier la qualité, la compréhension métier ou la maintenabilité.

👉 Générer du code, résumer un ticket, compléter un test, préparer un jeu de données : tous ces “petits” gains peuvent, à l’échelle d’un projet, transformer la vélocité.

Mais ça ne marche que si :

- on cible les bons cas d’usage, là où l’IA apporte une vraie valeur ;

- on intègre l’outil dans un cadre maîtrisé (inputs, outputs, responsabilités) ;

- et on garde une équipe responsable, qui comprend ce qu’elle livre.

Chez Yield, on ne déploie pas l’IA pour faire joli. On l’utilise pour aider les équipes à aller plus vite sans créer de dette— sur des produits métier où la robustesse compte.

👉 Vous explorez l’IA dans un contexte dev ? On peut vous aider à cadrer les bons cas, outiller vos équipes, et avancer concrètement.