Computer vision

Développez la reconnaissance d’images et de vidéos

Chez Yield Studio, nous aidons les entreprises à structurer, centraliser et exploiter leurs données pour en faire un véritable actif stratégique. Pipelines solides, Data Lakes performants, qualité de données, gouvernance, intégration SI : notre approche repose sur une ingénierie senior, orientée usages et ROI.

Les organisations qui visent une data infrastructure robuste et durable choisissent Yield Studio pour notre capacité à concevoir des architectures solides, scalables et alignées avec leurs enjeux stratégiques. Nos ingénieurs seniors bâtissent des plateformes data fiables, sécurisées et parfaitement orchestrées, capables de soutenir la croissance, les usages critiques et les futurs projets IA. Nous ne livrons pas des pipelines isolés, mais une fondation technique qui accompagne l’ambition de l’entreprise sur plusieurs années.

Chez Yield Studio, nous construisons des fondations data capables de soutenir des usages métiers critiques. Notre priorité est simple : garantir que vos données soient fiables, structurées, accessibles et prêtes à être activées, quels que soient vos volumes ou votre architecture existante. Nous appliquons une ingénierie rigoureuse : ingestion multi-sources, pipelines ETL/ELT robustes, normalisation avancée, gouvernance, monitoring continu et sécurité by design. Chaque brique est pensée pour fonctionner en production, résister aux changements, et accompagner l’évolution de vos besoins.

Nous ne livrons pas des “datasets nettoyés”, mais une infrastructure data opérationnelle, documentée, maintenable et alignée avec les standards des meilleures équipes Data & Engineering.

data par mois opérés sur des pipelines et orchestrations conçus par nos équipes.

livrés incluant Data Lakes, ETL/ELT, intégrations SI et architectures scalables.

de données traitées chaque jour dans nos flux et plateformes data.

> 99,9 % sur les pipelines que nous supervisons (observabilité & alerting intégrés).

Nous écrivons un code de qualité dès le départ pour aller plus vite ensuite

Nous identifions les fonctionnalités différenciantes pour les utilisateurs finaux

Nous mettons très rapidement en production les fonctionnalités grâce à notre Lean Lab’ ®

Lorsque votre organisation démarre ou restructure sa stratégie data, nous concevons l’intégralité de l’infrastructure : ingestion multi-sources, pipelines ETL/ELT, Data Lake ou Data Warehouse, modèles de données, qualité et gouvernance.

Votre plateforme data fonctionne, mais manque de performance, de qualité ou de robustesse.Nous auditons vos flux, détectons les goulots d’étranglement, corrigeons les erreurs de transformation, consolidons les pipelines, améliorons la qualité des données et renforçons l’orchestration et la sécurité.

Une infrastructure data doit évoluer en continu : nouvelles sources, nouveaux schémas, mises à jour des pipelines, corrections, optimisations, supervision, alerting, documentation vivante.Nous assurons un suivi régulier, monitorons les flux, gérons les incidents, garantissons les performances et accompagnons vos équipes dans les évolutions.

Nous accompagnons nos clients sur des projets data où la fiabilité, la scalabilité et la qualité des pipelines sont essentielles à la performance.

Nous analysons vos sources, pipelines existants, schémas, volumes, contraintes techniques et besoins métiers. L’objectif : comprendre où se situent les risques, les silos, les dettes techniques et les leviers de performance, puis définir une architecture cible réaliste et scalable.

Nous centralisons, nettoyons, normalisons et organisons vos données pour les rendre fiables et exploitables.Cela inclut : ingestion multi-sources, modèles de données, gestion du lineage, règles de qualité, documentation, gouvernance et sécurité.

Nous mettons en place les pipelines ETL/ELT, l’orchestration, le Data Lake / Warehouse, les règles de transformation et l’observabilité complète.Stack type : Airflow / Dagster, dbt, Kafka, Snowflake, BigQuery, S3 / GCS, Terraform, CI/CD.L’objectif : une plateforme data robuste, performante et maintenable qui tourne en production sans rupture.

Nous exposons la donnée via API, dashboards, modèles analytiques ou outils internes pour qu’elle soit réellement utilisée par vos équipes. Nous accompagnons ensuite vos équipes Data/Produit dans l’appropriation, la montée en compétence et les évolutions de l’écosystème.

Pourquoi tant d’applications sont livrées… mais jamais vraiment utilisées ?

On a créé Yield Studio en 2019 pour y répondre : un bon produit digital, c’est d’abord un usage, un impact, une adoption.

Oui, on aime le code de qualité — nos développeurs seniors y veillent chaque jour — mais toujours au service d’un objectif clair et mesurable.

Produits digitaux construits pour des besoins B2B, B2C et internes

de NPS client depuis 2019. Nous construisons un partenariat sur la durée.

Développement web & mobile

Product Management

Data & IA

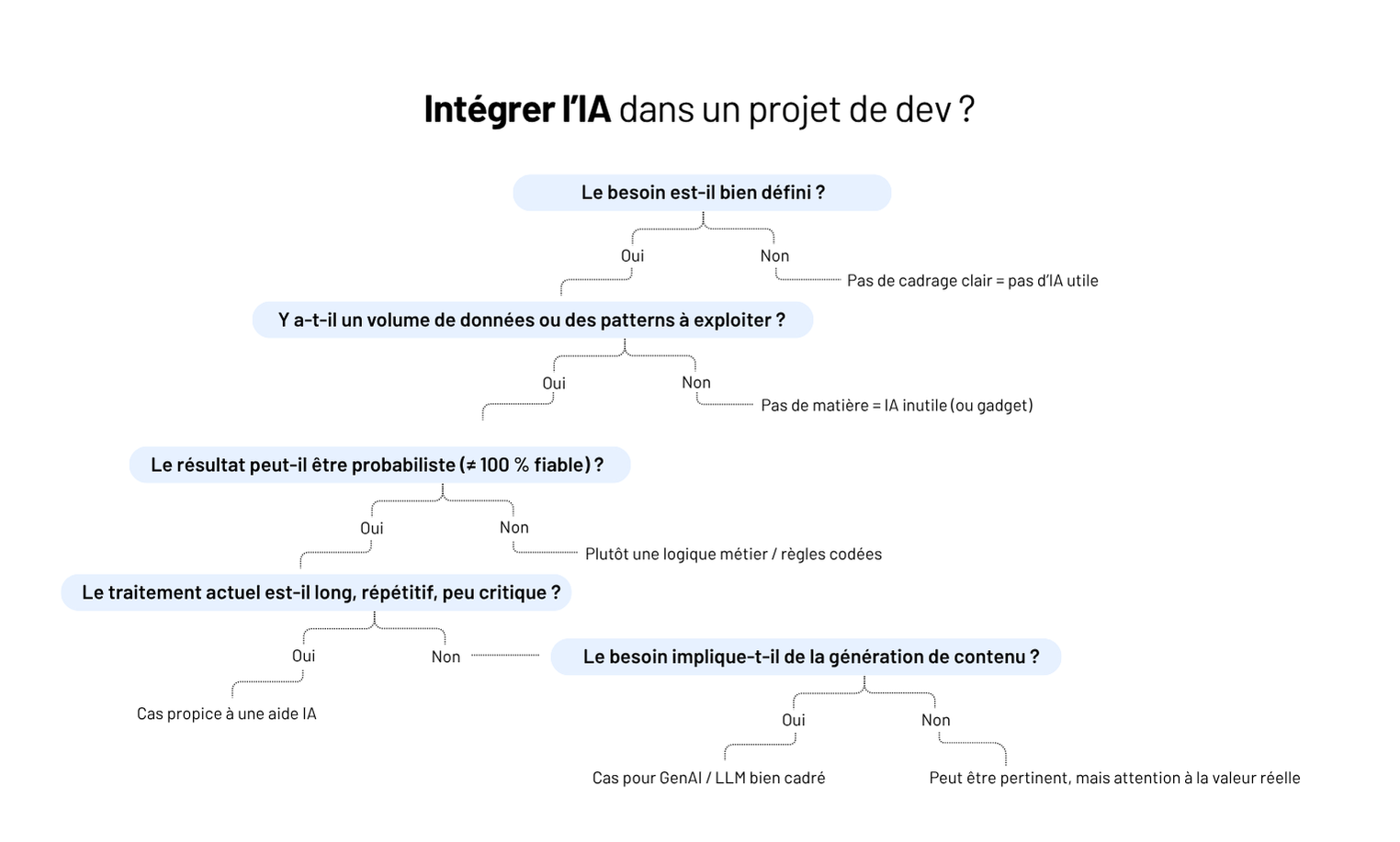

En 2025, tout le monde veut “mettre de l’IA dans son logiciel”. Mais très peu savent ce que ça signifie réellement.

Dans un logiciel métier, l’IA n’est pas là pour faire rêver les comités de pilotage. Elle est là pour résoudre des frictions bien tangibles : la saisie qui prend trop de temps, les documents qu’on ne lit jamais, les validations qui s’enchaînent mal, les données qu’on n’arrive pas à exploiter.

Et c’est justement là que beaucoup de projets dérapent : on confond innovation et utilité, LLM et magie, automatisation et simplification.

Chez Yield, on voit la même histoire se répéter : des intégrations IA qui impressionnent en démo… mais que personne n’utilise en production. Parce que la vraie difficulté n’est pas de brancher un modèle, mais d’intégrer l’IA dans un usage, dans un flux, dans un métier, sans casser ce qui fonctionne déjà.

👉 Dans ce guide, on aborde ce que l’IA change vraiment, les cas d’usage qui tiennent en prod, comment s’y préparer, et comment l’intégrer sans transformer votre logiciel en terrain d’expérimentation.

Quand on ajoute de l’IA dans un logiciel métier, on ne change pas l’outil : on change la manière dont les utilisateurs s’en servent.

Et c’est exactement pour ça que l’IA est souvent mal intégrée : on la pense comme une feature alors qu’elle agit comme une mutation du flux métier.

La vitesse de traitement des informations

Là où un humain met 3 minutes à comprendre un document, l’IA met 200 ms.

C’est ça, la vraie rupture : tout ce qui dépendait de la lecture, de la synthèse, de l’interprétation… devient instantané.

La densité des tâches

Une opération qui demandait 3 écrans et 6 clics peut se réduire à une intention : “pré-remplis-moi ça”, “trouve-moi l’erreur”, “résume-moi ce ticket”.

L’IA court-circuite la lourdeur des logiciels métiers traditionnels.

La valorisation des données non structurées

Email, PDF, photos terrain, comptes-rendus, messages Slack, tickets…

L’IA transforme tout ce qu’on ne savait pas exploiter en données activables.

Le modèle métier

Si la règle métier change selon le jour, la personne ou le contexte, un LLM ne fera que refléter ce chaos.

La robustesse de l’architecture

Intégrer de l’IA dans un système bordélique, c’est brancher une batterie externe sur un moteur qui tousse.

La qualité des inputs

Aucune IA ne rattrape des données contradictoires, incomplètes ou produites par dix équipes différentes.

Retour terrain

“Sur un projet de qualification de dossiers, l’IA donnait des réponses différentes selon les cas. Le client pensait qu’elle hallucinait. En réalité, leurs propres règles variaient d’un opérateur à l’autre.

L’IA n’inventait rien : elle reproduisait l’incohérence métier. Quand les règles sont floues, l’IA amplifie le chaos ; quand elles sont stables, elle fait gagner des semaines.”

— Hugo, Engineering Manager @ Yield Studio

Dans un logiciel métier, l’IA n’a de valeur que si elle réduit une charge réelle. Pas si elle impressionne en comité.

Chez Yield, on a vu passer des dizaines d’idées IA ; 80 % meurent en atelier car elles ne changent strictement rien au quotidien utilisateur.

Les 20 % restants ? Ceux-ci.

Dossiers PDF de 40 pages, tickets interminables, comptes-rendus d’intervention, historiques clients : la réalité terrain, c’est que 90 % du contenu n’est jamais lu.

L’IA change la donne en fournissant immédiatement :

👉 Les utilisateurs arrêtent de scanner au hasard et reprennent le contrôle.

On ne parle pas ici d’un OCR standard.

On parle d’un modèle qui comprend le document, détecte les incohérences et vous remonte les anomalies :

C’est un des cas d’usage les plus rentables : il transforme un poste chronophage et risqué en flux robuste.

La plupart des logiciels métiers meurent d’un truc simple : la saisie.

Trop, tout le temps, partout.

L’IA permet enfin de pré-remplir à partir :

Le gain est immédiat en charge mentale et en vitesse.

La recherche sémantique, ce n’est pas un luxe : c’est la seule façon de retrouver une info quand votre outil contient 40 notions métier et trois systèmes d’indexation.

Ce que ça débloque :

👉 C’est LA feature qui fait remonter la satisfaction utilisateur.

Personne n’aime ouvrir 200 tickets, trier les mails entrants, prioriser les demandes internes ou classifier les dossiers. Bonne nouvelle : l’IA, si.

Elle peut :

👉 C’est le premier levier pour faire respirer les équipes back-office.

On ne parle pas de “fraude”. On parle de toutes les micro-incohérences qui font dérailler un workflow :

Ce sont celles qui coûtent cher et que personne ne voit.

💡 Pro tip

Avant d’ajouter une feature IA, posez juste cette question :

“Quel utilisateur gagne combien de minutes par semaine grâce à ça ?”

Si la réponse n’est pas mesurable → abandon immédiat.

C’est la règle qui nous évite 90 % des fausses bonnes idées.

Avant d’ajouter de l’IA, il faut accepter une réalité simple : 80 % des logiciels métiers ne sont pas prêts. Pas pour des raisons techniques mais pour des raisons structurelles.

Voici les trois signaux qui, chez Yield, déterminent en 15 minutes si un projet IA est réaliste… ou voué à s’écraser.

Une IA ne “déduit” rien : elle reproduit.

Si votre règle métier dépend de la personne qui traite le dossier, l’IA va juste rendre la confusion plus rapide.

L’indicateur implacable ? Si on vous demande “ça dépend du contexte” plus de deux fois, on arrête tout.

On n’a pas besoin de Big Data. On a besoin de données cohérentes : mêmes champs, mêmes formats, même logique.

Vous êtes prêts si :

Vous ne l’êtes pas si :

L’IA n’aime pas :

On ne demande pas une architecture parfaite.

On demande un système où chaque étape existe pour une raison.

🔍 Test Yield

Demandez à un dev : “On trace où le flux complet d’une action utilisateur ?”

S’il hésite, ce n’est pas prêt.

L’erreur classique : “on ajoute un endpoint IA et on verra”.

Résultat ? La feature marche en démo, explose en production, et personne ne comprend pourquoi l’IA donne des réponses différentes le mardi et le jeudi.

Voici la méthode qui évite 95 % des dérives - celle qu’on applique dans tous les projets IA métier que l’on pilote.

On ne part jamais d’un modèle (“on veut du GPT-4o”).

On part d’un geste utilisateur qui fait perdre du temps.

Un seul.

Exemples :

Si l’irritant n’est pas mesurable → on arrête tout de suite.

On teste l’IA hors du produit, dans un bac à sable.

Le but, c’est de vérifier que le modèle comprend vraiment votre métier avant d’écrire une ligne de code côté application.

Ce proto permet de valider :

Quand ça tient 30 cas d’usage réels → seulement là, on intègre.

Dans un logiciel métier, l’IA ne doit jamais :

On utilise l’IA comme :

Mais l’utilisateur reste le gardien du workflow.

Une intégration IA sans traçabilité, c’est un ticket support assuré dans la semaine.

Au minimum :

Ça permet de comprendre où le modèle se trompe, pourquoi, et comment l’améliorer sans deviner.

Jamais en big bang.

Toujours avec un groupe pilote métier qui vit la réalité du terrain.

Lorsqu’on déploie une feature IA chez Yield :

C’est ce cycle qui transforme une bonne idée IA en feature réellement adoptée.

💡 Règle Yield

Une IA utile doit survivre à trois tests :

L’IA ne transforme pas un logiciel par magie.

Elle accélère ce qui est clair, expose ce qui est flou et amplifie tout ce qui était déjà fragile.

Les intégrations IA qui fonctionnent en 2025 sont celles qui :

Le reste - les assistants “génériques”, les features gadget, les démos qui font briller les yeux - disparaît dès la première semaine d’usage réel.

Chez Yield, on conçoit des intégrations IA qui tiennent en prod, parce qu’elles sont pensées pour le métier : pré-remplissage, résumé, extraction, recherche sémantique, routage, détection d’anomalies… des briques concrètes, mesurables, qui font gagner du temps dès le jour 1.

👉 Vous envisagez d’intégrer l’IA dans votre logiciel métier ? On peut vous aider à cadrer les cas d’usage, sécuriser l’intégration et transformer l’IA en vrai levier opérationnel - pas en effet d’annonce.

“L’IA va remplacer les développeurs.” Vous l’avez entendu aussi ? Mais dans le développement logiciel sur-mesure, la réalité est autre. Les projets sont complexes, spécifiques, souvent construits from scratch. Pas question de générer une app complète en trois prompts.

En revanche, ce qu’on voit très concrètement chez Yield, c’est autre chose :

Pas besoin de former une AI Squad ni de tout repenser. Mais avec les bons outils, et les bonnes idées, l’IA devient un levier très concret pour mieux documenter, mieux tester, mieux comprendre les données, mieux collaborer produit / dev / métier.

Dans cet article, on partage 5 cas d’usage IA réellement utiles dans des projets web sur-mesure. Testés, adoptés, adaptables.

Le développement logiciel sur-mesure, ce n’est pas juste “coder une app” — c’est comprendre un besoin spécifique, poser une architecture propre, livrer avec qualité… souvent dans des environnements métier complexes.

👉 Et c’est justement là que l’IA peut faire la différence : pas pour remplacer les développeurs, mais pour accélérer, fiabiliser, et documenter là où ça compte.

Ce qu’on voit sur le terrain, côté Yield :

⚠️ Mais tout ça ne marche que si :

💡 Ce qu’on répète souvent : une IA bien utilisée, c’est une IA qui fait gagner du temps sans créer de dette.

Certaines tâches reviennent encore et encore : créer des modèles CRUD, poser la base d’un composant frontend, générer une couche d’API ou d’accès aux données… Rien de complexe — mais beaucoup de copier-coller.

👉 Avec des prompts bien calibrés, une IA comme GPT-4 peut :

Retour d’XP :

“Sur un projet d’outils RH, on utilisait un prompt maison pour générer les services backend à partir du modèle métier. Ça nous a vraiment accélérés sur la mise en place. Et comme c’était relu derrière, on gardait la maîtrise technique.”

— Simon, Lead Dev @Yield Studio

⚠️ À garder en tête :

Bien utilisé, c’est un vrai booster sur les phases d’amorçage — surtout sur des architectures déjà balisées (Clean Architecture, DDD light…).

Écrire des tests est essentiel — mais reste parfois perçu comme une contrainte. Et sur des projets où les deadlines sont serrées, c’est souvent le premier poste sacrifié. Pourtant, bien accompagnée, l’IA peut réduire drastiquement le temps passé à écrire les tests… sans rogner sur leur qualité.

Concrètement, elle peut servir à :

Retour d’XP :

“Sur une plateforme de contrats, on a demandé à GPT de générer des tests à partir de nos scénarios Gherkin. C’était pas 100 % plug and play, mais ça posait déjà une bonne base. Le plus dur (la structure) était fait.”

— Claire, QA Engineer @Yield Studio

👉 L’IA est particulièrement utile pour les tests oubliés (erreurs, edge cases), pour produire vite une couverture de base sur un projet existant, pour onboarder une équipe dev sur un projet déjà lancé.

⚠️ À condition d’avoir :

Sur certains projets, surtout en phase de montée en charge, l’IA peut jouer un rôle inattendu : celui de coéquipier technique. Pas pour remplacer — mais pour soutenir le raisonnement, débloquer un problème, ou générer un brouillon de code plus vite.

Ce qu’on voit de plus en plus chez nos devs :

Le vrai gain ? On passe moins de temps à chercher, à scroller sur Stack Overflow ou à déchiffrer des documentations opaques. Et plus de temps à réfléchir à la structure du code et aux vrais enjeux du projet.

Retour d’XP :

“Nos devs juniors utilisaient Cursor pour les petits blocages du quotidien. C’est pas magique, mais quand tu galères sur une regex ou un parsing un peu relou, ça te fait gagner 30 minutes. Et côté seniors, on sentait que ça fluidifiait les revues.”

— Hugo, Engineering Manager @Yield Studio

⚠️ Limite à poser impérativement : ne pas “copier-coller” sans relire. L’IA peut halluciner, ou générer du code inutilement complexe. Chez Yield, on garde la règle : ce que l’IA propose, c’est un point de départ — pas un livrable.

La documentation est souvent le parent pauvre d’un projet logiciel. Manque de temps, flemme, ou difficulté à bien formuler ce qu’on fait… Résultat : des pages obsolètes, des README vides, des devs perdus en onboarding.

C’est là qu’un LLM bien utilisé peut faire gagner un temps précieux.

Cas concrets vus chez Yield :

👉 L’IA n’écrit pas la doc à votre place. Mais elle vous aide à passer le cap du “syndrôme de la page blanche”. Et à garder une base claire, lisible, accessible à tous.

Retour d’XP :

“Sur un SaaS santé, on avait branché un bot sur nos repos pour proposer un résumé de PR à chaque merge. C’était imparfait, mais hyper utile en relecture ou pour onboarder. On l’a vite gardé dans le process.”

— Lucie, Product Builder @Yield Studio

⚠️ Attention à la dérive “doc générée à l’aveugle”. Ce n’est pas parce que l’IA écrit bien qu’elle comprend. On garde la main pour valider — et on évite les formulations floues ou imprécises.

Tester une app avec des données factices, c’est souvent le cauchemar : prénoms bidons, dates incohérentes, données trop propres. Et pourtant, un bon jeu de test fait toute la différence pour détecter les bugs, simuler des cas limites… et valider des features avant la prod.

Là aussi, l’IA peut aider — si elle est bien cadrée.

Cas d’usage concrets :

👉 Utiliser un modèle GenAI ou une librairie boostée au prompt engineering permet de produire des jeux de données plus proches du réel, avec moins de scripts maison à maintenir.

Retour d’XP :

“L’IA nous a permis de générer des jeux de données métier avec des cas tordus (incohérences, doublons, profils incomplets). Pour la QA, c’était clairement un plus : on détectait plus de bugs, plus tôt.”

— Antoine, Tech Lead @Yield Studio

⚠️ On ne laisse pas un LLM créer n’importe quoi. On fixe des règles : format, cohérence, diversité. Et surtout, pas de données perso réelles en entrée. Jamais.

Utiliser l’IA dans un projet sur-mesure, ce n’est pas “suivre la tendance”. C’est identifier ce qui mérite d’être accéléré, enrichi, automatisé — sans sacrifier la qualité, la compréhension métier ou la maintenabilité.

👉 Générer du code, résumer un ticket, compléter un test, préparer un jeu de données : tous ces “petits” gains peuvent, à l’échelle d’un projet, transformer la vélocité.

Mais ça ne marche que si :

Chez Yield, on ne déploie pas l’IA pour faire joli. On l’utilise pour aider les équipes à aller plus vite sans créer de dette— sur des produits métier où la robustesse compte.

👉 Vous explorez l’IA dans un contexte dev ? On peut vous aider à cadrer les bons cas, outiller vos équipes, et avancer concrètement.

“On pourrait mettre de l’IA.” Une phrase qu’on entend souvent — et qui peut tout vouloir dire… ou rien.

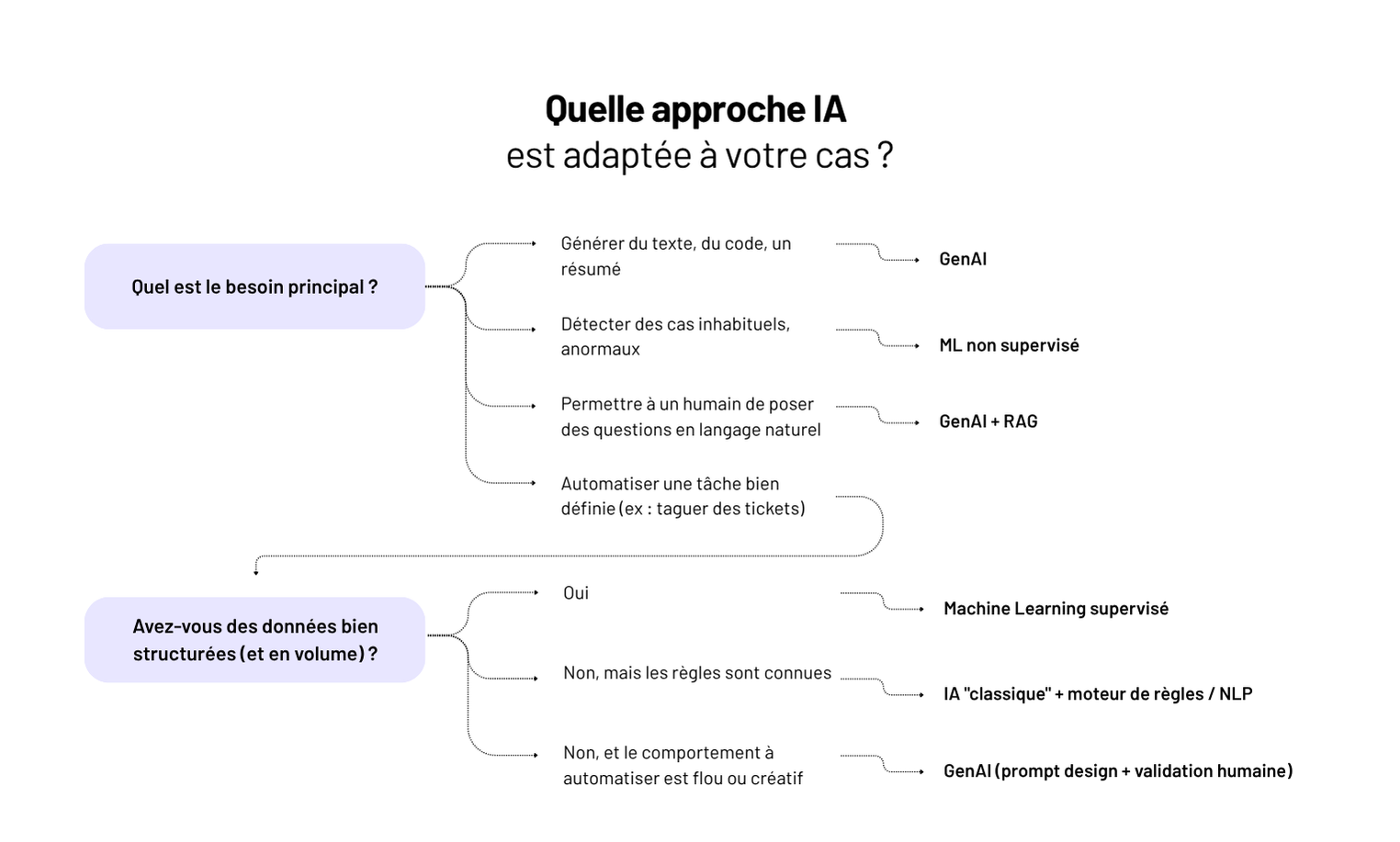

IA, machine learning, GenAI : trois termes partout, souvent mélangés, rarement compris. Et derrière, des décisions mal cadrées, des attentes floues, des projets qui patinent.

Chez Yield, on conçoit des produits web sur mesure. Et on intègre parfois de l’IA — mais jamais “pour faire de l’IA”. Seulement quand ça sert un usage, avec la bonne approche : algo maison, moteur ML, ou API GenAI.

Dans cet article, on vous aide à poser les bases :

👉 Pour faire de bons choix, mieux vaut comprendre les fondamentaux — que suivre la hype.

C’est le concept global : faire exécuter à une machine des tâches qu’on associe à de l'intelligence humaine.

👉 Exemples : reconnaître des visages, classer des documents, planifier un itinéraire…

Mais c’est un terme fourre-tout. Tout ce qui est “un peu intelligent” y passe : moteur de règles, chatbot basique, modèle prédictif…

C’est un sous-domaine de l’IA. Ici, la machine apprend à partir de données : elle ne suit pas des règles codées à la main, elle déduit des modèles à partir d’exemples.

👉 Exemples :

Il faut des données propres, structurées, suffisantes. Le ML est puissant, mais exigeant en préparation.

C’est une autre branche : générer du texte, des images, du code, du son… à partir d’une consigne.

Elle repose souvent sur des LLMs (large language models), comme GPT, Claude ou Mistral.

👉Exemples :

À retenir :

Plutôt qu’un débat théorique, mieux vaut partir des problèmes concrets qu’on cherche à résoudre — et voir quelle approche IA/ML/GenAI est adaptée.

👉 Machine Learning supervisé

Exemple : classer des factures, des contrats, des CV.

On entraîne un modèle sur des données labellisées (ex. : “facture EDF”, “contrat freelance”) → il apprend à généraliser.

👉 IA “classique” ou règles + NLP

Exemple : chatbot support qui répond à “Comment changer mon mot de passe ?”

On peut combiner détection d’intention, règles et base de connaissance. Pas besoin de GenAI.

👉 IA générative (LLM)

Exemple : un PM veut un résumé de 15 retours clients.

Un modèle comme GPT peut générer une synthèse exploitable, ou reformuler dans le ton de marque.

👉 Machine Learning non supervisé

Exemple : détection de factures atypiques, d’abus d’usage, ou d’activité incohérente.

Le modèle apprend la “norme” et alerte quand on s’en écarte.

👉 IA générative + intégration métier

Exemple : “Combien d’inscrits en mai par canal d’acquisition ?”

Un LLM traduit la question en requête sur la base de données — à condition d’avoir un schéma clair + couche de validation.

💡La clé, ce n’est pas “quelle techno est la plus puissante ?” mais “quelle techno résout votre problème avec le bon ratio effort/valeur ?”

Quand on intègre de l’IA, du ML ou de la GenAI dans une app, on ne parle plus d’une feature classique. Côté produit, il faut changer de posture : cadrer l’imprévisible, piloter par la valeur, et assumer une logique d’exploration.

Une IA ne répond pas à “je veux automatiser ça” mais à “dans 80 % des cas, je veux éviter cette tâche”.

👉 Il faut traduire le besoin en cas d’usage clair, observable, avec un critère de succès réaliste. Pas une promesse floue d’intelligence.

Pas de “ça marche / ça marche pas”. Il faut accepter du bruit, cadrer la tolérance à l’erreur, tester avec des données réelles.

➡️ On parle d’évaluation continue, pas de validation en spec.

Une GenAI qui hallucine ? Un modèle qui dérive ? Le rôle du PM, c’est aussi de définir les garde-fous : seuils, fallback, formulation des prompts, contexte affiché, etc.

👉 Une UI d’IA sans cadrage, c’est une UX qui déçoit — voire un produit inutilisable.

Ce n’est pas une story = une PR. Il faut maquetter, tester vite, jeter si besoin.

💡 Chez Yield, on pose souvent un sprint 0 orienté “preuve de valeur” — pas de specs, juste : cas d’usage, données, test simple, go/no go.

Adopter une démarche IA ou ML, ce n’est pas “ajouter une techno”. C’est changer la manière de penser, concevoir, et livrer un produit. Et ça suppose des responsabilités bien réparties dans l’équipe.

On ne spécifie pas une IA comme un formulaire. Il faut cadrer autrement :

👉 Le PM devient l’orchestrateur de scénarios probabilistes, pas de parcours figés.

Utiliser un LLM ou un modèle ML, ce n’est pas juste un appel d’API.

👉 Un système IA bien conçu, c’est observable, testable, rollbackable.

👉 On design une expérience, pas juste une réponse IA.

Un produit IA, ça s’entraîne, ça s’ajuste, ça évolue.

👉 Chez Yield, on pose une gouvernance claire : ownership produit, cycle d’itération court, monitoring live.

💡 Ce qu’on voit : une bonne équipe IA, ce n’est pas une cellule d’experts. C’est une équipe pluridisciplinaire qui accepte l’incertitude — et sait structurer autour.

Pas besoin d’un LLM maison ou d’un data lake à six zéros pour intégrer de l’IA dans un produit. Mais il faut faire les bons choix — sinon, vous multipliez les coûts, les risques, et la dette technique.

Vous pouvez vous appuyer sur des modèles existants (OpenAI, Hugging Face, Claude, etc.) ou construire en interne.

RAG, vecteurs, orchestrateurs (LangChain, LlamaIndex…), monitoring, guardrails… Une bonne stack IA, ce n’est pas “juste un appel à l’API”. C’est un système à concevoir comme un morceau d’architecture produit.

Attention aux prestataires IA “full blackbox” ou aux intégrations magiques promises en 3 jours. Une bonne intégration IA, ça se pense côté métier, côté dev, et côté usage — pas juste côté algo.

💡 Ce qu’on fait chez Yield :

Quel est le problème métier précis à résoudre ?

Pas “faire de l’IA” — mais gagner du temps, réduire des erreurs, améliorer l’expérience.

Les données nécessaires existent-elles ?

Modèle ML = données propres + étiquetées. GenAI = contexte clair + prompt bien formulé.

Quel niveau de tolérance à l’erreur est acceptable ?

Une prédiction à 90 % ? Une génération de texte imprécise ? Il faut cadrer ça dès le départ.

Le résultat est-il explicable, actionnable ?

Un utilisateur ne doit jamais se demander “pourquoi ça a répondu ça”.

Le ROI est-il mesurable ?

Gain de temps ? Moins de support ? Conversion augmentée ? Un bon projet IA s’évalue, pas juste “s’impressionne”.

💡 Vous n’avez pas besoin d’un modèle maison. Vous avez besoin d’un problème clair + solution testable.

IA, ML, GenAI… Derrière les buzzwords, une réalité simple : ces technologies peuvent vraiment transformer un produit — si on les intègre avec méthode.

Ce n’est pas un effet de mode. C’est un levier à intégrer dans une stratégie produit claire :

Chez Yield, on ne vend pas de promesse “AI-first”. On conçoit des produits utiles, testables, maintenables — avec ou sans IA.

Vous avez un cas d’usage IA à structurer, ou une opportunité GenAI à valider ? On peut vous aider à faire les bons choix. Sans bullshit. Et sans dette.