Agence de développement web

L'agence n°1 de développement web

sur-mesure pour PME & ETI

Depuis 2019, notre culture Lean nous permet de mettre en production 98% des applications web de nos clients en moins de 3 mois, le tout avec un code de grande qualité.

Ils nous font confiance — 250+ projets livrés

Découvrez nos réalisations clients

Voir tous les cas clients ›

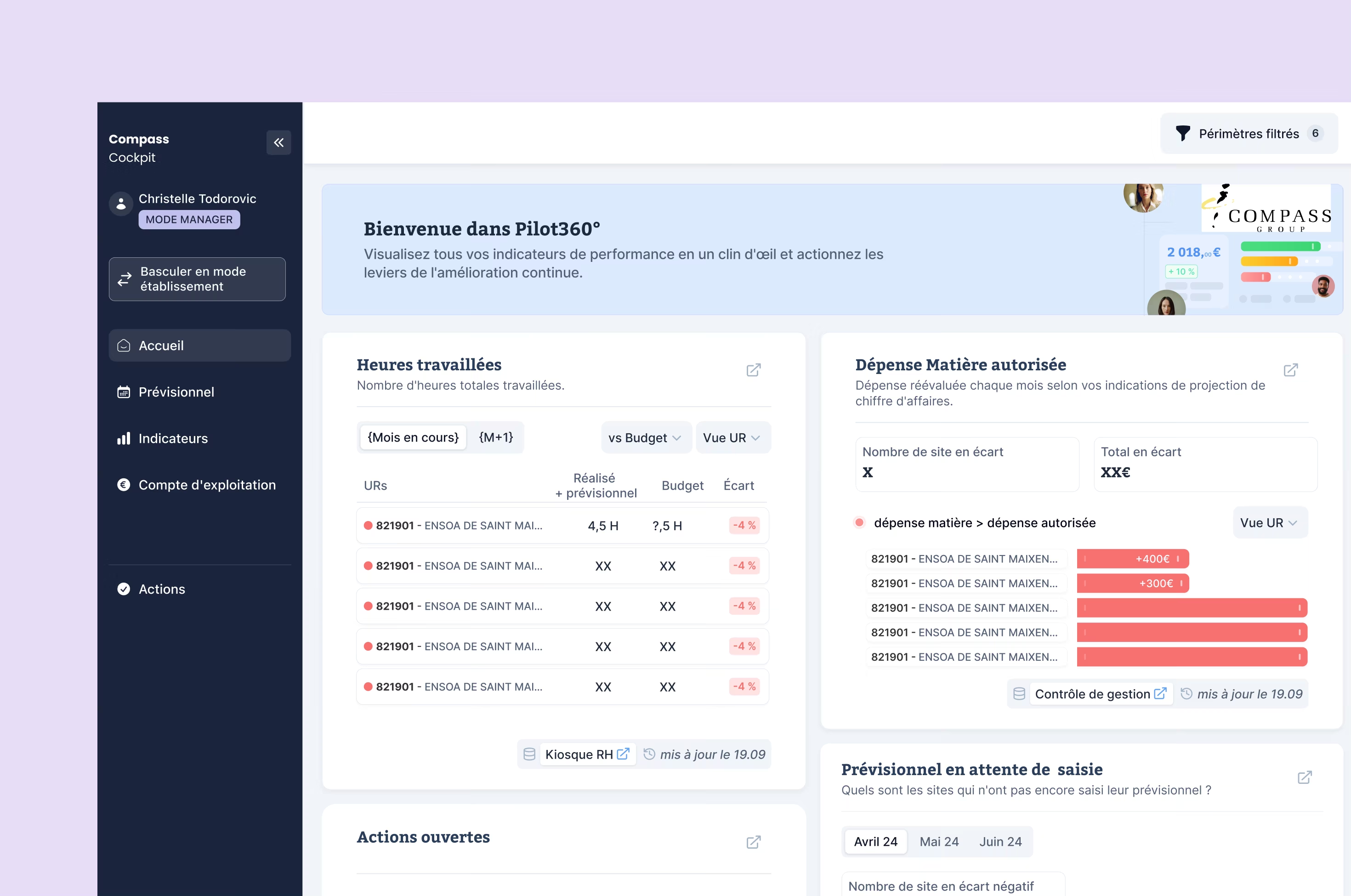

Compass Group

Conception et développement d'un cockpit data de pilotage P&L pour le leader mondial de la restauration collective (>40 pays), centralisant la performance de milliers de restaurants en temps réel.

Voir le cas client ›

Groupe Legrand Automobile

Accélérer la performance digitale d'un groupe automobile multi-activités à 317 M€ de chiffre d'affaires

Voir le cas client ›

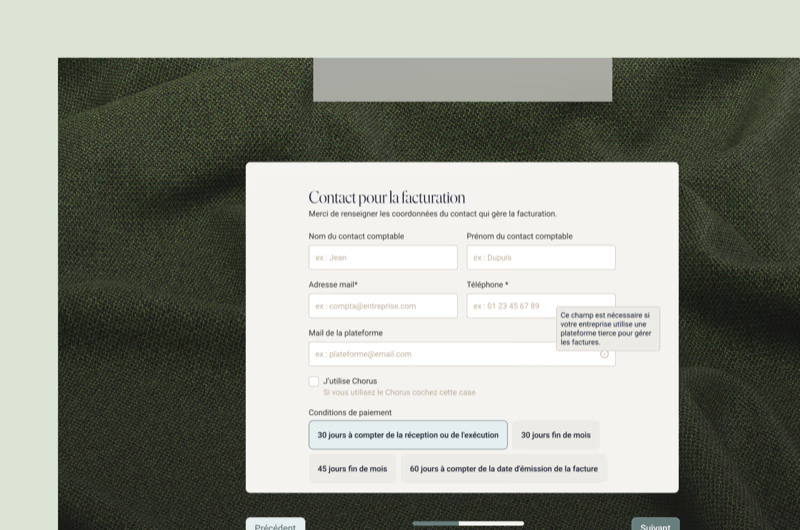

Kinnarps

Digitalisation complète du parcours de commande B2B (devis, signature électronique, suivi) pour un groupe international du mobilier professionnel (1 800+ collaborateurs, présent dans 40 pays), en environnement on-premise.

Voir le cas client ›

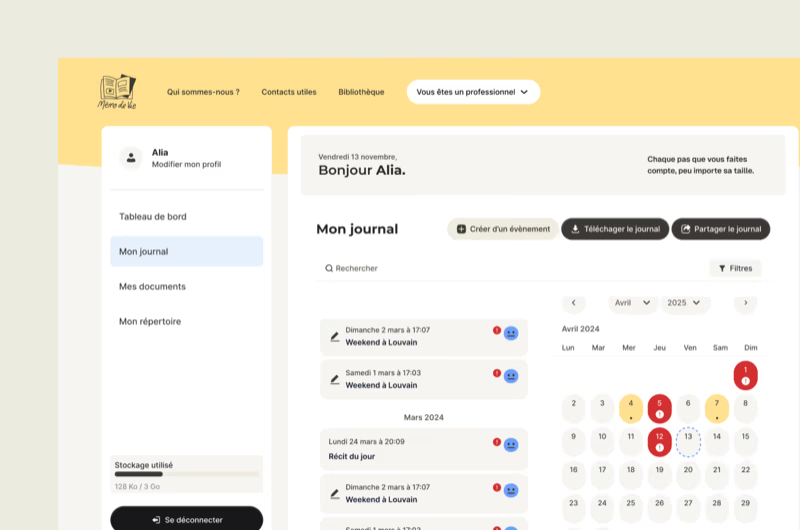

Mémo de Vie

Plateforme web et mobile à fort impact sociétal pour les victimes de violences, conçue en 4 mois après une phase de discovery approfondie, et mise en lumière au JT de TF1.

Voir le cas client ›

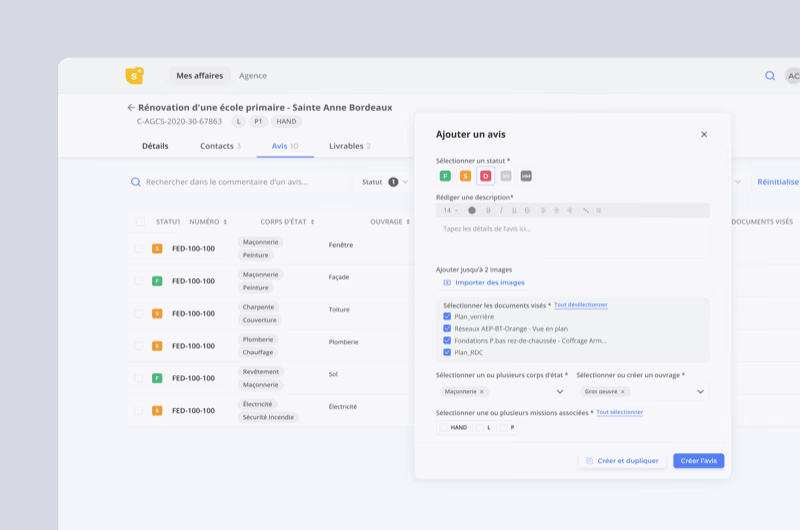

BTP Consultants

DSI externalisée sur 3 ans avec création d'un socle applicatif et de plusieurs applications métiers intégrant l'IA, réduisant de 95 % les coûts de maintenance et augmentant la productivité de 20 %.

Voir le cas client ›

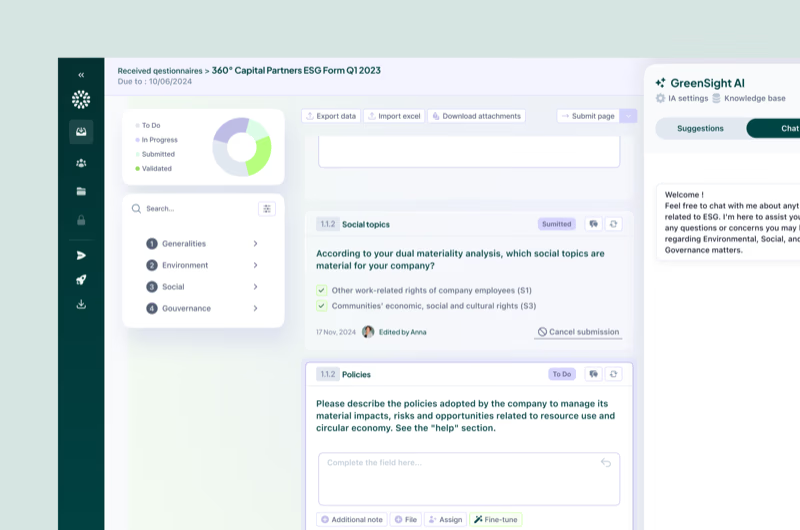

Greenscope

Accompagnement sur l'intégration d'IA dans un SaaS pour un acteur en forte croissance, avec une levée de fonds de 3 M€.

Voir le cas client ›

JPB Systeme

Développement d'un SaaS IoT de supervision d'équipements industriels connectés pour des acteurs industriels et de loisirs à forts enjeux opérationnels (Parc Astérix…).

Voir le cas client ›

Média Participations

Conduite de 5 projets de refonte SI structurants en 12 mois pour un groupe média de référence (Spirou, Dupuis…).

Voir le cas client ›96% de nos clients continuent avec nous

“La réactivité et l’implication dans nos projets sont un gros plus.”

Erwin LEGRAND, Directeur Marketing

“Très efficaces sur les développements et de précieux conseils.”

Simon TANNAI, Cofounder & CTO

Nos technologies web

Nous livrons vite, mais bien : un delivery accéléré grâce à l'IA générative (code review, tests automatisés, génération assistée), aux sprints courts et aux intégrations intelligentes, tout en garantissant un code maintenable et sécurisé.

+40 technologies et frameworks couverts

Améliorons votre expérience client ou collaborateur

Notre objectif n'est pas simplement de développer une liste de fonctionnalités. Nous visons l'adoption des utilisateurs et l'atteinte de vos objectifs business (augmentation de la productivité ou de la satisfaction clients, augmentation des ventes, ...).

Là où certaines agences suivent strictement le processus de développement et considèrent les besoins des utilisateurs ou le socle technique comme des contraintes, nous chez Yield Studio, on fait l'inverse.

Discutons de votre projet web dès maintenant →Une approche en 5 phases

Compréhension utilisateur

Identification des problématiques de vos utilisateurs, de vos enjeux clés à travers l'écoute active et l'analyse de marché pour cadrer le projet.

1 à 3 semainesConception & Prototypage

Création de maquettes et prototypes interactifs, testés et améliorés grâce aux retours des utilisateurs pour garantir une solution répondant à leurs attentes.

2 à 4 semainesDéveloppement agile

Codage de votre application web en sprints d'une semaine, permettant des ajustements flexibles basés sur des tests en conditions réelles. A la fin de chaque sprint une revue est organisée ensemble.

6 à 12 semainesTests & améliorations

Assurer la qualité et la performance de l'application par des tests rigoureux en conditions réelles, en prenant en compte des retours pour des ajustements.

1 à 3 semainesItérations

Mettre votre produit en ligne et effectuer des itérations basées sur les retours, les datas et les évolutions du marché. Retour à l'étape 1 pour focus une autre problématique !

Focus sur quelques fonctionnalités phares développées pour nos clients

Nous créons des fonctionnalités sur-mesure qui répondent aux besoins spécifiques de chaque projet web, qu'il s'agisse de plateformes SaaS, de logiciels métiers ou de sites complexes.

Portails client personnalisés

espaces sécurisés offrant des dashboards interactifs, accès aux données en temps réel, et outils de collaboration dédiés.

Systèmes de reporting avancés

génération de rapports dynamiques, visualisations de données complexes et exports personnalisés.

Automatisation de processus métiers

développement de workflows sur-mesure pour simplifier et optimiser vos processus internes.

Intégrations d'API & webhooks

connexion fluide avec vos ERP, CRM, solutions de paiement ou services tiers pour une interopérabilité totale.

Sécurité & Performance

systèmes de gestion des permissions, cryptage des données, monitoring des performances et maintenance proactive.

Vivez enfin une expérience client 5✦ sans risque et garantie

La croissance fulgurante d’une agence de développement web & mobile autofinancée

Voir la parution ›

Interview de Cyrille ADAM, Co-fondateur de Yield Studio, sur le développement de l’agence

Voir la parution ›

Si l’App Store a trop de concurrents, les utilisateurs risquent de se perdre

Voir la parution ›

Développement logiciel : les entreprises sont à la ramasse et ça coûte (très) cher

Voir la parution ›

Le pari réussi des développeurs séniors à l’ère de l’IA

Voir la parution ›Nos expertises en Développement Web & IA

Création d'application web

Lancer une application web performante va bien au-delà du simple développement d'interface. Chez Yield Studio, nous vous accompagnons dès la conception pour créer des applications web sur mesure, qu'il s'agisse d'applications web métier pour automatiser vos processus internes et améliorer votre productivité, d'applications SaaS évolutives pensées pour répondre aux besoins spécifiques de vos utilisateurs, ou encore de sites web complexes offrant une expérience utilisateur optimisée grâce à une architecture robuste et une conception sur mesure.

Refonte d'applications web

Une application vieillissante ou un site web obsolète peut freiner votre croissance. Nous vous aidons à moderniser vos applications en repensant leur architecture technique, en améliorant leurs performances, leur design et leur scalabilité. Notre approche se concentre sur la mise à jour de vos outils pour offrir une expérience utilisateur optimale tout en garantissant une maintenance simplifiée et une capacité d'évolution sur le long terme.

Tierce Maintenance Applicative (TMA)

Un code mal structuré entraîne des bugs, des lenteurs et des dettes techniques qui peuvent nuire à l'efficacité de votre application. Nos experts réalisent des audits complets pour évaluer l'état de votre application, identifier les goulots d'étranglement, et proposer des améliorations concrètes.

Notre objectif : Vous garantir un code fiable, maintenable et prêt à évoluer sans friction. Grâce à une maintenance rigoureuse et proactive, nous veillons à ce que votre application reste performante et sécurisée au fil du temps.

Questions fréquentes

Créer un bon logiciel, ce n'est pas juste une affaire de code. C'est une affaire de compréhension métier, d'arbitrages stratégiques et d'exécution sans faux pas. Faire appel à une agence de développement web, c'est s'entourer d'une équipe capable de transformer un besoin business en produit numérique robuste, scalable et réellement utilisé. Chez Yield Studio, on ne se contente pas de livrer une app fonctionnelle. On co-construit un outil qui crée de la valeur dès le jour 1. Concrètement, une agence spécialisée vous aide à cadrer le projet avant d'écrire une ligne de code, concevoir des interfaces testées et adaptées aux vrais utilisateurs, choisir les bonnes technos pour éviter la dette technique, et développer rapidement sans sacrifier la qualité grâce à une organisation Lean & Agile. Et quand 98 % des logiciels qu'on lance arrivent en production en moins de 3 mois, ce n'est pas un hasard. C'est une méthode.

Une appli web qui ne sert pas votre business, c'est juste un budget cramé. Chez Yield, on ne développe pas pour cocher des cases. On conçoit des outils qui résolvent un vrai problème métier. Gagner du temps. Générer du chiffre. Améliorer l'expérience utilisateur. Notre approche ? Aligner le produit sur vos objectifs business dès le départ : quel est le problème à résoudre ? Quel indicateur doit bouger ? Comment mesurer le succès du produit ? Une bonne appli, ce n'est pas juste un code propre. C'est un outil qui pousse votre business dans la bonne direction.

Tout dépend de ce qu'on construit. Un outil interne avec peu d'écrans ? Quelques semaines. Une plateforme SaaS avec paiement, dashboard, et gestion des droits ? Plutôt 3 à 6 mois. Chez Yield, on distingue trois phases clés : cadrage & prototypage (2 à 4 semaines), développement agile (6 à 12 semaines), stabilisation & itérations (2 à 4 semaines). Résultat : un MVP fonctionnel en production en moins de 3 mois dans 98 % des projets.

La vraie question, ce n'est pas combien ça coûte. C'est : combien ça rapporte ? Chez Yield, on vous accompagne à partir de 40k€. Le coût dépend de la complexité fonctionnelle, du nombre d'utilisateurs, et des intégrations nécessaires. Notre approche : cadrer rapidement votre besoin avec un Product Design Sprint. En une semaine, vous repartez avec une vision claire, un prototype testable… et un devis argumenté.

Tout dépend de ce que vous voulez construire. Et surtout : pourquoi. Vous créez un outil interne ? On privilégie la simplicité, la robustesse, la rapidité de dev. Un SaaS à fort volume ? Place à l'architecture scalable, aux API bien pensées, à la perf serveur. Chez Yield, chaque ligne de code est alignée avec une contrainte réelle. Pas de techno gadget. Juste ce qu'il faut pour livrer vite, bien, et durable.

Un bon cahier des charges, c'est un point de départ stratégique, pas un document figé. Il doit répondre à trois questions clés : quel problème métier doit-on résoudre ? Quelles sont les contraintes ? Quel est le budget-cible ? Notre méthode ? Le Product Design Sprint. En 5 jours, on transforme votre idée en un prototype testé par de vrais utilisateurs, avec un backlog fonctionnel priorisé.

Échangeons sur votre projet !

30 minutes, gratuit, sans engagement.

Nous contacterAppel de 30 min → Audit gratuit → Proposition sous 5 jours