Agence Intelligence Artificielle

L'agence n°1 d'intelligence artificielle

pour PME & ETI

Intégrez l'IA dans vos processus métier en moins de 3 mois. Agents IA, automatisation et analytics prédictifs, garantis par notre méthodologie Lean.

Ils nous font confiance — 250+ projets livrés

Nos cas clients en intelligence artificielle

Voir tous les cas clients ›

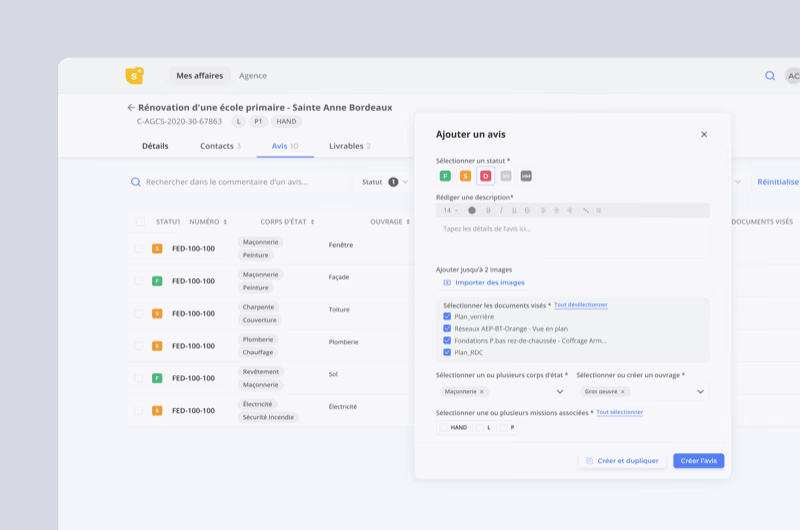

BTP Consultants

Logiciels métiers augmentés par l'IA — réduction de 95 % des coûts d'exploitation grâce à l'automatisation intelligente.

Voir le cas client ›

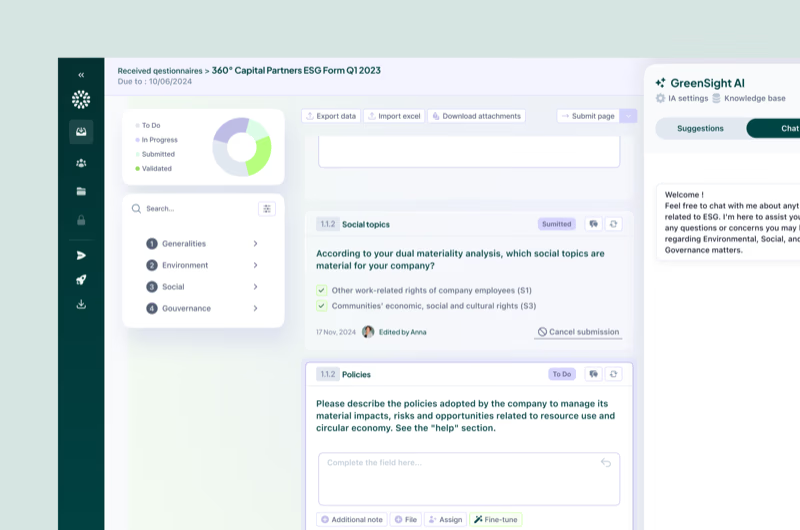

Greenscope

Intégration d'IA dans un SaaS GreenTech en forte croissance, avec une levée de fonds de 3 M€.

Voir le cas client ›

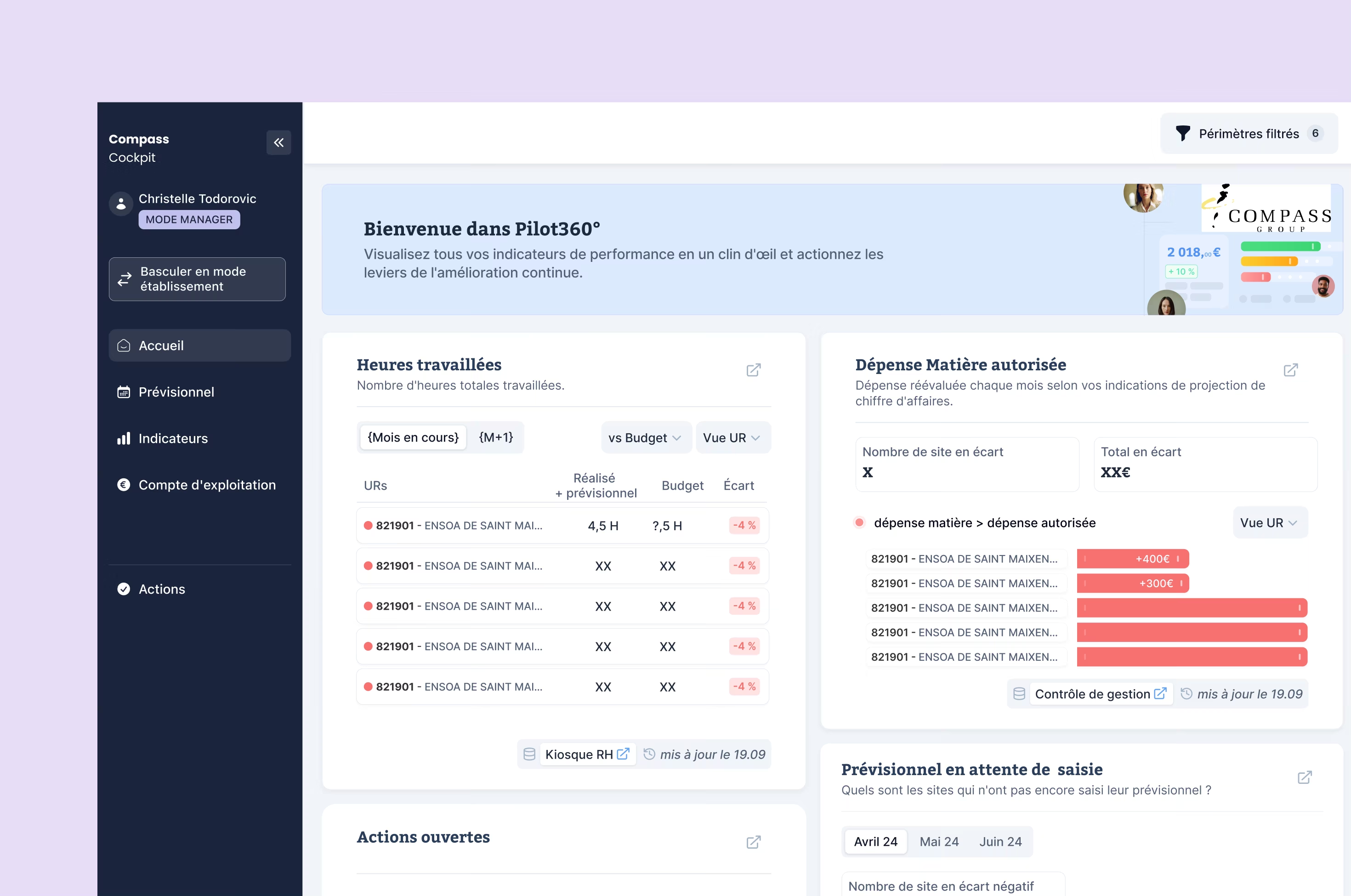

Compass Group

Traitement intelligent de la data pour un leader mondial de la restauration collective (500 000 collaborateurs).

Voir le cas client ›

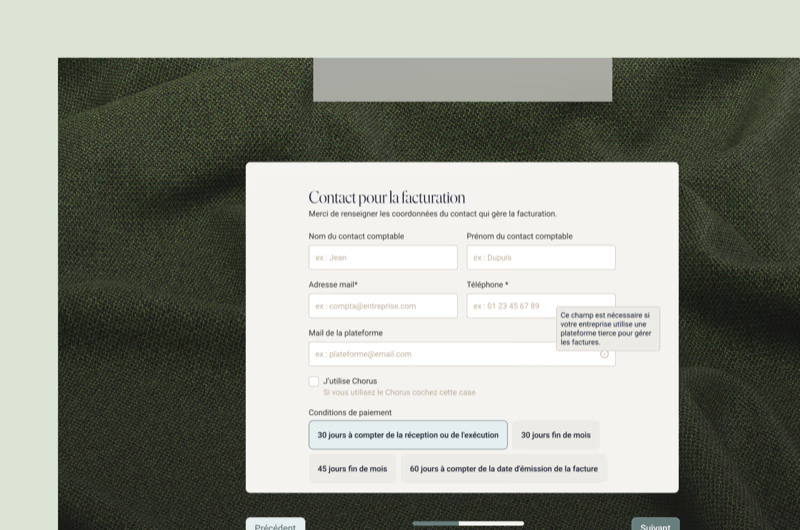

Kinnarps

Digitalisation du parcours client B2B intégrant de l'IA prédictive pour un groupe international (1 800 collaborateurs).

Voir le cas client ›96% de nos clients continuent avec nous

“Ils ont eu énormément d’impact sur le traitement de la data.”

Julien GOUPIT, Directeur Innovation

Nos technologies IA & Data

Nous livrons vite, mais bien : des solutions IA en production grâce à notre expertise en LLM (GPT, Claude, Mistral), frameworks ML (PyTorch, scikit-learn), et infrastructure cloud (AWS, GCP), tout en garantissant des modèles fiables, explicables et conformes RGPD.

Python

Python LangChain

LangChain OpenAI

OpenAI Anthropic

Anthropic Hugging Face

Hugging Face TensorFlow

TensorFlow PyTorch

PyTorch AWS

AWS Google Cloud

Google Cloud Mistral AI

Mistral AI LlamaIndex

LlamaIndex FastAPI

FastAPI+20 technologies et frameworks IA couverts

L'IA au service de votre performance, pas l'inverse

Chez Yield Studio, l'intelligence artificielle n'est jamais un gadget marketing. Nos ingénieurs IA ultra-seniors conçoivent chaque solution avec un seul objectif : maximiser la valeur métier et le ROI.

Zéro effet de mode, zéro hallucination en production — une IA maintenable, explicable, performante et rentable sur le long terme.

Discutons de votre projet IA dès maintenant →Une méthodologie éprouvée en 5 phases

Audit Data & Discovery

Identification de vos cas d'usage IA à fort ROI et audit de vos données existantes pour garantir la faisabilité technique et business.

1 à 3 semainesPOC & Prototypage

Proof of concept fonctionnel pour valider la pertinence du modèle IA et mesurer les premiers résultats avant de lancer l'industrialisation.

2 à 4 semainesIndustrialisation agile

Développement de la solution IA en sprints courts avec métriques de performance (précision, recall, latence). Pipeline MLOps et tests automatisés.

6 à 12 semainesTests & Validation

Validation des modèles en conditions réelles, tests de robustesse, audit des biais et conformité RGPD avant mise en production.

1 à 3 semainesMonitoring & Itérations

Surveillance continue des performances modèles, détection des drifts, réentraînement planifié et intégration de nouveaux cas d'usage IA !

Focus sur quelques cas d'usage IA déployés pour nos clients

Nous concevons des solutions IA sur-mesure qui répondent à des problématiques métier concrètes et génèrent un ROI mesurable dès les premières semaines.

Agents IA & Chatbots intelligents

assistants conversationnels capables de traiter les demandes clients, qualifier des leads ou automatiser le support interne 24/7.

Automatisation & Workflows IA

élimination des tâches manuelles répétitives grâce à des pipelines intelligents : extraction de documents, classification, routage automatique.

Analytics prédictifs & Data Engineering

structuration de vos données brutes en insights actionnables : dashboards temps réel, scoring prédictif et aide à la décision data-driven.

IA Générative & LLM sur-mesure

fine-tuning de modèles de langage sur vos données métier : génération de contenus, recherche sémantique, résumé automatique et RAG.

Vivez enfin une expérience client 5✦ sans risque et garantie

La croissance fulgurante d’une agence de développement web & mobile autofinancée

Voir la parution ›

Interview de Cyrille ADAM, Co-fondateur de Yield Studio, sur le développement de l’agence

Voir la parution ›

Si l’App Store a trop de concurrents, les utilisateurs risquent de se perdre

Voir la parution ›

Développement logiciel : les entreprises sont à la ramasse et ça coûte (très) cher

Voir la parution ›

Le pari réussi des développeurs séniors à l’ère de l’IA

Voir la parution ›Nos expertises en Intelligence Artificielle & Data

Audit & POC — valider la faisabilité et le ROI

Immersion & Discovery — identification de vos cas d'usage IA à fort ROI et audit de vos données existantes pour garantir la faisabilité technique. Architecture & Stack — choix des technologies IA (Python, LangChain, OpenAI, modèles open-source) pour un socle ML/LLM robuste, sécurisé et évolutif. Prototypage & POC — proof of concept fonctionnel pour valider la pertinence du modèle IA avant de lancer le développement à grande échelle.

Industrialisation — du POC à la production

Méthodologie Lean Lab'® — cycles de développement courts avec métriques de performance IA (précision, recall, latence) pour des itérations rapides et mesurables. MLOps & Qualité — pipelines CI/CD pour modèles IA, monitoring des drifts et tests automatisés pour garantir la fiabilité en production. Visibilité totale — accès en temps réel à l'avancement du projet (Linear, Slack) pour une collaboration transparente.

Monitoring & Évolution — maintenir la performance

Monitoring & Réentraînement — surveillance continue des performances modèles, détection des drifts et réentraînement planifié pour maintenir la précision. Évolutions & Scalabilité — accompagnement continu pour intégrer de nouveaux cas d'usage IA selon la croissance de votre entreprise.

Sécurité & Conformité — RGPD, protection des données sensibles, audit des biais algorithmiques et hébergement souverain si nécessaire.

Nos experts à votre service

Questions fréquentes

Nous réalisons un audit data complet dès la phase de Discovery pour évaluer la qualité et le volume de vos données. Même avec peu de données, des approches comme le few-shot learning, le RAG (Retrieval-Augmented Generation) ou la génération de données synthétiques permettent de démarrer un projet IA performant. Notre objectif : identifier le chemin le plus court vers un premier résultat mesurable.

Nous mettons en place une infrastructure MLOps complète : monitoring continu des performances (précision, recall, latence), détection automatique des drifts de données, garde-fous contre les hallucinations et boucles de validation humaine. Chaque modèle est testé avec des jeux de données de référence avant chaque mise en production.

Un POC valide la faisabilité technique et le ROI potentiel sur un périmètre restreint. L'industrialisation implique des enjeux supplémentaires : scalabilité de l'infrastructure, pipelines de données automatisés, monitoring des modèles, gestion des versions et conformité réglementaire. Nous vous accompagnons sur les deux phases avec une méthodologie éprouvée pour passer du POC à la production sans accroc.

La sécurité des données est au cœur de chaque projet. Nous appliquons les principes du RGPD dès la conception : anonymisation et pseudonymisation des données d'entraînement, chiffrement bout-en-bout, hébergement souverain (OVH, Scaleway) si nécessaire, et possibilité de déployer des modèles on-premise pour les données les plus sensibles.

Un projet IA démarre à partir de 40 000 €. Un POC peut être livré en 4 à 6 semaines pour valider rapidement la valeur métier. Une solution complète en production est généralement déployée en 3 mois. Le budget dépend de la complexité des modèles, du volume de données et de l'infrastructure requise. Nous vous accompagnons dans le dimensionnement pour maximiser le ROI dès le premier euro investi.

Prêt à intégrer l'IA dans votre entreprise ?

30 minutes, gratuit, sans engagement.

Réserver un appel découverteAppel de 30 min → Audit gratuit → Proposition sous 5 jours