Tours Centre — Fondée en 2019

Agence de développement web

à Tours

Yield Studio est né à Tours en 2019. Depuis notre bureau au 1 Impasse du Palais, nous développons des applications web pour les PME et ETI de la région Centre-Val de Loire et de toute la France. Une expertise nationale, un ancrage local.

Entreprises qui nous font confiance depuis Tours

Le berceau de Yield Studio vous ouvre ses portes

Tramway Jean Jaurès à 3 min, gare de Tours à 10 min à pied. C'est ici que tout a commencé en 2019. Passez nous voir pour un atelier de cadrage, une démo produit, ou simplement échanger sur votre projet autour d'un café.

- Ateliers de conception en présentiel

- Démo produit chaque vendredi dans nos bureaux

- Formation de vos équipes sur place

- Bureaux ouverts du lundi au vendredi, 9h — 19h

96% de nos clients continuent avec nous

“La réactivité et l’implication dans nos projets sont un gros plus.”

Erwin LEGRAND, Directeur Marketing

“Très efficaces sur les développements et de précieux conseils.”

Simon TANNAI, Cofounder & CTO

Projets nés à Tours, déployés partout

Voir tous les cas clients ›

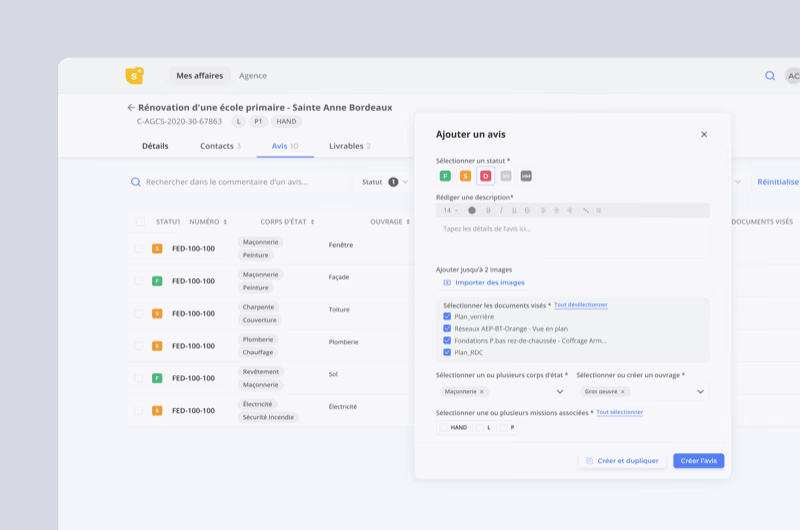

BTP Consultants

Notre tout premier client longue durée, accompagné pendant 3 ans depuis Tours : socle applicatif complet, applications métiers avec IA, -95 % de coûts de maintenance.

Voir le cas client ›

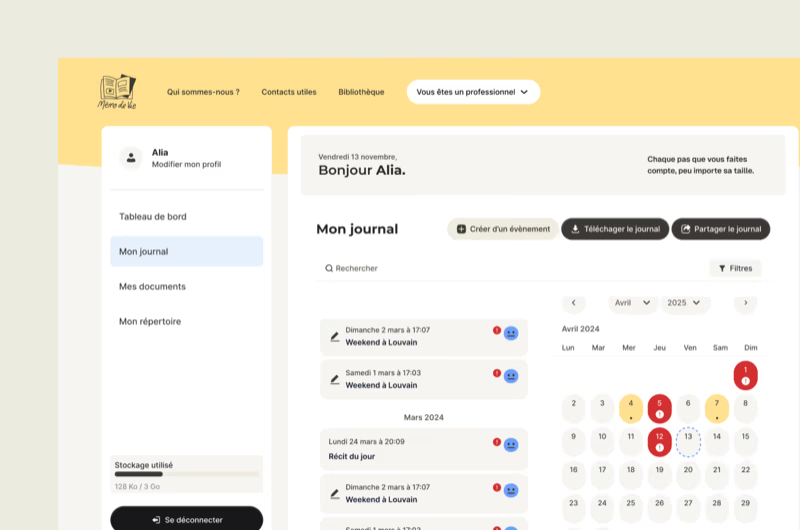

Mémo de Vie

Plateforme à fort impact sociétal conçue en 4 mois par notre équipe tourangelle. Le projet a été mis en lumière au JT de TF1 pour son aide aux victimes de violences.

Voir le cas client ›

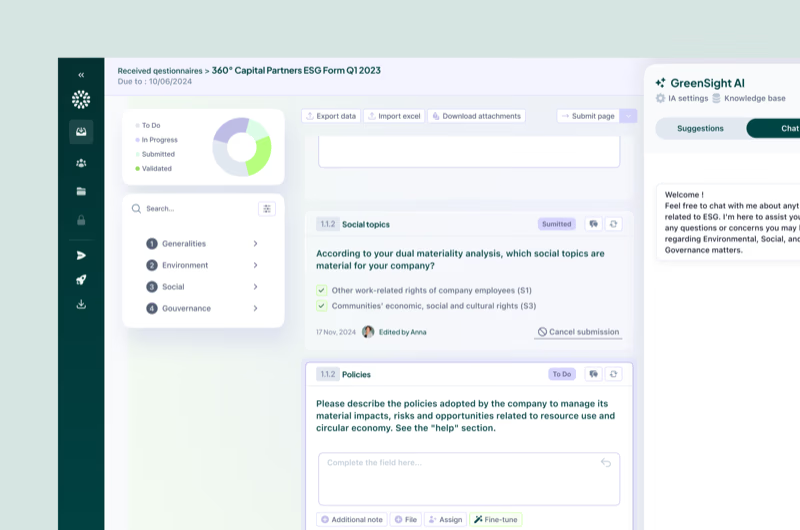

Greenscope

Intégration d'IA dans un SaaS pour cet acteur en forte croissance. Accompagnement qui a contribué à une levée de fonds de 3 M€.

Voir le cas client ›

JPB Systeme

SaaS IoT de supervision d'équipements industriels connectés pour des sites comme le Parc Astérix. Un projet industriel piloté depuis Tours.

Voir le cas client ›

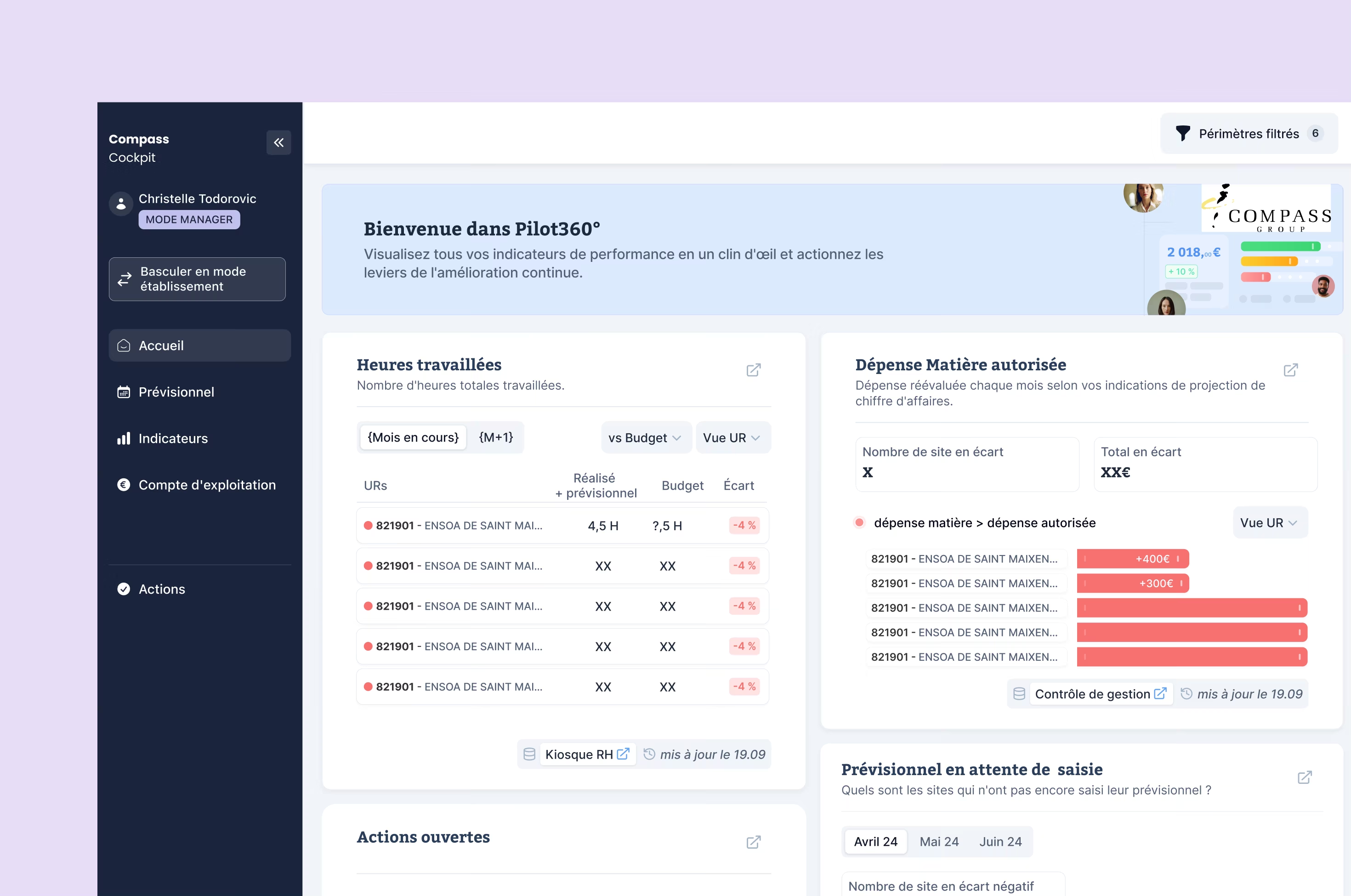

Compass Group

Cockpit data temps réel pour le leader mondial de la restauration collective. La preuve qu'on pilote des projets internationaux depuis la Touraine.

Voir le cas client ›

Groupe Legrand Automobile

Transformation digitale d'un groupe automobile à 317 M€ de CA. Refonte des outils métiers et unification du parcours client.

Voir le cas client ›Ce qu'on fait depuis Tours

Applications web & logiciels métiers

Depuis 2019 à Tours, nous concevons des applications web complètes pour les PME et ETI : logiciels métiers, SaaS, portails B2B. Les ateliers de cadrage en présentiel dans nos bureaux tourangeaux permettent de comprendre vos processus métier en profondeur avant d'écrire une ligne de code.

DSI externalisée pour PME

Pas de DSI en interne ? C'est le cas de beaucoup de PME de la région. Nous prenons en charge l'ensemble de votre stratégie technique : choix technologiques, développement, sécurité, maintenance. Un interlocuteur dédié basé à Tours, disponible en 24h pour un point en présentiel.

Conseil & audit technique

Avant de lancer un projet ou de moderniser un outil existant, un audit permet d'éviter les erreurs coûteuses. Nous évaluons votre code, votre infrastructure et vos processus, puis nous proposons une feuille de route claire et chiffrée.

Les besoins typiques des entreprises de la région

Les PME et ETI du Centre-Val de Loire que nous accompagnons ont des besoins concrets : digitaliser leurs processus, moderniser des outils vieillissants, ou lancer un nouveau produit digital sans prendre de risque.

Logiciels métiers sur-mesure

les entreprises industrielles et de services de la région ont des processus spécifiques. Nous créons des outils qui s'adaptent à votre métier, pas l'inverse.

Modernisation d'outils existants

beaucoup de PME tourangelles tournent encore sur des outils Excel ou Access. Nous les transformons en applications web modernes, sans interrompre votre activité.

Premiers pas dans le digital

vous n'avez pas d'équipe tech interne ? Nous jouons le rôle de DSI externalisée : pilotage, développement, maintenance. Un CTO dédié, à 10 min de vos bureaux.

Portails client & extranets

vos clients ou partenaires ont besoin d'un espace dédié pour suivre leurs commandes, consulter des documents, ou collaborer avec vos équipes.

Applications avec IA intégrée

l'IA n'est pas réservée aux startups parisiennes. Nous intégrons des fonctionnalités IA (analyse de documents, prédiction, automatisation) dans vos outils métiers existants.

Technologies maîtrisées par notre équipe Tours

Nous utilisons les mêmes technologies que les meilleures agences parisiennes, avec un avantage : des tarifs plus compétitifs sans compromis sur la qualité. Notre équipe tourangelle est composée de développeurs seniors avec 5 à 15 ans d'expérience.

+40 technologies et frameworks couverts

Comment ça se passe concrètement

Un café au bureau

On se retrouve au 1 Impasse du Palais, en plein centre de Tours. 1h pour comprendre votre besoin, vos contraintes et vous donner une première estimation. Pas de jargon, du concret.

1 journéeAteliers de conception

On travaille ensemble dans nos bureaux ou les vôtres. Maquettes, prototypes, tests utilisateurs. En 2 à 4 semaines, vous avez une vision claire de ce qu'on va construire.

2 à 4 semainesDéveloppement en sprints

Sprints d'une semaine avec démo chaque vendredi. Vous voyez le produit avancer et vous pouvez réorienter les priorités à tout moment. Pas de tunnel de 3 mois sans nouvelles.

6 à 12 semainesMise en production

Tests en conditions réelles, formation de vos équipes, déploiement progressif. On peut venir dans vos locaux à Tours pour former vos collaborateurs en personne.

1 à 3 semainesItérations & maintenance

Le produit est lancé. On continue ensemble : maintenance, évolutions, nouvelles fonctionnalités. Un point mensuel en présentiel pour garder le cap.

Vivez enfin une expérience client 5✦ sans risque et garantie

La croissance fulgurante d’une agence de développement web & mobile autofinancée

Voir la parution ›

Interview de Cyrille ADAM, Co-fondateur de Yield Studio, sur le développement de l’agence

Voir la parution ›

Si l’App Store a trop de concurrents, les utilisateurs risquent de se perdre

Voir la parution ›

Développement logiciel : les entreprises sont à la ramasse et ça coûte (très) cher

Voir la parution ›

Le pari réussi des développeurs séniors à l’ère de l’IA

Voir la parution ›Questions fréquentes

Notre bureau est au 1 Impasse du Palais, en plein centre-ville de Tours. À deux pas de la Place Jean Jaurès et du tramway. C'est le bureau historique de Yield Studio, là où l'agence a été fondée en 2019. Nous sommes ouverts du lundi au vendredi pour des rendez-vous, ateliers de cadrage ou démonstrations produit.

Nos tarifs sont les mêmes qu'on travaille depuis Paris ou Tours, car c'est la même équipe et la même qualité. La différence, c'est la proximité : si vous êtes basé en Centre-Val de Loire, vous avez une agence senior à 10 min de vos bureaux, pas à 2h de TGV. Nos projets démarrent à partir de 40 k€ pour un MVP. On peut cadrer votre besoin en une semaine de Product Design Sprint avec un prototype testable et un devis détaillé.

C'est ce qu'on recommande. Un premier rendez-vous d'une heure dans nos bureaux permet de comprendre votre besoin et vos contraintes. On vous donne une première estimation et on vous explique comment on travaille. Prenez rendez-vous via notre formulaire de contact, on vous propose un créneau sous 48h.

Non, loin de là. Nos clients sont répartis dans toute la France : Île-de-France, Grand Ouest, région Centre. Nous avons aussi des bureaux à Paris et Strasbourg. Mais notre ancrage à Tours nous permet d'offrir un accompagnement de proximité unique aux entreprises de la région : ateliers en présentiel, déplacements rapides, connaissance du tissu économique local.

La compréhension métier. Quand on peut passer une journée dans vos locaux, observer vos équipes travailler, comprendre vos processus sur le terrain, on construit un produit qui colle vraiment à votre réalité. Les projets pilotés en 100 % remote souffrent souvent de malentendus, de délais dans les validations et de produits qui passent à côté du vrai besoin. La proximité élimine ces frictions.

98 % de nos projets sont en production en moins de 3 mois. Pour un MVP, comptez 2 à 3 mois. Pour une plateforme plus complexe, 4 à 6 mois. La proximité géographique accélère les choses : les ateliers en présentiel permettent de converger plus vite sur la bonne solution, et les allers-retours par email sont remplacés par des discussions en face-à-face.

Des PME et ETI de la région Centre-Val de Loire et du Grand Ouest, mais aussi des entreprises nationales qui apprécient notre approche. Concrètement : des industriels qui veulent digitaliser leurs processus (suivi de production, gestion de stocks, maintenance prédictive), des entreprises de services qui ont besoin d'un outil métier sur-mesure pour remplacer leurs fichiers Excel, et des groupes en croissance qui cherchent un partenaire technique de confiance pour structurer leur SI. Nos projets vont de 40 k€ pour un MVP à 500 k€ pour des plateformes complexes.

Parce qu'en 2019, nos fondateurs étaient convaincus que l'expertise technique n'a pas besoin d'être concentrée à Paris pour être excellente. Tours offre un cadre de vie qui attire des développeurs seniors expérimentés, souvent des profils qui ont quitté Paris après 10 ans d'expérience dans des startups ou des scale-ups. Depuis, on a ouvert des bureaux à Paris et Strasbourg, mais Tours reste le cœur de l'entreprise. C'est ici qu'on forme nos équipes, qu'on développe nos méthodes, et qu'on pilote des projets pour des clients partout en France.

Bien sûr, et on le fait régulièrement. Pour les ateliers de cadrage, les démos produit ou les formations, on se déplace dans vos locaux partout en Indre-et-Loire, Loir-et-Cher, Loiret ou plus largement en Centre-Val de Loire. Pour les entreprises basées à Orléans, Blois ou Chartres, on est à moins d'1h30 de route. C'est un avantage concret par rapport à une agence parisienne qui facture des frais de déplacement et met une demi-journée pour venir vous voir.

Oui. Notre tout premier client longue durée, BTP Consultants, a été accompagné pendant 3 ans depuis nos bureaux tourangeaux. On a aussi travaillé avec des acteurs industriels comme JPB Système (SaaS IoT pour des sites comme le Parc Astérix) et des startups en forte croissance comme Greenscope (levée de 3 M€ après notre accompagnement). Au total, plus de 250 projets livrés depuis 2019, dont une grande partie pilotée directement depuis Tours. On peut vous mettre en relation avec des clients de la région si vous souhaitez un retour d'expérience direct.

Un projet web ? Venez en discuter.

1 Impasse du Palais, Tours Centre — ou en visio.

Prendre rendez-vousCafé au bureau → Audit gratuit → Proposition sous 5 jours