Nos experts vous parlent

Le décodeur

Refondre un logiciel, ce n’est pas juste moderniser une stack. C’est repenser en profondeur l’architecture, l’ergonomie et les processus métiers. Et surtout, cadrer le projet dès le départ pour éviter l’effet tunnel, les dérives fonctionnelles et l’absence d’adhésion.

C’est là que tout se joue. Un bon cadrage, une roadmap flexible mais structurée, et une gouvernance qui aligne DSI et métiers permettent d’avancer avec méthode, sans perdre en agilité.

Dans nos précédents articles, on a vu comment :

- Analyser le travail de vos équipes pour identifier les vraies priorités terrain ;

- Fixer des objectifs clairs pour mesurer le succès d’un logiciel ;

- Définir les parties prenantes et les besoins utilisateurs pour garantir l’adoption.

👉 Maintenant, voyons comment poser des bases solides en structurant la refonte avec une approche itérative et un cadre clair.

Cadrer le projet : poser les bases et aligner la DSI avec les métiers

Mettre en place une gouvernance claire

Une refonte logicielle, c’est un projet qui implique des décisions structurantes sur l’architecture, l’expérience utilisateur et les workflows métiers. Si la gouvernance n’est pas cadrée dès le départ, on tombe systématiquement dans un déséquilibre entre approche "top-down" et "bottom-up" :

- Un projet monopolisé par la DSI, qui optimise la dette technique mais accouche d’un outil déconnecté des usages réels.

- Un projet dominé par les métiers, qui accumule les demandes sans arbitrage clair et finit par exploser en vol.

👉 Éviter ces dérives passe par une gouvernance efficace, articulée autour de deux groupes clés.

Le Groupe Métier : prioriser les besoins avec méthode

Prenons un cas concret. Un département métier demande une fonctionnalité permettant de générer 10 documents en un clic. Bonne idée ? Peut-être. Prioritaire ? Pas sûr.

Les bonnes questions à poser avant de valider :

- Effort technique ? Combien de jours-homme pour développer cette fonctionnalité ?

- Impact business ? Ex. gain de productivité : génération de +3 rapports/jour/consultant.

- ROI attendu ? En combien de temps cette fonctionnalité sera-t-elle rentable ?

👉 Si l’impact est réel et le coût raisonnable, on avance. Sinon, on revoit la priorité.

Le problème ? Les métiers sont souvent biaisés par leur utilisation quotidienne. Ils peuvent surestimer certains besoins ou ignorer les implications techniques.

Alors, c’est le Groupe Sponsor qui prend du recul.

Le Groupe Sponsor : fixer le cap et trancher rapidement

Prenons un cas typique. Le Groupe Métier veut refondre complètement un module de reporting pour optimiser l’analyse des données terrain. De son côté, la DSI estime que cette refonte nécessitera six mois de développement, retardera d’autres chantiers et mobilisera trop de ressources.

Que fait le Groupe Sponsor ? Il tranche. Plutôt que de suivre aveuglément la demande métier, il challenge la vraie nécessité :

- A-t-on besoin d’une refonte complète ou d’une solution plus simple ?

- Peut-on livrer rapidement des exports de données améliorés en 6 semaines ?

- Quel est le gain business réel par rapport à l’investissement technique ?

Son rôle n’est pas de dire oui ou non, mais d’arbitrer intelligemment pour maximiser l’impact tout en respectant les contraintes.

Les erreurs classiques ?

Un Groupe Sponsor trop passif, qui ne réagit qu’en cas de crise, ou au contraire omniprésent, qui micro-manage chaque décision et ralentit le projet. La clé est de ritualiser les arbitrages et d’établir dès le départ des critères de décision objectifs : quels KPIs pour mesurer l’impact de la refonte ? Quels délais et quelles limites budgétaires sont non négociables ?

Un contact utilisateur fréquent : le vrai moteur de la refonte

Trop souvent, la validation repose sur les managers, qui traduisent une vision macro des besoins. Mais ce sont les équipes terrain qui subissent au quotidien les frictions, les lenteurs, les doublons inutiles. Ignorer ces signaux, c’est prendre le risque de concevoir un produit contourné avant même d’être adopté.

Plutôt que de s’appuyer sur une étude unique en début de projet, la refonte doit intégrer les utilisateurs en continu :

- Tester les fonctionnalités en cours de route pour ajuster ce qui ne fonctionne pas avant qu’il ne soit trop tard.

- Observer le terrain : ce que les utilisateurs disent n’est pas toujours ce qu’ils font. Le vrai irritant n’est pas toujours là où on l’imagine.

- Privilégier des feedbacks rapides et actionnables plutôt que des études longues et formelles. Une amélioration doit se traduire en semaines, pas en mois.

Appliquer le framework F.O.C.U.S.E.D pour structurer la refonte

Une refonte mal cadrée finit toujours par dériver : objectifs flous, priorités changeantes, backlog interminable. Le framework F.O.C.U.S.E.D, utilisé chez PayPal et BlaBlaCar, permet de structurer le projet et de s’assurer que chaque décision est prise sur des bases solides.

Frame : Définir l’ambition de la refonte

On en a parlé dans notre article sur la définition des objectifs logiciels : une refonte ne se justifie que si elle répond à un problème clair - dette technique bloquante, UX obsolète, nouvelle réglementation... Sans objectif précis, on disperse les efforts.

- Fixez des objectifs business et techniques : Ex. Réduire de 30 % le temps de traitement des demandes clients.

- Anticipez les contraintes : interopérabilité, sécurité, coûts, scalabilité.

Observe : Identifier les usages et les blocages

Ne partez pas d’une intuition, partez des données terrain pour analyser le travail de vos équipes. Le vrai problème n’est pas toujours celui qu’on imagine.

- Analysez les irritants utilisateurs et IT : quels sont les freins au quotidien ?

- Suivez des KPIs de performance : comment mesurer l’impact d’une refonte ?

- Identifiez les opportunités technologiques : cloud, API, microservices : quels leviers pour gagner en flexibilité ?

Claim : Définir le positionnement du futur logiciel

Refondre ou faire évoluer ? Inutile de tout démolir si certaines briques tiennent la route.

- Faites les bons choix d’architecture. Monolithe vs. microservices : anticipez la scalabilité.

- Pensez évolutivité : un logiciel efficace doit pouvoir s’adapter sans refonte lourde tous les 5 ans.

Unfold : Identifier les moments critiques

Quels sont les workflows qui doivent impérativement être optimisés ?

- Ciblez les processus à fort impact : validation des commandes, gestion des factures, reporting.

- Accompagnez le changement : un logiciel qui bouscule trop brutalement les habitudes sera rejeté.

Steal : S’inspirer de ce qui fonctionne ailleurs

Pourquoi repartir de zéro quand on peut capitaliser sur l’expérience des autres ?

- Analysez les best practices du marché : benchmarking de solutions concurrentes.

- Apprenez de votre historique interne : quelles erreurs ou réussites des précédentes refontes ?

Execute : Construire rapidement un prototype

Une refonte ne doit pas rester théorique. Testez vite, ajustez en continu.

- Utilisez des wireframes exploratoires : vérifiez l’UX avant d’écrire une ligne de code.

- Faites un Proof of Concept (POC) : identifiez les risques techniques sur les briques critiques.

- Développez un MVP : livrez une première version testable et ajustable.

Decide : Prioriser et arbitrer pour avancer

Un projet qui n’arbitre pas ses priorités dérive et s’éternise.

- Alignez DSI et métiers : impact métier vs. faisabilité technique.

- Planifiez un déploiement progressif : limitez les risques et ajustez en fonction des retours terrain.

Définir le périmètre de la refonte logicielle

Une refonte ne peut pas tout traiter d’un coup. Vouloir livrer un logiciel "complet" dès le départ, c’est prendre le risque de s’enliser dans un projet interminable. Ce qui compte, c’est de livrer vite, d’ajuster en continu et d’éviter l’effet tunnel.

L’approche MVP permet d’avancer par étapes, de sécuriser les choix et d’impliquer les utilisateurs au bon moment. Objectif : livrer une première version exploitable rapidement, tout en gardant la flexibilité pour affiner et enrichir au fil de l’eau.

Construire une roadmap MVP pour sécuriser la refonte

Plutôt que de viser un déploiement massif et figé, le MVP permet d’itérer en conditions réelles. L’idée n’est pas de livrer un outil incomplet, mais une version ciblée et actionnable dès les premières phases.

Trois bénéfices majeurs :

- Réduire le time-to-market en sortant une première version testable rapidement.

- Collecter des feedbacks terrain avant d’investir massivement sur des fonctionnalités inutiles.

- Limiter les risques en validant l’adoption et la compatibilité technique étape par étape.

Approche MVP appliquée à une refonte

Une refonte en mode MVP repose sur trois phases structurées, avec une progression logique et mesurable.

Phase 1 : Auditez et cadrez votre refonte logiciel

Sans ce cadrage initial, vous risquez de reconstruire un produit avec les mêmes problèmes que l’ancien. Prenez le temps de sécuriser votre périmètre :

- Faites l’état des lieux : identifiez les points forts, les faiblesses et la dette technique du logiciel actuel.

- Ciblez les fonctionnalités essentielles : quelles briques doivent être refondues en priorité ?

- Cartographiez les dépendances : SI existant, outils tiers, intégrations critiques.

Phase 2 : Développez et testez en conditions réelles

Un MVP qui ne sert qu’à tester en interne n’est pas un vrai MVP. Il doit permettre aux équipes métier d’expérimenter et de s’approprier l’outil.

- Déployez-le sur un périmètre restreint : Ex. un département pilote pour capter des retours immédiats.

- Collectez du feedback en continu : repérez les irritants, ajustez rapidement.

- Montrez des résultats concrets : un MVP doit être actionnable et apporter de la valeur dès la première version.

Phase 3 : Déployez progressivement et optimisez

Au lieu d’un lancement brutal, montez en charge par étapes pour éviter un rejet du terrain.

- Élargissez progressivement l’adoption : déploiement contrôlé sur d’autres départements ou filiales.

- Accompagnez les équipes : formation et montée en compétence des utilisateurs.

- Ajustez en fonction des usages réels : un bon MVP est une base évolutive, pas une version figée.

Prototyper avec des wireframes exploratoires

Aller directement au développement sans prototypage, c’est naviguer à l’aveugle. Avant de coder quoi que ce soit, il faut visualiser et tester les parcours utilisateurs pour éviter de devoir tout revoir en cours de route.

Les wireframes exploratoires permettent de :

- Valider l’ergonomie et le fonctionnement des flux clés sans toucher au code.

- Repérer les frictions UX avant qu’elles ne bloquent l’adoption.

- Obtenir des retours concrets des utilisateurs avant d’industrialiser les choix.

Mieux vaut ajuster un prototype en quelques jours que modifier un développement après plusieurs moi

Valider les priorités avec la DSI et les métiers

Un périmètre bien défini ne peut pas être figé sans arbitrage DSI / métiers.

Chaque décision doit répondre à trois questions :

- L’impact métier est-il réel ? Est-ce une nécessité ou un simple "nice to have" ?

- La faisabilité technique est-elle validée ? Une fonctionnalité peut être essentielle, mais si son intégration bloque l’ensemble du SI, elle doit être repensée.

- Quelles sont les dépendances ? Certains modules ne peuvent être refondus sans adapter l’ensemble du système.

Pour structurer cette validation :

- Ateliers de co-construction pour aligner les attentes métiers et les réalités techniques.

- Cartographie des dépendances pour éviter les effets de blocage en cascade.

- Arbitrage clair sur ce qui doit être réécrit, migré ou conservé.

Sans priorisation claire, on dérive vers une roadmap irréaliste et un projet impossible à livrer.

Construire une roadmap initiale alignée avec la DSI

Une refonte réussie ne repose pas uniquement sur une vision métier. Elle doit s’ancrer dans la réalité technique pour éviter les impasses. Une roadmap efficace équilibre donc les priorités stratégiques et les contraintes de développement, tout en assurant une exécution progressive.

L’objectif ? Avancer vite sur l’essentiel, sans compromettre la stabilité du produit.

Structurer la roadmap : une approche en trois temps

Une roadmap figée est une roadmap morte. Les besoins évoluent, les contraintes techniques apparaissent en cours de route, et certaines fonctionnalités jugées critiques peuvent finalement s’avérer secondaires.

Plutôt que de tout verrouiller dès le départ, l’approche Now / Next / Later permet de structurer la roadmap de manière dynamique :

- Now : ce qui est déjà en cours : cadrage technique, POC, tests UX.

- Next : ce qui sera développé à court terme : fonctionnalités validées, intégration métier.

- Later : ce qui viendra ensuite : évolutions futures, automatisation avancée, IA.

Pourquoi cette approche fonctionne ? Parce qu’elle évite de s’enfermer dans un plan rigide et permet d’ajuster les priorités en fonction des apprentissages terrain.

Prioriser les initiatives : arbitrer entre impact et faisabilité

Toutes les fonctionnalités ne se valent pas. Certaines sont critiques dès le départ, d’autres peuvent attendre. L’enjeu est d’éviter un backlog surchargé qui freine l’avancement du projet.

Deux méthodes permettent d’arbitrer efficacement :

La méthode MoSCoW

- Must Have : fonctionnalités indispensables pour le lancement.

- Should Have : importantes mais non bloquantes si elles arrivent plus tard.

- Could Have : options secondaires, à intégrer si possible.

- Won’t Have : hors périmètre, à exclure de la roadmap.

La matrice Effort / Impact

Un bon arbitrage ne se fait pas uniquement sur la valeur métier : il faut aussi prendre en compte la faisabilité technique.

- Fort impact, faible effort : priorité absolue, effet rapide sans complexité excessive.

- Fort impact, fort effort : à cadrer avec la DSI pour anticiper les risques.

- Faible impact, faible effort : à traiter en opportunité, sans mobiliser trop de ressources.

- Faible impact, fort effort : à écarter, sauf obligation stratégique.

L’enjeu est clair : investir là où l’impact est maximal, tout en sécurisant l’exécution.

Co-construction et communication de la roadmap

Une roadmap qui dort dans un fichier Notion n’a aucun intérêt. Elle doit être un outil opérationnel, mis à jour en continu, partagé et compris par toutes les parties prenantes. L’objectif : garantir l’alignement entre la DSI, les métiers et les équipes produit, tout en restant adaptable aux réalités du terrain.

Des rituels pour piloter et ajuster la roadmap

Une roadmap efficace se construit dans la durée, avec des ajustements réguliers basés sur les retours des utilisateurs et l’avancement technique.

Pour éviter l’effet tunnel et les mauvaises surprises, plusieurs instances de suivi sont essentielles :

- Comités de pilotage (DSI, métiers, sponsors) : arbitrage des priorités et validation des évolutions clés.

- Synchronisation trimestrielle : ajustement de la roadmap en fonction des retours terrain et des contraintes techniques.

- Checkpoints courts et réguliers : points opérationnels avec les équipes produit pour garder une dynamique agile.

L’objectif n’est pas juste de suivre l’avancement, mais de s’assurer que la roadmap reste pertinente et actionnable.

Des outils de suivi pour une exécution fluide

Une roadmap ne doit pas reposer sur des fichiers Excel statiques. Pour assurer un suivi efficace et une collaboration fluide, les bons outils font la différence :

- Notion / Confluence : documentation centralisée, décisions et suivi des orientations stratégiques.

- Miro / FigJam : prototypage et ateliers collaboratifs pour structurer et affiner les parcours UX/UI.

- Linear / Jira : pilotage opérationnel des développements et suivi des sprints.

Un bon outil ne remplace pas une bonne gouvernance, mais il fluidifie la prise de décision et le suivi.

"Une roadmap, ça ne doit pas juste être un document figé dans un coin. Si personne ne la comprend ou ne l’utilise, elle ne sert à rien. Il faut la partager, l’expliquer et la piloter avec des données concrètes. On ne peut pas se fier aux intuitions : seuls les KPIs et les retours terrain permettent d’ajuster efficacement. Et surtout, une refonte ne se décrète pas, elle se prépare. Plus on implique les équipes métier tôt, moins on se retrouve avec des blocages en bout de course."

— Arthur, Product Manager

Évitez l’effet tunnel : pilotez votre refonte avec méthode

Une refonte bien menée, c’est un équilibre entre vision métier, faisabilité technique et adoption utilisateur. Sans cadrage précis, les priorités dérivent, les décisions s’empilent et le projet devient ingérable.

Les fondamentaux pour sécuriser la refonte :

- Structurer le projet avec le framework F.O.C.U.S.E.D : cadrer chaque décision pour éviter les dérives fonctionnelles.

- Travailler en mode MVP : livrer rapidement une première version actionnable et éviter l’effet tunnel.

- Établir une roadmap évolutive : adapter le périmètre en fonction des contraintes techniques et des retours terrain.

- Co-construire avec les parties prenantes : aligner la DSI et les métiers pour garantir un produit adopté et maintenable.

Vous préparez une refonte et voulez éviter les pièges classiques ? Structuration du projet, alignement DSI-métiers, approche MVP… Nous vous aidons à bâtir une refonte pilotée, actionnable et adoptée. Parlons-en.

Digital Factory en entreprise : les 4 erreurs fatales qui mènent à l’échec

Créer une Digital Factory, c’est la promesse d’accélérer l’innovation, de livrer des produits digitaux plus rapidement et de rapprocher IT et métiers. Pourtant, 70 % des Digital Factories ne parviennent pas à générer un impact mesurable. Pourquoi ? Parce qu’elles tombent dans des pièges récurrents qui condamnent leur efficacité.

👉 Dans cet article, on identifie les 4 erreurs les plus fréquentes qui sabotent les Digital Factories et on vous donne les clés pour les éviter.

Erreur #1 : Une Digital Factory isolée du reste de l’entreprise

Lancer une Digital Factory sans l’intégrer dans l’écosystème global de l’entreprise, c’est la recette d’un échec programmé. Beaucoup d’entre elles fonctionnent comme des laboratoires indépendants, développant des POCs et des MVPs qui ne seront jamais adoptés par le reste de l’organisation.

Pourquoi c’est un problème ?

- Les produits créés restent des initiatives locales sans sponsor exécutif.

- Les DSI et métiers ne sont pas impliqués, donc les solutions ne sont pas industrialisées.

- Le reste de l’entreprise perçoit la Digital Factory comme un gadget et non comme un moteur de transformation.

Solution :

- Assurez un alignement stratégique fort avec la direction générale et la DSI.

- Intégrez des sponsors métiers dès le début pour garantir l’adoption des solutions.

- Industrialisez rapidement les innovations pour les rendre exploitables à grande échelle.

Erreur #2 : Une gouvernance floue et des responsabilités mal définies

Trop de Digital Factories échouent car elles n’ont pas de périmètre clair : qui décide des projets prioritaires ? Qui valide les budgets ? Quelle est leur relation avec la DSI et les équipes métiers ?

Pourquoi c’est un problème ?

- Sans une gouvernance claire, la Digital Factory devient un terrain de jeu où chaque initiative part dans une direction différente.

- Les décisions sont lentes et les arbitrages inefficaces.

- Les équipes se heurtent à des conflits internes entre DSI, direction métier et Digital Factory.

Solution :

- Définissez un cadre clair entre la Digital Factory, la DSI et les métiers.

- Mettez en place une comité de gouvernance avec des décideurs identifiés.

- Clarifiez les rôles et responsabilités : la Digital Factory doit-elle livrer des MVPs ou des produits industrialisés ?

Erreur #3 : Une approche purement expérimentale sans logique d’industrialisation

Une Digital Factory n’est pas un laboratoire de R&D. Son objectif n’est pas de multiplier les POCs, mais bien de livrer des solutions digitales viables et adoptées.

Pourquoi c’est un problème ?

- Si elle se concentre uniquement sur l’expérimentation, aucun projet ne passe en production.

- Sans industrialisation, les équipes métiers et la DSI voient la Digital Factory comme un centre de coûts inutile.

- Les projets restent au stade du prototype et ne génèrent aucun impact business tangible.

Solution :

- Mettez en place un pipeline d’industrialisation dès le départ.

- Priorisez les projets qui ont un potentiel de déploiement à grande échelle.

- Travaillez en étroite collaboration avec la DSI pour assurer l’intégration des solutions dans le SI existant.

Erreur #4 : Un manque d’indicateurs de performance et d’impact business

Beaucoup de Digital Factories peinent à prouver leur valeur car elles ne disposent pas de KPIs clairs pour mesurer leur succès.

Pourquoi c’est un problème ?

- Sans indicateurs, impossible de démontrer le ROI des initiatives.

- La direction finit par considérer la Digital Factory comme un simple centre de coûts.

- Les équipes se démotivent car elles ne voient pas l’impact réel de leur travail.

Solution :

- Définissez des KPIs d’impact business : adoption des solutions, chiffre d’affaires généré, réduction des coûts.

- Suivez le time-to-market pour mesurer l’accélération des développements.

- Assurez un reporting régulier auprès de la direction pour prouver la valeur créée.

Conclusion : une Digital Factory ne doit pas être un gadget, mais un moteur de transformation

Les Digital Factories peuvent révolutionner l’innovation en entreprise… à condition de ne pas tomber dans ces pièges ! Une gouvernance claire, une industrialisation rapide, un alignement avec la DSI et des KPIs solides sont les clés de leur succès.

💬 Votre Digital Factory est-elle sur la bonne voie ? Discutons ensemble des bonnes pratiques pour maximiser son impact.

Où ça a raté ? Dès le départ. Parce qu’un logiciel métier n’est pas un projet isolé. Il impacte toute une organisation et doit s’intégrer aux réalités du terrain. Ne pas impliquer les bonnes parties prenantes dès le départ, c’est foncer droit dans le mur.

On vous montre comment identifier, cartographier et engager les acteurs clés pour éviter ce scénario et garantir que votre logiciel ne soit pas un investissement perdu.

1 - Définir et cartographier les parties prenantes

Prenons un cas typique. Un groupe industriel décide de refondre son logiciel de gestion des interventions terrain. Pressé d’avancer, le comité de direction lance le projet avec les équipes métier et un prestataire externe… sans impliquer réellement la DSI.

Après des mois de développement, le logiciel est livré, mais impossible de l’intégrer aux outils existants. Sécurité non validée, architecture incompatible, coûts de maintenance explosifs. La DSI, mise devant le fait accompli, refuse la mise en production. Retour à la case départ.

L’erreur fatale ? Croire qu’un logiciel peut être conçu dans un silo. Un projet qui ignore ses parties prenantes est un projet condamné.

Commençons par identifier qui influence, qui décide et qui utilise.

Qui sont les parties prenantes ?

Elles se décomposent en deux grandes familles :

- Les stakeholders internes (au sein de l’entreprise) ;

- Les stakeholders externes (utilisateurs finaux, partenaires, régulateurs, etc.).

Les premiers conçoivent et déploient, les seconds conditionnent l’adoption et l’impact. Négliger un seul de ces groupes, c’est prendre le risque d’un projet bancal, inadapté ou rejeté.

Stakeholders internes : ceux qui conçoivent, décident et opèrent

Les Sponsors (Direction Générale, DSI, Responsables métiers)

Ce sont les premières figures incontournables du projet. Ils donnent l’impulsion stratégique et définissent les priorités business. Sans leur adhésion, le projet risque de manquer de ressources ou de cap clair.

Les Métiers (RH, Finance, Logistique, Production…)

Ils sont en première ligne. Ce sont eux qui utilisent le logiciel au quotidien et qui définissent ses exigences fonctionnelles. Les exclure, c’est prendre le risque de concevoir un outil hors-sol, vite contourné ou abandonné.

La DSI (Architectes, Experts IT, Sécurité…)

Pilier technique du projet, elle garantit l’intégration du logiciel dans l’écosystème existant, la sécurité et la scalabilité. Sans elle, on se retrouve avec une solution impossible à maintenir, coûteuse à adapter et parfois même inutilisable.

Le Product Owner / Chef de Projet IT

Le chef d’orchestre du projet. Il fait le lien entre les besoins métiers et la faisabilité technique, priorise, arbitre et assure que l’outil livré est opérationnel. Sans lui, le projet se transforme en une suite de décisions incohérentes et d’attentes mal alignées.

L’Équipe Support et Assistance

Les grands oubliés des projets… jusqu’au moment où les utilisateurs rencontrent un problème. Ils assurent la formation, le support et la gestion des incidents. Si leur rôle est négligé, l’adoption s’effondre et l’outil devient une contrainte plutôt qu’un levier de performance.

Stakeholders externes : ceux qui interagissent avec le logiciel

Les Utilisateurs Finaux Internes

Ce sont eux qui utilisent le logiciel au quotidien et testent son efficacité réelle. Si leur expérience est négligée, l’adhésion s’effondre. Un outil mal conçu sera rapidement contourné au profit de solutions parallèles non maîtrisées (shadow IT).

Les Clients et Partenaires Externes

Lorsque le logiciel sert d’interface avec des acteurs externes, chaque friction impacte directement la relation commerciale. Un mauvais design, une ergonomie bancale, ou des process inadaptés peuvent générer des ralentissements et de la frustration.

Les Régulateurs et Services Juridiques

RGPD, conformité comptable, normes sectorielles… Ignorer ces exigences en amont, c’est s’exposer à des retards, des surcoûts et des risques juridiques. Un logiciel qui ne respecte pas les réglementations peut être bloqué avant même son déploiement.

Les Éditeurs de Logiciels Tiers et Partenaires API

Un logiciel métier doit s’intégrer avec d’autres outils (ERP, CRM, BI…). Une interopérabilité ratée, et c’est l’expérience utilisateur qui trinque : doublons de saisie, données incomplètes, workflows cassés. Un bon projet ne se limite pas à son périmètre interne, il prend en compte tout son écosystème technique.

Hiérarchiser avec la Power-Interest Grid

Identifier les parties prenantes ne suffit pas. Encore faut-il les hiérarchiser pour déterminer leur degré d’influence et leur niveau d’implication dans le projet. L’outil de référence pour cela ? La Power-Interest Grid, un modèle issu des travaux d’Ackermann & Eden.

Ce framework classe les parties prenantes selon deux critères :

- Le pouvoir : leur capacité à influencer le projet (décision, financement, arbitrage).

- L’intérêt : leur niveau d’implication et d’impact direct sur l’usage du logiciel.

En croisant ces dimensions, on obtient quatre catégories d’acteurs :

Visualiser ces dynamiques permet d’adopter la bonne stratégie d’engagement pour chaque acteur. Voici comment positionner vos parties prenantes avec la Power-Interest Grid :

De la théorie à l’action : exploiter la Power-Interest Grid

La Power-Interest Grid n’est pas qu’un exercice théorique, c’est un outil stratégique qui doit orienter chaque interaction. Voici comment en tirer un maximum de valeur :

A- Priorisez les engagements

Les Players doivent être impliqués dès la conception - pas en spectateurs, mais en décideurs actifs. Organisez des comités de pilotage, mettez en place des points d’alignement réguliers et captez leurs arbitrages en continu.

Les Subjects sont les premiers impactés par l’outil : intégrez-les aux tests et aux validations pour garantir une adoption fluide.

B- Adaptez la communication

Tous les acteurs n’ont pas besoin du même niveau d’information.

Les Context Setters ne veulent pas de détails techniques, mais des insights synthétiques qui leur permettent de valider sans perdre de temps. Pensez dashboards, reports concis et messages ciblés.

À l’inverse, les Subjects doivent être activement impliqués dans les feedback loops pour assurer que le produit répond à leurs attentes.

C- Anticipez et gérez les résistances

Les Crowd sont souvent laissés de côté… jusqu’à ce qu’un fournisseur ou un sous-traitant freine le projet en cours de route. Mieux vaut assurer un minimum d’information et de transparence en amont plutôt que gérer des blocages tardifs. Un simple briefing périodique suffit à éviter des objections inutiles.

D- Évoluez avec l’outil interne

Une Power-Interest Grid statique ne sert à rien. Les enjeux, les priorités et les influenceurs évoluent au fil du projet. Planifiez des revues trimestrielles pour ajuster votre cartographie et affiner les stratégies d’engagement. Identifiez les nouveaux acteurs clés et adaptez votre approche en conséquence.

2 - Identifier les besoins utilisateurs : croiser le quanti et le quali

Se baser uniquement sur des chiffres donne une vision incomplète. À l’inverse, s’appuyer uniquement sur des retours qualitatifs sans données mesurables peut fausser les décisions. Pour concevoir un logiciel aligné sur les attentes réelles, il faut croiser observation et analyse chiffrée.

- Les données quantitatives révèlent les usages concrets : quelles fonctionnalités sont utilisées, à quelle fréquence, où les utilisateurs rencontrent des blocages.

- Les données qualitatives apportent du contexte : pourquoi certaines actions sont privilégiées, quelles frustrations émergent, quels besoins ne sont pas couverts.

L’un ne va pas sans l’autre. Une fonctionnalité peu utilisée ne signifie pas qu’elle est inutile : elle peut être mal implémentée, difficile d’accès ou mal comprise.

Méthodes pour collecter les besoins utilisateurs

Approche quantitative : mesurer l’usage réel

L’objectif est d’analyser les comportements des utilisateurs sans interprétation subjective.

- Analyse des logs d’utilisation → Identifier les fonctionnalités les plus et les moins utilisées.

- Détection des points de friction → Repérer les erreurs fréquentes, ralentissements et abandons d’action.

- Suivi des temps de traitement → Mesurer les gains de productivité attendus sur certaines tâches.

Ces données permettent d’objectiver les améliorations à prioriser et d’éviter les décisions guidées uniquement par des intuitions internes.

Approche qualitative : comprendre les attentes et frustrations

Les chiffres ne suffisent pas : il faut aller sur le terrain pour saisir la réalité des usages.

- Interviews utilisateurs → Recueillir leurs frustrations et attentes en direct.

- Observation terrain (shadowing) → Voir concrètement comment ils interagissent avec le logiciel.

- Ateliers de co-construction → Construire ensemble les workflows et valider les hypothèses d’amélioration.

Ces méthodes permettent d’anticiper les besoins cachés, ceux qui n’apparaissent pas dans les logs mais qui ont un impact direct sur l’expérience.

Formaliser les apprentissages : personas et empathy map

Personas : donner un visage aux utilisateurs

Un persona synthétise les attentes et comportements des différents types d’utilisateurs.

- Persona primaire → Ceux qui utilisent le logiciel quotidiennement.

- Persona secondaire → Managers, profils occasionnels avec des besoins spécifiques.

- Anti-persona → Ceux qui ne sont pas la cible et pour qui l’outil ne doit pas être optimisé.

Un bon persona ne se limite pas à un avatar marketing : il repose sur des insights concrets issus des observations terrain et de la data.

Empathy Map : aller plus loin dans la compréhension des usages

L’Empathy Map est un outil qui permet de cartographier ce que ressentent, voient, entendent et disent les utilisateurs dans leur quotidien professionnel.

- Ce qu’ils pensent et ressentent → Leurs motivations, frustrations et préoccupations.

- Ce qu’ils disent et font → Leur manière d’interagir avec l’outil, leurs habitudes et contraintes.

- Ce qu’ils voient → L’environnement dans lequel ils évoluent, les outils qu’ils utilisent au quotidien.

- Ce qu’ils entendent → Les influences externes qui impactent leur perception du logiciel.

Pourquoi l’utiliser ? Pour éviter de concevoir un logiciel déconnecté des réalités terrain et s’assurer que chaque fonctionnalité répond à un besoin concret.

3 - Adopter une démarche de discovery continue

Pourquoi une seule étude utilisateur ne suffit pas ?

Les besoins des utilisateurs ne sont pas figés. Un logiciel métier évolue avec son environnement : nouvelles contraintes, usages qui se transforment, attentes qui se précisent.

Se baser sur une recherche initiale et considérer le sujet clos, c’est prendre le risque de se déconnecter rapidement du terrain.

L’erreur classique ? Concevoir un produit en fonction d’un besoin à un instant T… et découvrir six mois plus tard qu’il ne répond déjà plus aux attentes réelles.

Comment mettre en place un cycle d’apprentissage permanent ?

L’enjeu est d’organiser un flux régulier de retours utilisateurs pour ajuster en continu. Trois leviers à activer :

1- Le feedback passif : capter les signaux faibles

Certaines données remontent naturellement sans nécessiter d’effort de collecte. Encore faut-il les écouter. Problèmes récurrents, frustrations émergentes, usages inattendus… tout est là, à condition de ne pas laisser ces données dormir :

- Formulaires intégrés dans l’application pour capturer les retours à chaud.

- Analyse des avis et tickets support → Repérez les récurrences et tendances négatives.

- Données analytics → Identifiez les zones de friction et comportements inattendus.

2- Le feedback actif : aller chercher l’info directement

Les chiffres ne disent pas tout. Un produit peut afficher un bon taux d’adoption tout en générant des frictions énormes sur le terrain. Pour éviter les angles morts, rien ne remplace l’échange direct avec les utilisateurs :

- Des entretiens réguliers pour identifier ce qui fonctionne et ce qui bloque.

- L’observation terrain (shadowing) révèle comment l’outil est réellement utilisé au quotidien.

- Les tests de nouvelles fonctionnalités valident leur adoption avant un déploiement à grande échelle.

3- L’intégration du feedback dans la roadmap produit

Collecter du feedback, c’est bien. L’exploiter intelligemment, c’est mieux. Une discovery efficace ne se contente pas d’accumuler des insights, elle doit alimenter directement la roadmap produit. Pour ça :

- Priorisez les feedbacks à fort impact pour éviter de vous disperser.

- Itérez rapidement, avec des cycles courts d’expérimentation pour tester, mesurer et ajuster en continu.

- Partagez les apprentissages pour aligner les équipes tech et métier sur les enseignements du terrain.

Le succès ne se décrète pas, il se construit

Un logiciel métier qui n’intègre ni méthodologie claire ni prise en compte des usages réels, c’est un logiciel qui finit contourné, sous-exploité, voire rejeté. Pour éviter ça :

- Cartographiez les parties prenantes avec la Power-Interest Grid pour impliquer les bons acteurs au bon moment.

- Analysez les besoins utilisateurs en combinant données quantitatives (logs, analytics) et données qualitatives (entretiens, shadowing).

- Formalisez ces apprentissages avec des outils comme les personas et l’Empathy Map pour garder un cap clair sur les attentes des utilisateurs.

- Adoptez une discovery continue pour ajuster le produit en permanence et éviter qu’il ne devienne obsolète face aux évolutions du marché.

Vous voulez structurer votre approche produit et éviter les erreurs classiques ? Nous vous aidons à mettre en place une démarche orientée utilisateur, itérative et fondée sur des insights actionnables. Discutons-en.

Ce scénario est loin d’être rare, car beaucoup d’entreprises tombent dans le piège de mesurer la livraison plutôt que l’impact. Un projet est trop souvent déclaré “réussi” parce qu’il a été déployé, alors qu’il devrait l’être parce qu’il a changé la donne sur le terrain.

Le problème : un logiciel n’a de valeur que si ses utilisateurs en tirent un bénéfice concret. Les tâches critiques sont-elles réalisées plus vite ? Les erreurs réduites ? Les nouvelles fonctionnalités sont-elles adoptées… ou déjà contournées ?

S’il n’y a pas de réponses claires dans vos dashboards, c’est que vous n’avez pas posé les bons indicateurs. Vous ne mesurez rien - et ce que vous ne mesurez pas, vous ne l’améliorez pas.

Piloter un logiciel, ce n’est pas compter les connexions. C’est mesurer son impact réel. On vous explique comment.

1- Commencez par vous aligner sur la stratégie d’entreprise et les besoins métier

Créer un logiciel ne sert à rien s’il ne répond pas aux bonnes priorités. Avant même de parler roadmap, il faut se poser la vraie question : à quoi doit servir cet outil ?

D’où viennent les objectifs ?

Tout part de la stratégie d’entreprise. Un logiciel métier n’est pas une brique isolée : il doit s’inscrire dans une vision plus large et répondre à des enjeux concrets.

Deux approches existent :

- Top-down → Les décideurs (DSI, direction produit, responsables métier) définissent les objectifs en fonction des grandes priorités stratégiques.

- Bottom-up → Les équipes terrain (utilisateurs finaux, opérationnels) font remonter leurs besoins réels pour s’assurer que le logiciel simplifie leur travail.

Dans la réalité, le bon équilibre est souvent un mix des deux. Un cadrage top-down donne la vision, une approche bottom-up garantit que l’outil sera réellement utilisé.

Le plus important : chaque objectif doit être actionnable et rattaché à un besoin concret. Une roadmap ne sert pas à livrer des fonctionnalités, mais à atteindre des résultats.

Pourquoi fixer des objectifs clairs ?

Un bon objectif donne une direction, motive les équipes et aligne tout le monde sur un même cap.

- Il fixe l’ambition : quelle transformation veut-on atteindre avec ce logiciel ?

- Il évite la dispersion : chaque nouvelle fonctionnalité doit servir un but précis.

- Il garantit l’autonomie : une équipe qui sait où elle va peut prendre les bonnes décisions.

- Il favorise la collaboration : un objectif clair permet à l’IT, aux métiers et à la direction de parler la même langue.

2 - Utilisez la méthode SMART pour construire vos objectifs

Un objectif ne doit pas juste être une intention vague du type “améliorer l’expérience utilisateur” ou “optimiser la gestion des stocks”. Il doit être SMART :

Specific (Spécifique) → Un seul enjeu, clair et précis.Ex. Réduire de 30 % le temps de saisie des données par les commerciaux.

Measurable (Mesurable) → Basé sur des chiffres, pas des impressions.Ex. Augmenter de 20 % le taux d’adoption du module de reporting.

Achievable (Atteignable) → Ambitieux, mais réaliste compte tenu des contraintes techniques et organisationnelles. Un objectif irréalisable démotive plus qu’il ne motive.

Relevant (Pertinent) → En lien direct avec les besoins des utilisateurs et les priorités stratégiques.

Time-bound (Temporellement défini) → Avec une deadline claire pour évaluer l’impact.Ex. Objectif atteint en 6 mois.

Comment fixer des objectifs efficaces

Vos objectifs doivent s’inscrire dans un cycle produit : une période définie (de quelques semaines à plusieurs mois) durant laquelle l’équipe livre des évolutions ciblées et mesure leur impact. L’enjeu, c’est d’éviter les plans figés et d’itérer rapidement en fonction des retours terrain. Un objectif n’est donc pas gravé dans le marbre, il peut être recalibré.

Trop d’objectifs tuent l’objectif. Pour être efficace, concentrez-vous sur 3 à 4 priorités par cycle produit. Inutile d’empiler les ambitions si elles sont ingérables en pratique.

Autre point clé : un objectif doit être un cap, pas une liste d’actions. Dire “déployer un module de reporting” n’a aucun sens si on ne sait pas pourquoi. En revanche, viser “80% des managers utilisent le module de reporting chaque semaine” donne une vision de l’impact recherché.

En pratique : un objectif SMART appliqué

❌ "Améliorer le reporting."

C’est vague et inutilisable.

✅ "D’ici 6 mois, 90% des rapports doivent être générés automatiquement sans correction manuelle."

Ici, on fixe une échéance, un seuil de performance clair et on traduit un impact métier concret : réduire la charge de travail liée aux corrections manuelles et fiabiliser les données.

3 - Suivez l’impact dans le temps avec le framework OKR

L’approche OKR (Objectives and Key Results) est une méthode puissante pour piloter la performance d’un logiciel et s’assurer qu’il génère un impact réel.

Développée par Intel et popularisée par Google en 1999, elle repose sur un principe simple :

1- Un objectif ambitieux et inspirant ;

2- Des résultats clés (Key Results) pour mesurer le succès.

L’intérêt ? Aligner les équipes techniques et métiers sur des objectifs concrets et mesurables, pour assurer que les évolutions du logiciel génèrent un impact tangible.

Dans une organisation bien structurée, chaque équipe décline les OKR globaux de l’entreprise en objectifs opérationnels adaptés à son périmètre.

Prenons un exemple :

OKR Produit

KR 1 : Réduire de 40 % le délai moyen de traitement des tickets d’intervention.

KR 2 : Augmenter de 25 % l’utilisation du module de planification automatique.

KR 3 : Diminuer de 30 % le taux de reprogrammation des interventions.

OKR Dév

KR 1 : Réduire le temps de chargement du module de planification de 2s à 500ms.

KR 2 : Automatiser 90% des tests de facturation en intégrant des tests unitaires et des tests d’intégration dans la CI/CD.

KR 3 : Diminuer le taux de bugs critiques sur la planification à < 1 %.

Pour aller plus loin, voyons comment les OKR se déclinent à partir de la vision et de la stratégie d’entreprise :

Comment piloter ses OKR avec précision

La première règle : un Key Result doit être quantifiable.

Évitez les formulations vagues qui ne disent rien sur l’impact recherché, comme "Améliorer la planification". Privilégiez "Augmenter de 25 % l’usage du module de planification en 3 mois", qui suit une évolution concrète.

Ensuite, restez focus. Multiplier les métriques dilue l’attention et brouille les priorités. Un objectif = 3 à 4 Key Results maximum.

Enfin, un bon OKR évolue avec le produit. Ne vous accrochez pas coûte que coûte à un objectif : revoyez-le régulièrement pour qu’il reste pertinent par rapport aux usages réels.

4 - Fixez des KPIs utiles, pas des chiffres vides de sens

Un bon logiciel n’a de valeur que si son impact est mesurable. Se baser sur le nombre d’utilisateurs ou le taux de connexion ? Inutile. Ces chiffres ne disent rien sur l’efficacité réelle du produit.

Ce qu’il faut suivre, c’est ce que le logiciel change concrètement.

Vous pouvez valoriser trois catégories de KPIS :

- Impact → Effet direct sur le métier : gain de productivité, réduction des erreurs, accélération des processus. (Ex. réduction de 30 % du temps de traitement des demandes clients)

- Ship → Livraison des fonctionnalités clés et leur déploiement. (Ex. adoption du nouveau module de reporting à 80 % en 3 mois)

- Learn → Ce que l’équipe apprend grâce aux retours utilisateurs et aux usages réels. (Ex. 50 % des utilisateurs déclarent que la nouvelle interface réduit leurs efforts de saisie)

Un KPI doit toujours avoir une cible à atteindre et une échéance claire. Sinon, impossible de savoir si l’objectif a été rempli ou s’il faut ajuster la trajectoire.

Comment fixer des KPIs pertinents

Un KPI isolé n’a aucune valeur. Il doit être directement rattaché à un objectif stratégique.

Associez systématiquement vos KPIs aux OKR, pour éviter de suivre des métriques sans impact réel.

Et surtout : ne vous fiez pas uniquement aux chiffres bruts. Analysez-les au fil de l’eau pour ajuster la roadmap et affiner votre stratégie produit en continu.

Exemple concret

❌ KPIs exclus par l’équipe Produit

Atteindre 10 000 nouveaux prospects ajoutés dans le CRM d’ici juin.

Atteindre un taux d’utilisation du module de scoring supérieur à 80%.

👉 On mesure une activité mais pas un impact. Un commercial peut ajouter 500 prospects sans que ça n’améliore les ventes.

✅ KPIs de l’équipe Produit pour mesurer l’impact

Pour l’objectif "Améliorer l’efficacité commerciale en optimisant le ciblage des prospects", nous pouvons fixer, d’ici à juin :

- Impact → Augmenter le taux de conversion des prospects qualifiés de 15 % à 25 %.

- Ship → Déploiement du module d’analyse prédictive pour 100 % des commerciaux d’ici fin avril.

- Learn → 70 % des commerciaux déclarent que le nouveau scoring facilite leur priorisation des leads.

Ici, on ne mesure pas seulement l’adoption mais l’efficacité commerciale.

5 - Ne tombez pas dans le piège des vanity metrics : misez sur des métriques actionnables

La différence entre une bonne et une mauvaise métrique ? Une métrique de vanité vous rassure mais ne vous apprend rien d’utile, tandis qu’une métrique actionnable vous alerte et vous guide sur ce qu’il faut optimiser.

Ce qui compte, ce n’est pas combien de personnes cliquent, mais comment elles utilisent réellement l’outil.

❌ Mauvais indicateurs : Nombre total d’inscrits, pages vues, sessions ouvertes...

Un logiciel peut afficher 50 000 connexions par mois sans que personne n’exploite vraiment ses fonctionnalités clés.

✅ Bons indicateurs : Taux d’utilisation des fonctionnalités critiques, temps gagné par utilisateur, réduction des erreurs, taux de satisfaction des utilisateurs métier…

Ex. « 80 % des utilisateurs complètent un rapport en moins de 10 minutes » prouve que le produit répond bien à son objectif.

6 - Suivez vos objectifs et ajustez en continu

Ce qui semblait prioritaire il y a six mois ne l’est peut-être plus aujourd’hui. Un KPI censé mesurer l’impact d’une fonctionnalité peut se révéler inadapté une fois sur le terrain. Bref, un objectif n’a de valeur que s’il est réévalué en continu.

Révisez chaque trimestre

Tous les trois mois, prenez le temps d’analyser vos KPIs :

- L’objectif fixé correspond-il encore aux enjeux métier ?

- Les résultats obtenus permettent-ils d’ajuster concrètement la roadmap ?

- Les métriques traduisent-elles une vraie amélioration pour les utilisateurs ?

Si un KPI ne guide pas vos décisions, il n’a rien à faire dans votre tableau de bord.

Adaptez les métriques aux usages réels

Le bon indicateur n’est pas figé : il s’affine, se précise et parfois se remplace. Un logiciel vivant s’adapte aux retours terrain :

- Les utilisateurs contournent une feature ? Le problème vient peut-être du process et pas de l’outil.

- Une métrique atteint son objectif mais l’expérience reste mauvaise ? Il faut revoir l’indicateur.

- Un nouveau besoin émerge ? Ajustez votre suivi pour rester aligné avec l’évolution du produit.

Intégrez des objectifs de responsabilité produit

Performance ne doit pas rimer avec court-termisme. Un produit bien conçu intègre des critères de responsabilité au même titre que ses objectifs business. RGPD, accessibilité, impact environnemental… ces sujets méritent des KPIs dédiés.

Par exemple :

- Rendre 100 % des nouvelles fonctionnalités conformes aux normes WCAG.

- Réduire de 50 % le nombre d’incidents liés à la gestion des données personnelles.

- Maintenir un taux de satisfaction supérieur à 90 % sur les fonctionnalités critiques.

Rendez vos objectifs visibles et actionnables

Un objectif qui dort sur Notion ne sert à rien. Pour piloter efficacement, il doit être suivi, visible et actionnable. Sinon, il finira oublié et la roadmap se déconnectera des vrais enjeux.

Comment éviter ça ? En s’appuyant sur trois principes :

- Un tableau de bord visuel où l’équipe suit l’avancement des objectifs et repère immédiatement les écarts. Pas de KPIs décoratifs ici : il faut comprendre en un coup d'œil où on en est.

- Des rituels réguliers avec les parties prenantes : un point trimestriel pour ajuster les priorités, mais aussi des check-in plus fréquents pour capter les signaux faibles et affiner la roadmap en fonction du terrain.

- Une communication transparente : un objectif qui n’est pas partagé est un objectif mort-né. L’équipe doit savoir quels résultats sont atteints, ce qui fonctionne (ou pas) et pourquoi certaines priorités évoluent.

Piloter un logiciel, c’est piloter l’impact

L’erreur la plus fréquente : se focaliser sur la livraison au lieu de l’impact. Un logiciel ne vaut rien s’il n’améliore pas concrètement un process métier. La vraie question n’est pas “est-ce que la fonctionnalité a été livrée ?” mais “a-t-elle changé quelque chose pour ses utilisateurs ?”

Les meilleures équipes produit ne suivent pas des KPIs figés. Elles ajustent en continu, éliminent les métriques inutiles et adaptent leurs objectifs aux apprentissages terrain. Un bon produit n’est pas celui qui respecte un cahier des charges, c’est celui qui prouve sa valeur.

Besoin d’un cadre clair pour fixer vos objectifs et piloter l’impact de votre logiciel métier ? Nous vous aidons à structurer votre stratégie produit, aligner vos KPIs et construire une roadmap actionnable. Discutons-en.

Vous avez déjà vu ça : un nouveau logiciel déployé avec enthousiasme, censé révolutionner un process interne… et six mois plus tard, les équipes continuent à bricoler sur Excel ou à contourner l’outil.

Le problème n’est pas le logiciel. C’est le process qu’il digitalise. S’il est bancal à la base, la technologie ne fera que figer ses défauts.

Alors, avant d’ajouter un énième outil au parc applicatif, posez-vous les bonnes questions :

- Vos équipes perdent-elles vraiment du temps à cause de l’outil, ou à cause du process ?

- Quelles étapes sont inutiles, répétitives ou contournées en douce ?

- Où sont les vrais blocages qui ralentissent la production ?

Sans ce diagnostic, vous risquez de digitaliser un problème… et non de le résoudre. Voyons comment éviter ce piège.

Votre logiciel sera-t-il adopté… ou contourné comme les précédents ?

Un logiciel mal cadré ne corrige pas un process bancal, il le fige.

Trop d’entreprises digitalisent à l’aveugle, pensant que l’outil suffira à améliorer le travail. Et les résultats sont souvent les mêmes :

- Un ERP qui impose 10 écrans pour une tâche simple.

- Une validation qui prend 3 jours au lieu de 3 clics.

- Des saisies répétées dans trois systèmes non connectés.

Conséquence ? L’adoption est catastrophique. Les équipes retournent sur Excel, emails et solutions maison, et l’IT se retrouve avec un logiciel fantôme de plus à maintenir.

👉 Décryptons les 5 principales raisons pour lesquelles ces projets échouent avant même leur lancement.

Raison n°1 : Le process que vous digitalisez est-il vraiment le bon ?

Les équipes vous disent : "Notre outil est obsolète, remplaçons-le."

Mais vous devez vous demander : "Pourquoi nos équipes perdent du temps ? D’où vient vraiment le blocage ?"

Trop souvent, on part du postulat que l’outil est le problème. Mais et si le problème venait du process lui-même ?

Exemples concrets :

- Un workflow avec trop d’étapes inutiles.

- Des validations bloquantes qui ralentissent tout.

- Une organisation du travail mal pensée, qui oblige les équipes à contourner le système.

👉 Avant de développer une nouvelle solution, posez-vous la question : l’outil actuel est-il vraiment dépassé, ou simplement mal utilisé ?

Raison n°2 : Vos équipes trouvent le process lourd… mais où sont les preuves ?

"On perd trop de temps.”

"C’est trop compliqué"

Vous avez sûrement entendu ces plaintes. Mais quelles sont les vraies données derrière ?

Les bonnes questions à se poser :

- Combien de temps vos équipes passent-elles réellement sur chaque tâche ?

- Où sont les blocages qui freinent la production ?

- Quelle part du travail est contournée via Excel, emails ou solutions maison ?

👉 Sans ces réponses, impossible de prioriser les bons sujets. Et vous risquez de digitaliser un problème qui n’existe pas vraiment.

Raison n°3 : Faut-il tout refaire de zéro ou améliorer l’existant ?

La tentation est forte de repartir de zéro. Mais est-ce vraiment nécessaire ?

Dans bien des cas, 90% des besoins sont déjà couverts par l’outil actuel. Le problème ? Il est mal exploité.

Ergonomie bancale, manque d’intégration avec d’autres solutions, fonctionnalités sous-utilisées… Ce sont ces irritants qu’il faut traiter avant d’envisager un remplacement total.

📌 Le risque d’une refonte totale ?

- Un projet long, coûteux et risqué.

- Une transition brutale qui perturbe les équipes.

- Une nouvelle solution… qui sera contournée si elle ne corrige pas les vrais irritants.

👉 Posez-vous la question : L’outil est-il réellement dépassé, ou simplement mal exploité ?

Raison n°4 : Si vos équipes n’utilisent pas l’outil actuel, pourquoi adopteraient-elles le nouveau ?

Si vos équipes ont abandonné l’ancien outil, ce n’est pas juste une question d’interface ou de formation. C’est qu’il ne leur facilitait pas la vie.

Trop rigide, trop éloigné des contraintes terrain, trop de clics pour une simple action… Résultat ? Elles ont trouvé mieux ailleurs : Excel, WhatsApp, emails.

Deux approches s’opposent :

❌ Croire qu’un outil avec une nouvelle UI fera la différence.

✅ Comprendre pourquoi l’ancien a été contourné et intégrer ces contraintes dans la nouvelle solution.

👉 Un bon logiciel n’est pas celui qui a le plus de fonctionnalités. C’est celui que vos équipes veulent utiliser.

Raison n°5 : Chaque service a une vision différente du problème : comment aligner tout le monde ?

Dans un projet de digitalisation, chaque équipe tire dans sa direction :

- L’IT veut une architecture scalable et sécurisée.

- Les métiers veulent un outil simple et rapide à utiliser.

- La finance veut limiter les coûts et éviter un projet trop ambitieux.

Si chacun défend sa vision sans un cadre clair, le projet devient un compromis mou qui ne satisfait personne et qui finira par être abandonné.

👉 Seule une cartographie précise des workflows peut aligner IT, Métiers et Finance pour s’assurer que l’investissement répond à un vrai besoin business.

3 étapes pour analyser le travail de vos équipes

Vous avez identifié un problème. Mais êtes-vous sûr d’avoir bien cerné l’enjeu ? Trop souvent, la digitalisation est vue comme une réponse miracle, alors qu’elle ne fait que reproduire – voire amplifier – les dysfonctionnements existants.

Un projet bien cadré commence toujours par une phase d’analyse fine. Comment vos équipes travaillent-elles réellement ? Quels sont les blocages concrets ? Où sont les pertes de temps, les frustrations, les inefficacités ?

Avant d’envisager une solution, posez un diagnostic précis. On vous donne la méthode step by step.

Étape n°1 : aligner IT, Métiers et Finance avant de lancer le projet

Ne tombez pas dans le piège d’identifier un point de friction et de chercher immédiatement un nouvel outil, sans interroger la structure même du process.

Identifier les parties prenantes et leurs enjeux

Dans un projet de digitalisation, trois groupes d’acteurs ont généralement des attentes différentes :

- Les opérationnels : ce sont eux qui appliquent le process sur le terrain. Leur priorité ? Travailler efficacement sans contraintes inutiles.

- Les responsables métiers : ils supervisent l’activité et sont garants de la qualité et de la performance. Ils cherchent à standardiser les pratiques et à éviter les pertes de temps.

- La DSI et le support IT : ils doivent garantir la compatibilité des outils et leur sécurité. Leur objectif : une solution stable, évolutive et intégrée au SI existant.

- La finance et la direction : elles veillent au budget et au ROI. Leur enjeu ? Éviter un projet trop ambitieux qui explose les coûts, mais aussi un sous-investissement qui génère des dépenses cachées.

Si vous concevez une solution sans inclure ces trois groupes, vous risquez un projet en décalage avec la réalité. Une solution pensée uniquement par l’IT sera perçue comme un carcan par les métiers. Et une solution métier sans cadrage IT créera une dette technique difficile à gérer.

Comprendre comment le travail est réellement effectué

Sur le papier, un process semble clair. Mais dans la pratique, les équipes terrain l’adaptent constamment pour contourner ses défauts.

Pour analyser un process, il ne suffit pas d’interroger les managers. Il faut aller voir sur le terrain. Plusieurs méthodes :

- Observation terrain (shadowing) : suivez les équipes en situation réelle pour voir où se situent les blocages.

- Interviews des opérationnels : appréhendez leurs contraintes et leurs habitudes de travail.

- Audit des outils utilisés : identifiez les écarts entre les usages prévus et les usages réels.

Étape n°2 : identifier les vrais irritants (et pas juste les symptômes visibles)

Un workflow peut sembler logique sur le papier, mais être un enfer pour ceux qui l’utilisent. Avant d’apporter une solution, il faut comprendre ce qui coince concrètement.

Comprendre où se situe la perte de temps

On entend souvent : "Le logiciel est lent", "On perd trop de temps sur cette tâche"... Mais ces constats vagues n’aident pas à agir. Il faut aller plus loin :

- Quelles étapes du workflow prennent anormalement du temps ?

- Où les équipes créent-elles des solutions alternatives pour contourner les blocages ?

- À quel moment les outils deviennent-ils un frein plutôt qu’un soutien ?

Un bon indicateur : si les équipes utilisent Excel, des emails ou WhatsApp en parallèle de l’outil officiel, c’est qu’un problème structurel existe. Le but est de repérer ces détours et comprendre pourquoi ils sont jugés plus efficaces que le système en place.

Aller sur le terrain pour identifier les irritants

Les problèmes les plus critiques ne se trouvent pas dans un fichier de specs ou une analyse théorique. Ils apparaissent dans l’usage quotidien. Pour les identifier, il faut consulter ceux qui vivent ces process :

- Les responsables métiers, qui ont une vision globale et peuvent détecter les goulets d’étranglement.

- Les utilisateurs, qui subissent les lenteurs, les doublons et les contraintes inutiles.

- Le support IT, qui voit remonter les plaintes récurrentes et repère les problèmes techniques à l’origine de certains blocages.

Objectiver les irritants pour mieux prioriser

Une fois ces problèmes identifiés, il faut mesurer leur impact. Sans chiffres, impossible de prioriser les bons sujets. Plusieurs méthodes permettent d’objectiver ces irritants :

- Ateliers de friction : regroupez plusieurs équipes et cartographiez ensemble les irritants concrets qu’elles rencontrent.

- Analyse des tickets support : repérez les plaintes récurrentes pour identifier les dysfonctionnements les plus fréquents.

- Observations terrain : suivez les utilisateurs dans leur quotidien pour détecter les contournements et blocages réels.

L’idée n’est pas de tout optimiser, mais d’éliminer les ralentisseurs inutiles.

Étape n°3 : cartographier les usages réels (et pas ceux sur le papier)

Sans cartographie précise des workflows, impossible de comprendre où se perdent les infos, où les équipes contournent le système et pourquoi.

Alors, comment travaillent réellement vos équipes ?

Démêler les vraies étapes du process

Un workflow ne suit jamais la ligne droite imaginée dans un cahier des charges. Dans la vraie vie, des raccourcis sont pris, des étapes sont sautées, des solutions alternatives émergent.

Un exemple classique : une demande de validation qui, sur le papier, passe par un outil dédié. Sauf que dans la réalité, un coup de fil ou un message WhatsApp accélèrent la procédure. Le problème ? L’information n’est ni tracée, ni structurée.

Comment cartographier le process réel ?

- Observation terrain (shadowing) : passez une journée avec les équipes et regardez comment elles exécutent réellement le process.

- Entretiens avec les métiers : demandez-leur où ils perdent du temps, quelles étapes ils contournent et pourquoi.

- Audit des outils utilisés : vérifiez où l’information transite, si elle est dupliquée et comment elle est saisie. Un ERP peut être utilisé comme simple base documentaire au lieu d’être un véritable outil métier.

Comprendre comment circulent les informations

Quand les équipes passent leur temps à jongler entre plusieurs logiciels, à recopier des informations d’un tableau Excel à un CRM ou à refaire trois fois la même saisie, ce n’est pas un manque de formation, c’est un signal d’alerte.

Ce sont ces points de friction qu’il faut repérer avant de digitaliser. Où les infos sont ressaisies inutilement ? Où les échanges passent en "off" pour gagner du temps ? Où les outils ralentissent le travail au lieu de le fluidifier ?

Comment analyser la circulation des informations ?

- Cartographie des flux IT : analysez comment les outils interagissent entre eux et identifiez les doublons.

- Tracking des tâches : mesurez le temps passé à chaque étape pour repérer les goulets d’étranglement.

- Analyse des logs et des tickets IT : repérez les plaintes récurrentes et les points de friction les plus signalés.

Repérer les blocages invisibles

Un workflow ne bloque pas toujours là où on l’attend. Parfois, un simple mail en attente d’une réponse devient le goulet d’étranglement de toute une chaîne de production.

C’est souvent là que le temps se perd : des étapes de validation trop longues, des transferts d’infos non automatisés, des doublons…

Comment identifier ces blocages ?

- Diagramme BPMN : formalisez les flux et visualisez les étapes superflues ou redondantes.

- Validation métiers : présentez la cartographie aux équipes terrain et ajustez selon leurs retours.

- Tests de simulation : expérimentez différents scénarios pour voir où le workflow coince réellement.

Étude de cas : pourquoi un logiciel métier peut échouer si les usages sont mal compris (et comment l’éviter)

Un acteur majeur du BTP déploie un nouvel outil pour structurer ses rapports de contrôle sur chantier. Ses objectifs : gagner en traçabilité, accélérer la transmission des données, sécuriser la conformité réglementaire.

Sur le papier, le logiciel devait standardiser les rapports. En réalité, il a ajouté de la complexité et personne ne l’a adopté.

On a mené un travail de fond pour comprendre où le projet avait déraillé et comment reconstruire un process digital réellement adapté aux usages terrain.

Comprendre le vrai problème

Dès l’observation terrain, une évidence : un manque total de cadre pour standardiser les documents. Le problème ne vient pas du logiciel, mais d’un process inexistant.

Chaque consultant perdait en moyenne 1h/jour à structurer ses rapports à sa façon. Word, Excel, modèles hérités… aucun standard, aucune homogénéité. L’outil officiel ? Utilisé uniquement pour générer un PDF final. Et encore, quand il n’était pas oublié. Les champs obligatoires ? Parfois ignorés, faute de règles claires.

Identifier les irritants

L’outil en place était censé structurer et fluidifier la gestion des rapports. En réalité, il imposait aux consultants un formalisme rigide, une navigation lourde et trop de saisies inutiles. Au lieu d’aider, il freinait.

Les irritants majeurs qu’on a identifiés :

- Un temps de saisie trop long : jusqu’à 1h pour rédiger un rapport, entre prise de notes sur site et mise en page.

- Trop d’étapes inutiles : chaque champ était obligatoire, même ceux non pertinents selon la mission.

- Une ergonomie inadaptée au terrain : trop de clics, une interface pensée pour le bureau, pas pour le mobile.

Cartographier le flux de travail réel

En cartographiant tout le cycle de rédaction des rapports, une faille majeure est apparue : il n’y avait aucune distinction entre les différents types de contrôles réalisés par les consultants (conception vs exécution).

Le logiciel imposait un format unique pour toutes les missions, sans tenir compte des spécificités de ces deux phases. Conséquences :

- Un process rigide qui ne reflétait pas les méthodes de travail terrain.

- Des contournements systématiques pour s’adapter aux spécificités de chaque chantier.

- Une traçabilité compromise avec des rapports dispersés et non standardisés.

Il fallait revoir la logique de travail en profondeur : adapter les modèles de rapports aux différents types de contrôle et, surtout, simplifier la saisie pour que les consultants passent moins de temps sur la forme.

"Avant, on développait trop vite et on se retrouvait avec un outil inutilisé. En prenant le temps d’analyser les vrais irritants, on a évité de refaire les mêmes erreurs. Cette approche a aligné IT, consultants et direction technique, ce qui a facilité l’adoption et sécurisé la conformité des rapports."

La leçon : un logiciel n’est qu’un outil, le vrai enjeu c’est l’usage

L’erreur aurait été de croire qu’un nouveau logiciel allait résoudre un problème d’organisation. On aurait pu repartir sur une refonte technique, avec une interface plus fluide, des fonctionnalités enrichies… mais en laissant intactes les vraies causes du dysfonctionnement.

Le constat était simple : le logiciel précédent avait été conçu pour répondre aux attentes de la direction, pas aux besoins du terrain. Résultat ? Un outil contourné, des process éclatés et une perte de traçabilité.

Le levier d’optimisation ne se trouvait pas dans la technologie, mais dans une refonte des usages : distinguer les types de contrôle, simplifier la saisie, intégrer les contraintes des consultants.

Vous voulez éviter l’échec d’adoption lors du développement de votre logiciel ? On peut vous à cartographier vos process, identifier les vrais irritants et construire une solution pensée pour être utilisée – pas contournée.

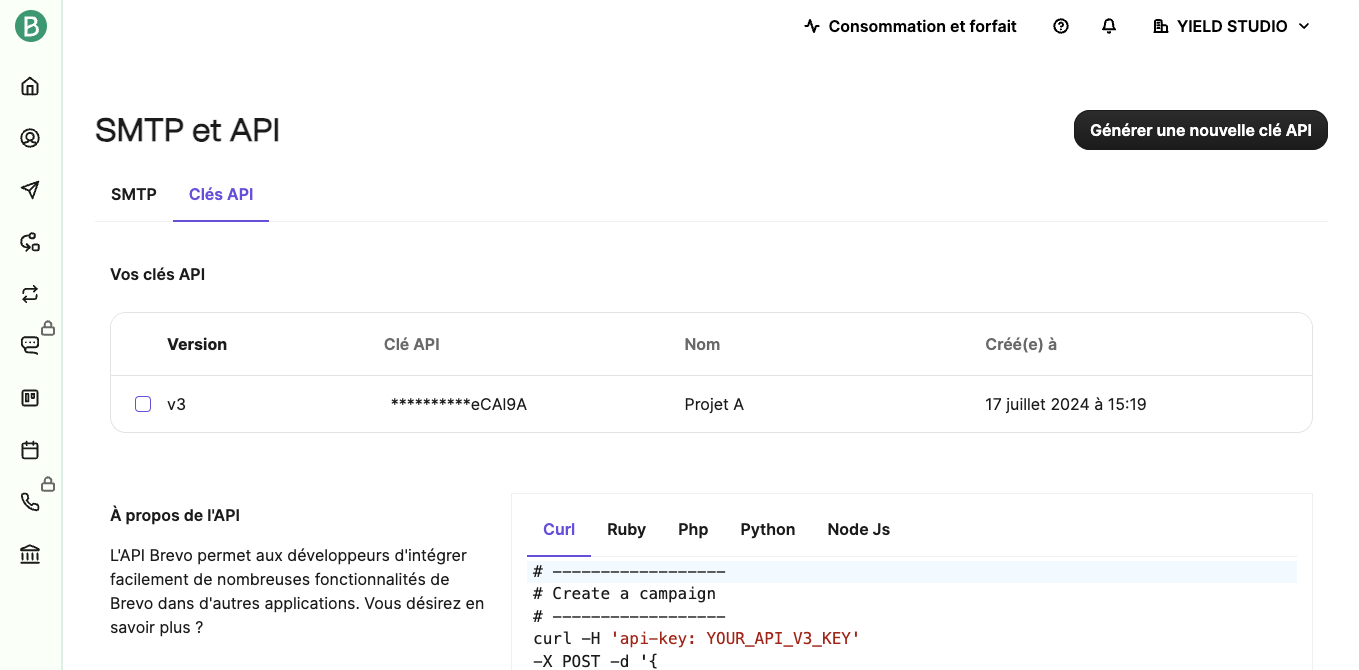

Expose est un outil dont le but est d’exposer des services locaux vers l’extérieur. Il a été développé en PHP par Beyond Code.

Contrairement à ngrok, Expose est une solution OpenSource qui peut être auto-hébergée.

On a donc davantage de contrôle côté serveur et sur le trafic.

Dans quel cas pouvons-nous utiliser Expose ?

Il peut par exemple servir de :

- Debug lors du développement d’une application mobile

En effet, lorsque l’on développe une application mobile on souhaite parfois tester un build de notre application sur les stores.

Notre application n’ayant pas accès à notre API locale, on doit pouvoir ouvrir un accès pour pouvoir tester nos features, notamment sur un build de staging si nous n’avons pas encore d’environnement adéquat en early.

- Faciliter la mise en place de webhook

Qui n’a pas déjà implémenté un service bancaire ?

On peut parfois avoir besoin de créer un webhook accessible depuis le service bancaire pour avoir les codes retours suite à un test de paiement et mettre à jour nos commandes de test.Et pour un système d’authentification avec Facebook ou Google ?Il est possible de paramètrer une URL de Callback en y mettant l’URL Expose afin de tester l’authentification.

Et pour un système d’authentification avec Facebook ou Google ?

Il est possible de paramètrer une URL de Callback en y mettant l’URL Expose afin de tester l’authentification.

- Ou tout simplement exposer un projet en cours de développement.

Pour le montrer à un client lors d’une démo, et afin qu’il puisse tester un POC très rapidement.

Installation

Expose s’installe assez facilement, il suffit d’un serveur qui supporte PHP 7.2 avec composer

En s’assurant que le dossier bon de composer est bien dans le PATH (vous pouvez ajouter cette ligne à la fin du .bashrc selon l’endroit où se trouve vos fichiers composer).

On peut aussi l’installer directement via l’exécutable :

Utilisation

En utilisant le serveur d’expose

Tout d’abord créer un compte sur https://expose.dev.

On obtient ensuite un token que l’on doit activer :

Vous pouvez ensuite démarrer un tunnel sur le port souhaité avec la commande :

Expose génère une URL publique accessible via l’extérieur.

Vous avez également accès à un dashboard pour visualiser les requêtes HTTP http://127.0.0.1:4040

Pour le moment l’utilisation reste la même que pour ngrok, tirons tous les avantages d’expose en auto-hébergeant la solution.

Mise en place de l’auto-hébergement

Prérequis :

- PHP 8.1

- extension sqlite3

- installer expose comme précédemment (celui-ci installe le client et le serveur)

Pour lancer le serveur expose, rien de plus simple, cela se fait en une seule commande :

Dans notre exemple sur mon serveur j’exécute la commande :

L’argument port permet de spécifier un port différent du port 8080 (défaut).

N’oubliez pas d’ouvrir le port en TCP sur le serveur.

J’ai maintenant un tunnel Expose opérationnel !

Il faut maintenant configurer notre client expose sur notre machine pour qu’il passe par notre serveur.

Pour cela il faut modifier le fichier ~/.expose/config.php et y ajouter notre serveur

Vous pouvez également modifier d’autres paramètres dans ce fichier, n’hésitez pas à vous référer à la documentation officielle https://expose.dev/docs/server/starting-the-server

Relancez la commande sur votre machine :

expose share http://monsite.testVoilà, vous exposez à présent votre site local à travers votre serveur !

Avantages par rapport à ngrok

Lorsque l’on utilise ngrok, on peut rapidement être embêté par le fait de ne pas utiliser d’url custom, ce qui force dans certains cas spécifique à redéployer une version de notre application pour utiliser la bonne url, d’autant plus qu’il y a un temps limité à l’utilisation d’une url avec ngrok.

En auto-hébergeant sa propre instance d’Expose on élimine toutes les limites qui nous auraient été imposées :

- Nombre de requêtes (20000 par mois)

- Limite de requêtes par minute (4000 par minutes)

- Limitation du maximum de données (1Go sur la version gratuite de ngrok)

Pricingngrok propose trois versions :

- personal : 8$/dev/mois, ce qui revient à 96$ annuel

- pro : 20$/dev/mois, ce qui revient à 240$ annuel

- enterprise : 39$/dev/mois, ce qui revient à 468$ annuel

Tandis qu’Expose propose (prix annuels) :

- pro : 59$/dev/an

- business : 499$/dev/an

- Enterprise : sur mesure

Il faudra donc bien choisir son offre par rapport à nos besoins, si nos besoins restent basiques, la version personal d’ngrok fera très bien l’affaire.ConclusionExpose constitue une bonne alternative Open Source à ngrok, ce qui permet de ne pas dépendre d’un seul acteur et de confronter deux solutions par rapport à nos besoins.Il permet un contrôle total grâce à son auto-hébergement, sans les limitations imposées par ngrok (requêtes, débit de données, etc.). Les coûts annuels d’Expose sont également plus compétitifs, bien que la version basique de ngrok puisse suffire pour des besoins limités.Aller plus loin avec ExposeNous avons vu comment mettre une instance auto-hébergeable d’Expose, celui-ci permet également d’aller plus loin avec sa gestion d’utilisateurs pour l’authentification, la gestion de domaines, de sites partagés ainsi qu’une interface pour faciliter l’administration.

DSI vs Digital Factory : quelle organisation choisir pour accélérer l’innovation ?

Depuis des années, les DSI sont le moteur technologique des entreprises. Infrastructure, cybersécurité, ERP, CRM… tout passe par elles. Mais face à l’accélération du numérique, ce modèle atteint ses limites : les DSI sont engorgées, les délais explosent, et les métiers cherchent des alternatives pour innover plus vite.

C’est là qu’interviennent les Digital Factories. Ces structures agiles, centrées sur le produit, permettent de contourner les lenteurs des processus traditionnels. Mais faut-il vraiment opposer DSI et Digital Factory ? Ne sont-elles pas complémentaires ?

👉 Dans cet article, on analyse les forces et limites des deux modèles et on vous aide à choisir la bonne organisation pour maximiser votre impact digital.

Pourquoi les DSI peinent à suivre le rythme de l’innovation ?

Historiquement, la DSI est la garante de la stabilité du système d’information. Son rôle principal est de maintenir un SI sécurisé, fiable et performant. Mais face à l’explosion des besoins numériques, ce modèle montre ses limites :

1. Des cycles de développement trop longs

Les méthodes traditionnelles de gestion de projet (cycle en V, waterfall) imposent des délais importants. Résultat ? Il faut parfois plusieurs mois, voire des années, pour livrer une application qui, entre-temps, peut être devenue obsolète.

2. Une dette technique qui freine les évolutions

Beaucoup d’entreprises fonctionnent encore avec des systèmes legacy complexes et coûteux à faire évoluer. Chaque nouvelle application doit s’intégrer avec un SI vieillissant, ce qui ralentit considérablement les déploiements.

3. Une surcharge de demandes

Les DSI doivent gérer une avalanche de projets internes : maintenance du SI, cybersécurité, conformité, support, gestion des infrastructures… Elles n’ont souvent pas la bande passante pour mener des initiatives d’innovation ambitieuses.

4. Une difficulté à recruter et fidéliser les talents

Les profils tech les plus recherchés (développeurs, architectes cloud, experts IA) préfèrent souvent travailler dans des startups ou des structures agiles où ils peuvent coder et livrer rapidement. Dans une DSI traditionnelle, ils risquent d’être freinés par des process trop lourds.

👉 Conséquence : les métiers contournent de plus en plus les DSI en adoptant des solutions SaaS en autonomie (Shadow IT) ou en externalisant leurs projets.

Digital Factory : une alternative plus agile ?

Face à ces limites, de nombreuses entreprises créent leur propre Digital Factory : une entité autonome dédiée à l’innovation digitale. Son objectif ? Produire rapidement des applications et services digitaux à forte valeur ajoutée.

1. Un fonctionnement en mode startup

Contrairement aux DSI, les Digital Factories adoptent un mode produit, avec des équipes pluridisciplinaires capables de livrer rapidement des solutions complètes. Elles travaillent souvent en sprints courts et utilisent des méthodes agiles comme Scrum ou Kanban.

2. Une autonomie technologique

Exit les contraintes des SI historiques : une Digital Factory choisit ses propres outils et technologies (cloud-first, API-first, microservices…). Elle peut ainsi développer et déployer beaucoup plus vite.

3. Un alignement fort avec les métiers

Les équipes produit collaborent directement avec les métiers pour co-construire des solutions adaptées. Pas de cahier des charges rigide, mais un travail en continu avec les utilisateurs finaux pour garantir l’adoption des outils développés.

4. Une culture de l’expérimentation et de l’impact

L’objectif d’une Digital Factory n’est pas de multiplier les POCs, mais de livrer des produits digitaux concrets, utilisés en production. Elle fonctionne avec des KPIs business clairs (adoption, chiffre d’affaires généré, gain de productivité…).

👉 Résultat : alors qu’une DSI peut mettre 18 mois à sortir une application, une Digital Factory peut livrer une première version exploitable en quelques semaines.

DSI vs Digital Factory : opposition ou complémentarité ?

Plutôt que d’opposer ces deux modèles, il est plus pertinent de les faire travailler ensemble. Voici comment bien structurer leur relation :

1. La DSI pose le cadre, la Digital Factory exécute

- La DSI assure la sécurité, la conformité et la scalabilité des solutions développées.

- La Digital Factory expérimente, teste, et livre rapidement des produits digitaux.

- Un dialogue doit être mis en place pour éviter que la Digital Factory ne crée des solutions non intégrables au SI.

2. Un modèle bimodal : stabilité vs innovation

Certaines entreprises adoptent un modèle bimodal :

- Mode 1 (DSI) : Focus sur la fiabilité, la maintenance et l’optimisation du SI existant.

- Mode 2 (Digital Factory) : Axé sur l’innovation, l’agilité et le développement de nouvelles applications.

👉 Ce modèle permet d’accélérer les développements tout en garantissant la robustesse du SI.

3. Une Digital Factory intégrée à la gouvernance IT

- La Digital Factory ne doit pas être un électron libre.

- Elle doit être sponsorisée par la DSI et la direction générale.

- Il faut mettre en place des standards pour assurer une interopérabilité des solutions développées.

4. Une montée en compétences des équipes DSI

- La Digital Factory ne doit pas remplacer la DSI, mais l’aider à évoluer.

- Les DSI peuvent adopter progressivement des méthodes agiles et une approche produit.

- Une montée en compétences sur le cloud, l’IA et l’API-first est essentielle.

Comment choisir la bonne organisation ?

Le choix entre une DSI classique et une Digital Factory dépend de plusieurs facteurs :

✅ Si votre entreprise doit moderniser un SI vieillissant et sécurisé → La DSI reste le bon choix.