Les équipes pensent souvent que faire du CI/CD, c’est avoir un pipeline qui tourne sur GitHub Actions.

En réalité, si votre déploiement nécessite encore un créneau calme, un Slack “ça passe chez vous ?”, ou un rollback artisanal… vous n’avez pas de CI/CD. Vous avez un script qui croise les doigts.

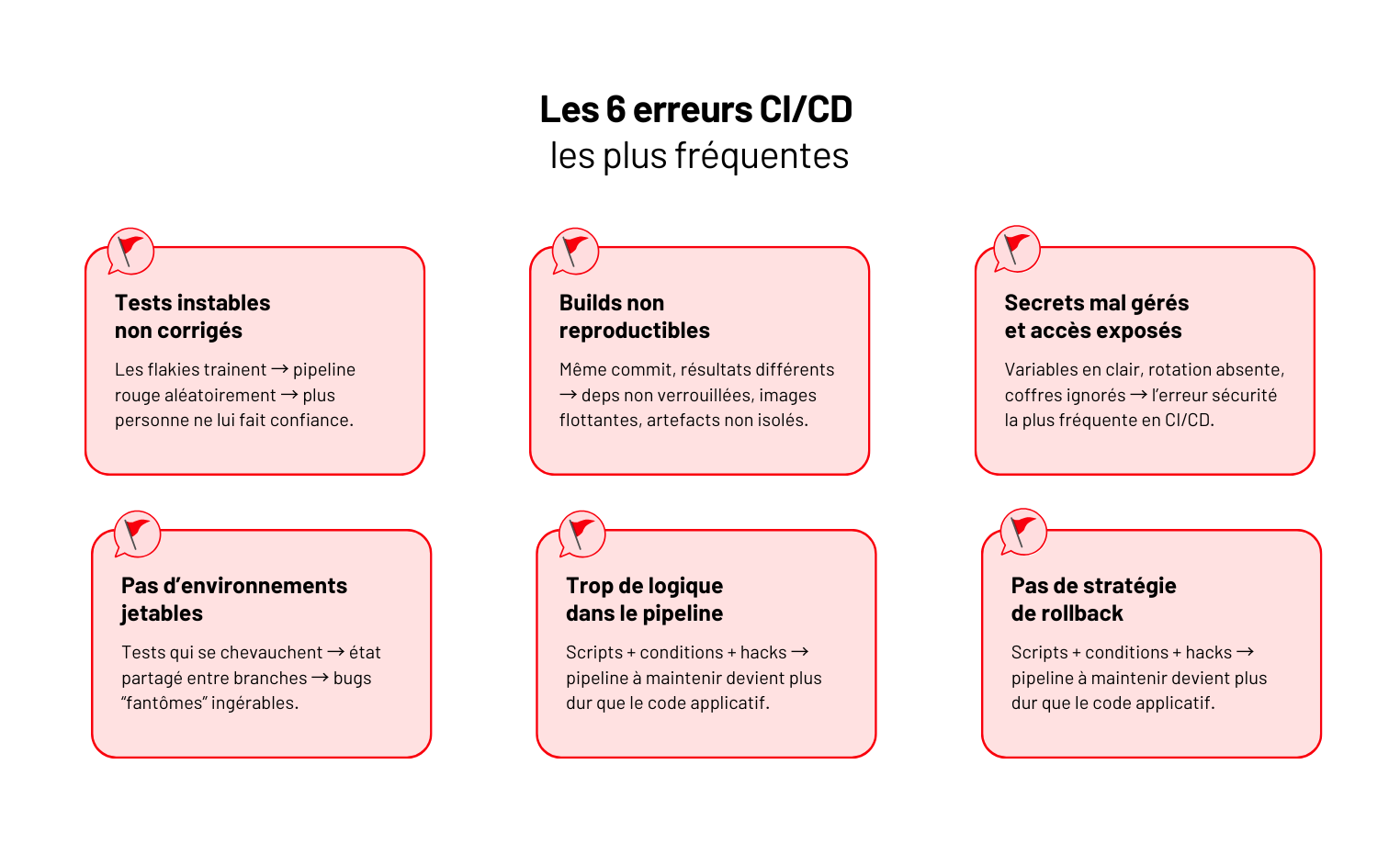

Ce qu’on voit chez Yield ? Des produits solides, plombés par des pipelines bancals : tests qui cassent au hasard, images Docker impossibles à reproduire, secrets exposés, déploiements manuels “juste pour cette fois”… et une équipe qui déploie moins souvent, par peur de casser.

👉 Le CI/CD n’est pas un outil. C’est ce qui détermine si votre produit peut évoluer sans douleur.

Dans ce guide, on simplifie tout : les vraies définitions, les briques indispensables, les bons outils, les pièges qui coûtent cher et les pratiques qui rendent les mises en prod aussi banales qu’une PR.

CI, CD, pipeline : ce que ça veut vraiment dire (et ce que ça ne garantit pas)

Avant de parler outils, runners et YAML, il faut clarifier un point : la moitié des équipes pensent faire du CI/CD… alors qu’elles n’en font que 20 %.

CI - Continuous Integration : stabiliser avant d’accélérer

Le rôle du CI n’est pas de lancer des tests. C’est de garantir que chaque commit peut être intégré sans risquer de casser le reste.

Un vrai process CI, c’est :

- lint + format pour éviter les divergences ;

- analyse statique pour détecter les pièges avant runtime ;

- tests unitaires + intégration qui passent à chaque commit ;

- un build reproductible, versionné, archivé.

👉 Si un développeur peut merge alors que la codebase ne se build pas, vous n’avez pas de CI.

CD - Continuous Delivery : tout est toujours déployable

Le CD ne signifie pas déployé automatiquement en prod.

Le CD signifie : chaque version peut partir en production à n’importe quel moment.

En pratique :

- migrations DB testées ;

- artefacts stockés proprement ;

- environnement de staging miroir ;

- validations automatiques ;

- zéro étape manuelle critique.

Continuous Deployment ≠ Continuous Delivery

La nuance que 80 % des équipes ratent :

- Continuous Delivery → tout est prêt, mais l’humain décide quand déployer.

- Continuous Deployment → tout part automatiquement en production si les checks sont verts.

👉 Le second est impossible si le premier n’est pas fiable.

La plupart des équipes brûlent les étapes.

Le pipeline : la colonne vertébrale

Un pipeline n’est pas un fichier YAML.

C’est la chaîne complète qui va de la PR… à la mise en prod réussie :

Analyse → Tests → Build → Artefact → Déploiement → Vérifications post-déploiement.

Si un maillon casse, tout le reste devient fragile.

Les briques d’un pipeline CI/CD moderne (et l’ordre dans lequel les mettre)

Un bon pipeline ne tient pas à la quantité de jobs. Il tient à l’ordre.

Quand la séquence est mauvaise, vous pouvez avoir GitHub Actions + ArgoCD + Kubernetes… et quand même déployer en serrant les dents.

Voici les briques d’un pipeline moderne dans l’ordre qui évite les mauvaises surprises.

1. Analyse & hygiène immédiate

Avant même de lancer un test, on s’assure que la base est propre.

C’est le garde-fou qui économise des heures de debugging inutile.

Ce qu’on valide ici :

- lint + format (ESLint, Prettier, Flake8) ;

- analyse statique (Semgrep, Sonar) ;

- dépendances vulnérables (Snyk, Trivy).

👉 L’objectif, c’est d’éliminer les erreurs structurelles avant qu’elles ne se propagent.

2. Tests unitaires et intégration légère

Une fois le code propre, on vérifie la logique. Pas la stack complète : la logique.

On exécute :

- les tests unitaires pures ;

- les intégrations rapides (services mockés) ;

- un coverage minimal obligatoire.

Si ça flake ici, c’est le pipeline entier qui deviendra instable.

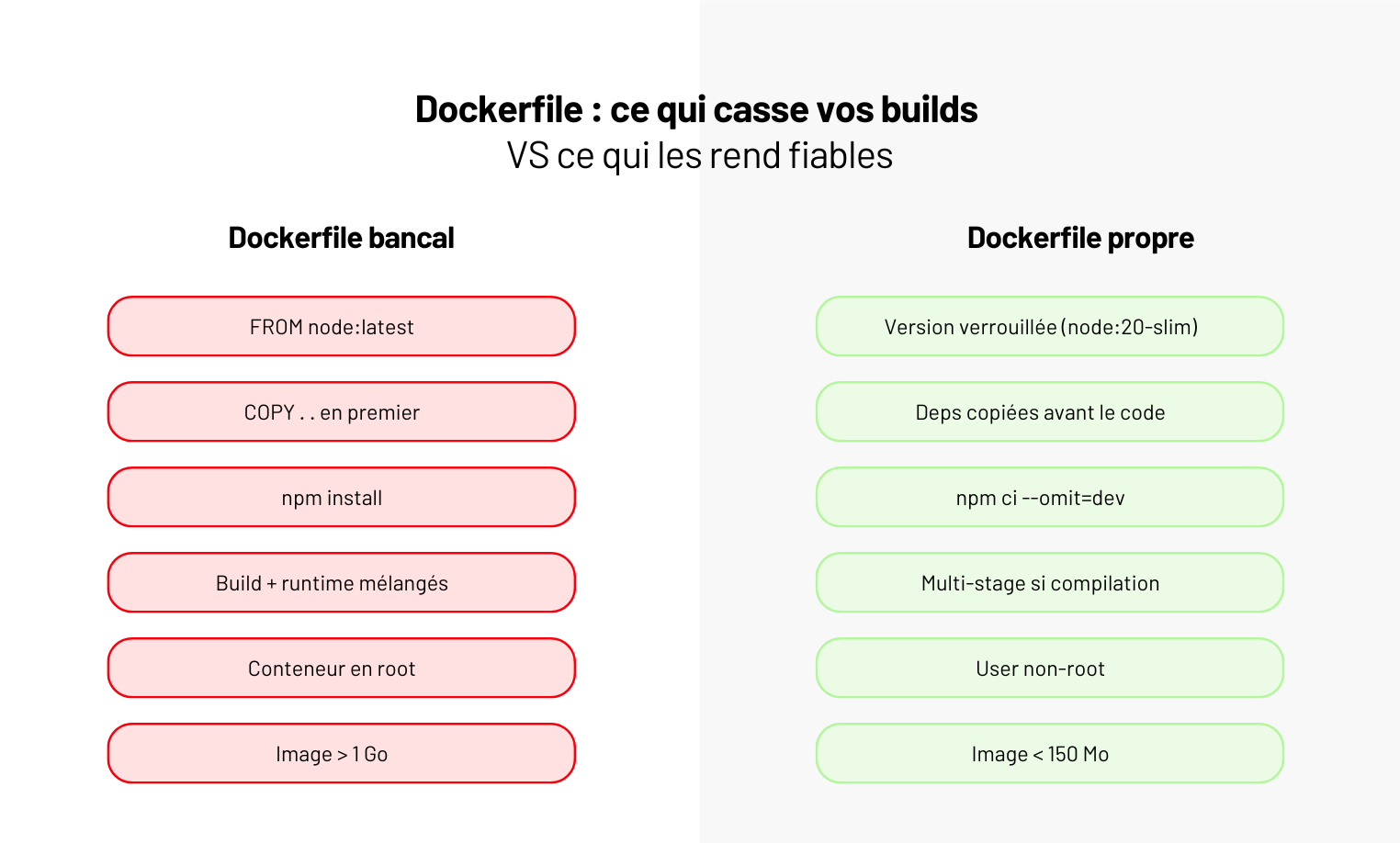

3. Build reproductible

Quand la logique est validée, on fabrique le binaire ou l’image.

Un build doit être identique d’une machine à l’autre.

On verrouille :

- la version du runtime ;

- un Docker multi-stage propre ;

- un artefact hashé et immuable.

4. Tests d’intégration “réels”

C’est là que 70 % des pipelines tombent.

On teste la vraie stack, mais dans un environnement jetable.

On vérifie :

- une vraie base (mais isolée) ;

- des services réels (mais mockables) ;

- le comportement complet de la feature.

C’est ici qu’on détecte les régressions coûteuses.

“Dans quasiment tous les projets où “tout marche sauf en prod”, le point faible était là : les tests d’intégration ne reflétaient pas la réalité.

Quand on a remplacé les mocks par une vraie base jetable et les vrais services, on a révélé 14 régressions en moins d’une demi-heure.

Depuis, on répète toujours la même chose : si cette étape est trop légère, c’est la prod qui encaisse les surprises.”

— Claire, QA Lead @ Yield Studio

5. Packaging & artefacts

Une version qui n’est pas packagée n’est pas une version.

On génère :

- l’image Docker finale ;

- les bundles applicatifs ;

- les migrations DB attachées à la release.

Ce qui n’est pas archivé ne peut pas être déployé proprement.

6. Déploiement automatisé + contrôles

Un déploiement n’est “réussi” que quand la nouvelle version tourne réellement.

On inclut :

- les tests smoke ;

- les healthchecks ;

- le rollback auto ;

- l’alerting en cas de dérive.

👉 Un pipeline sans post-deploy checks, c’est un pipeline qui espère.

Choisir les bons outils : GitHub Actions, GitLab CI, Jenkins, ArgoCD, Terraform…

Un bon pipeline ne dépend pas d’un outil. Mais un mauvais choix d’outil peut vous faire perdre des mois.

Chez Yield, on voit trois profils d’équipes : celles qui ont trop d’outils, celles qui n’en ont pas assez… et celles qui ont Jenkins “parce qu’il était là avant tout le monde”.

On remet un peu d’ordre.

GitHub Actions : le choix par défaut (et souvent le bon)

Si votre repo est sur GitHub, Actions est presque toujours le meilleur point de départ :

- simple à maintenir ;

- écosystème massif d’actions ;

- parfait pour du CI rapide, reproductible, versionné.

⚠️ Son point faible : limité dès qu’il faut orchestrer des pipelines complexes multi-projets.

GitLab CI : le plus complet pour les équipes produit

GitLab CI convient dès que vous voulez tout opérer au même endroit :

- code, issues, sécurité, artefacts, registry ;

- contrôles avancés sur les environnements ;

- logique de pipeline très fine.

👉 Excellent pour les équipes pluridisciplinaires.

Moins flexible que GitHub pour mixer des outils externes.

Jenkins : à éviter (sauf cas très spécifiques)

Jenkins a tout fait avant tout le monde… mais aujourd’hui :

- maintenance lourde ;

- plugins instables ;

- dette opérationnelle garantie.

⚠️ À utiliser uniquement si vous avez une équipe experte dédiée. Sinon : non.

ArgoCD : la référence GitOps

Pour Kubernetes, on ne discute même pas :

ArgoCD = déploiement déclaratif, rollback auto, synchro parfaite entre Git et cluster.

👉 À utiliser pour le déploiement, pas pour le CI (erreur classique qu’on voit partout).

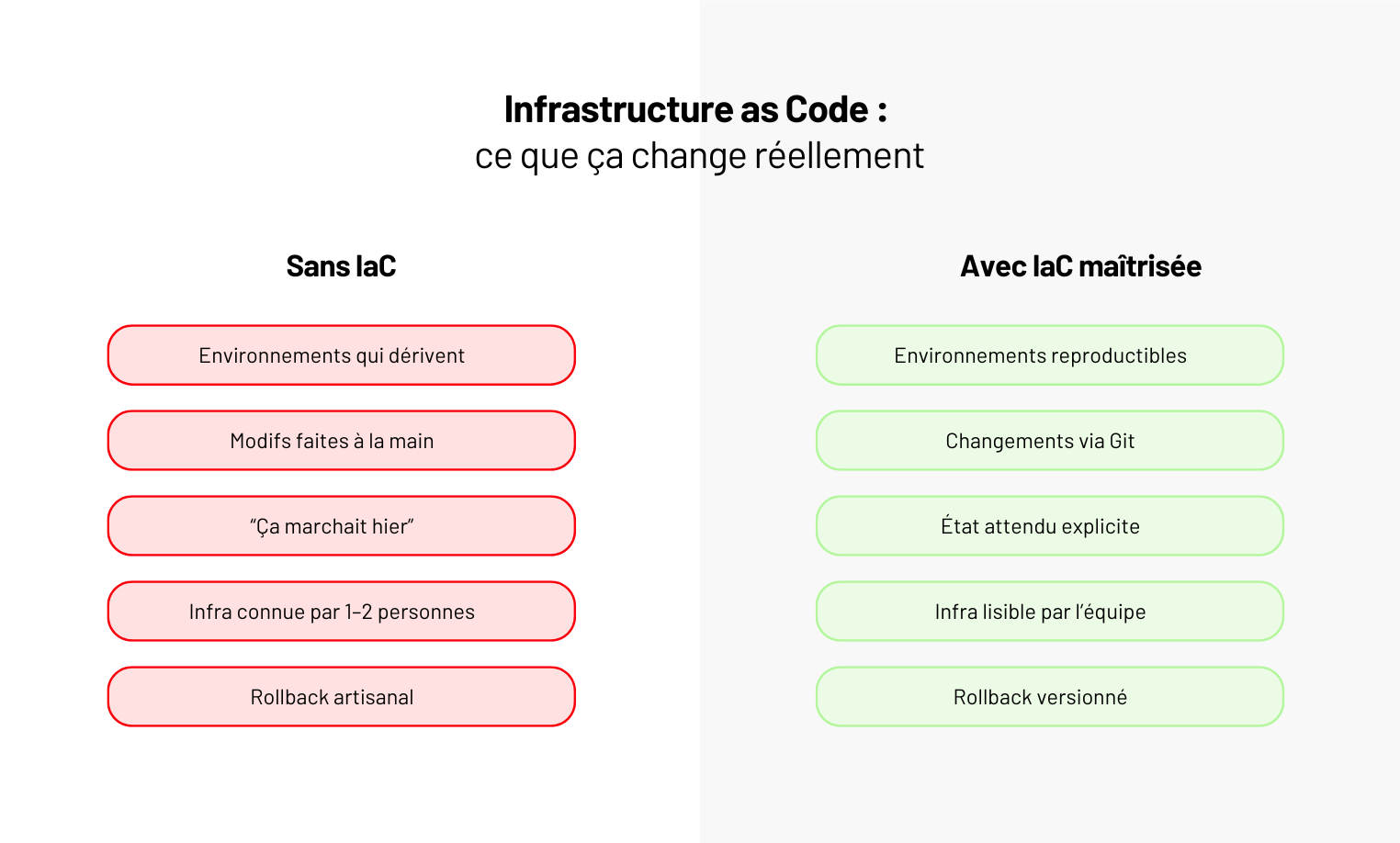

Terraform : indispensable pour l’infra

Si votre infra n’est pas décrite en IaC, votre CI/CD repose sur du sable.

Terraform (ou Pulumi) apporte :

- reproductibilité ;

- auditabilité ;

- environnements clonables.

👉 Sans IaC, pas de déploiement fiable. Point.

🚨 Red flag

Si votre pipeline utilise plus de 3 outils pour faire ce qu’un seul pourrait gérer, ce n’est pas de la modernité. C’est de la dette.

Les best practices CI/CD que 90 % des équipes ignorent

Le problème du CI/CD, ce n’est pas la technique. C’est la discipline.

Les équipes mettent des pipelines… mais rarement les bonnes règles autour.

Voici ce qui fait vraiment passer d’un pipeline “opérationnel” à “fiable au quotidien”.

Rendez tout déterministe

Un build doit produire exactement le même artefact aujourd’hui, demain, et dans six mois.

Sinon vous déboguez des fantômes.

Concrètement, ça passe par :

- versions verrouillées ;

- build immutables ;

- migrations DB idempotentes.

Bloquez les merges sans tests

Oui, même pour les seniors. Quand c’est “facultatif”, les tests deviennent décoratifs. Un pipeline qui ne casse jamais… ne sert à rien.

Cachez intelligemment

Beaucoup activent le cache, peu le maîtrisent.

Les bases à poser :

- cache npm ou pip bien scindé ;

- Docker layer caching ;

- invalidation propre pour éviter les faux verts.

Un bon cache divise les temps de CI par x2 à x5.

Déployez en production tous les jours

Pas pour aller vite. Pour réduire la taille de chaque déploiement.

Plus le batch est petit, plus le rollback est simple, plus le risque baisse.

Les meilleures équipes déploient plusieurs fois par jour - même des micro-patchs.

Ajoutez un “preview environment” pour chaque PR

C’est le raccourci le plus rentable :

- le produit voit avant de valider ;

- la QA teste isolément ;

- les devs détectent tôt les régressions visuelles ou fonctionnelles.

👉 Moins de retours tardifs → moins de cycles perdus.

Coupez la dépendance QA

La QA ne doit pas “valider que ça marche”.

Elle doit valider le produit, pas la qualité du code.

❌ Si la QA attrape des bugs techniques, le pipeline est mauvais.

✅ Si la QA valide des comportements métier, le pipeline est bon.

Conclusion - La qualité d’un pipeline n’est jamais un hasard

Ce qu’on dit systématiquement aux équipes qu’on accompagne : le CI/CD n’est pas un outil, c’est une discipline.

Le choix de GitHub Actions, GitLab, ArgoCD ou Terraform compte… mais ce sont surtout vos règles, votre sécurité, votre IaC et votre gestion des environnements qui font la différence.

Un pipeline moderne n’accélère pas simplement les devs : il stabilise le produit, réduit les régressions, sécurise la release, et libère du temps pour les sujets qui créent réellement de la valeur.

- Bien pensé, le CI/CD devient un avantage stratégique.

- Mal piloté, c’est juste une usine à scripts et à incidents.

Chez Yield, c’est exactement sur ce point qu’on intervient : concevoir des pipelines sobres, fiables, auditables, qui tiennent en prod - et qui ne deviennent jamais un frein à la livraison.

👉 Vous voulez structurer ou moderniser votre CI/CD ? On peut vous aider à construire une chaîne de déploiement qui accélère vraiment votre produit.

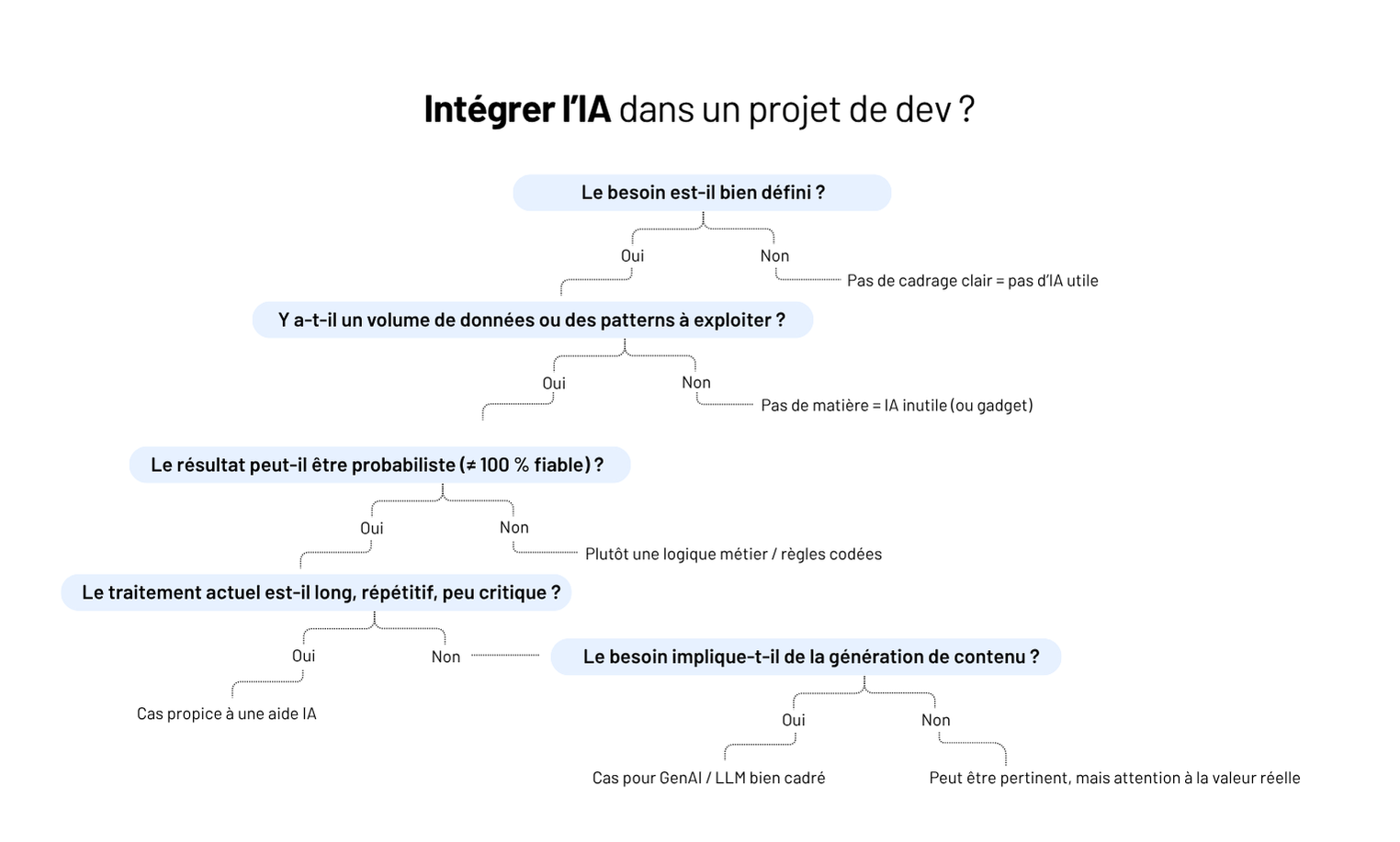

En 2025, tout le monde veut “mettre de l’IA dans son logiciel”. Mais très peu savent ce que ça signifie réellement.

Dans un logiciel métier, l’IA n’est pas là pour faire rêver les comités de pilotage. Elle est là pour résoudre des frictions bien tangibles : la saisie qui prend trop de temps, les documents qu’on ne lit jamais, les validations qui s’enchaînent mal, les données qu’on n’arrive pas à exploiter.

Et c’est justement là que beaucoup de projets dérapent : on confond innovation et utilité, LLM et magie, automatisation et simplification.

Chez Yield, on voit la même histoire se répéter : des intégrations IA qui impressionnent en démo… mais que personne n’utilise en production. Parce que la vraie difficulté n’est pas de brancher un modèle, mais d’intégrer l’IA dans un usage, dans un flux, dans un métier, sans casser ce qui fonctionne déjà.

👉 Dans ce guide, on aborde ce que l’IA change vraiment, les cas d’usage qui tiennent en prod, comment s’y préparer, et comment l’intégrer sans transformer votre logiciel en terrain d’expérimentation.

Ce que l’IA change vraiment dans un logiciel métier (et ce qu’elle ne change pas)

Quand on ajoute de l’IA dans un logiciel métier, on ne change pas l’outil : on change la manière dont les utilisateurs s’en servent.

Et c’est exactement pour ça que l’IA est souvent mal intégrée : on la pense comme une feature alors qu’elle agit comme une mutation du flux métier.

Ce que l’IA change vraiment

La vitesse de traitement des informations

Là où un humain met 3 minutes à comprendre un document, l’IA met 200 ms.

C’est ça, la vraie rupture : tout ce qui dépendait de la lecture, de la synthèse, de l’interprétation… devient instantané.

La densité des tâches

Une opération qui demandait 3 écrans et 6 clics peut se réduire à une intention : “pré-remplis-moi ça”, “trouve-moi l’erreur”, “résume-moi ce ticket”.

L’IA court-circuite la lourdeur des logiciels métiers traditionnels.

La valorisation des données non structurées

Email, PDF, photos terrain, comptes-rendus, messages Slack, tickets…

L’IA transforme tout ce qu’on ne savait pas exploiter en données activables.

Ce que l’IA ne change pas

Le modèle métier

Si la règle métier change selon le jour, la personne ou le contexte, un LLM ne fera que refléter ce chaos.

La robustesse de l’architecture

Intégrer de l’IA dans un système bordélique, c’est brancher une batterie externe sur un moteur qui tousse.

La qualité des inputs

Aucune IA ne rattrape des données contradictoires, incomplètes ou produites par dix équipes différentes.

Retour terrain

“Sur un projet de qualification de dossiers, l’IA donnait des réponses différentes selon les cas. Le client pensait qu’elle hallucinait. En réalité, leurs propres règles variaient d’un opérateur à l’autre.

L’IA n’inventait rien : elle reproduisait l’incohérence métier. Quand les règles sont floues, l’IA amplifie le chaos ; quand elles sont stables, elle fait gagner des semaines.”

— Hugo, Engineering Manager @ Yield Studio

Les 6 cas d’usage IA qui apportent vraiment de la valeur

Dans un logiciel métier, l’IA n’a de valeur que si elle réduit une charge réelle. Pas si elle impressionne en comité.

Chez Yield, on a vu passer des dizaines d’idées IA ; 80 % meurent en atelier car elles ne changent strictement rien au quotidien utilisateur.

Les 20 % restants ? Ceux-ci.

Résumer ce que personne n’a le temps de lire

Dossiers PDF de 40 pages, tickets interminables, comptes-rendus d’intervention, historiques clients : la réalité terrain, c’est que 90 % du contenu n’est jamais lu.

L’IA change la donne en fournissant immédiatement :

- le contexte clé ;

- les points bloquants ;

- ce qu’il faut décider maintenant.

👉 Les utilisateurs arrêtent de scanner au hasard et reprennent le contrôle.

Extraire et fiabiliser les données critiques (sans OCR bricolé)

On ne parle pas ici d’un OCR standard.

On parle d’un modèle qui comprend le document, détecte les incohérences et vous remonte les anomalies :

- un contrat sans date de fin ;

- un SIRET illisible ;

- un montant incohérent ;

- un justificatif manquant.

C’est un des cas d’usage les plus rentables : il transforme un poste chronophage et risqué en flux robuste.

Couper 40 % du temps de saisie via le pré-remplissage intelligent

La plupart des logiciels métiers meurent d’un truc simple : la saisie.

Trop, tout le temps, partout.

L’IA permet enfin de pré-remplir à partir :

- d’un document ;

- d’un historique ;

- d’un contexte métier ;

- d’une simple phrase (“Créer un ordre d’intervention pour la panne X”).

Le gain est immédiat en charge mentale et en vitesse.

Trouver l’info comme on la cherche (pas comme la base a été conçue)

La recherche sémantique, ce n’est pas un luxe : c’est la seule façon de retrouver une info quand votre outil contient 40 notions métier et trois systèmes d’indexation.

Ce que ça débloque :

- retrouver un dossier sans le bon identifiant ;

- identifier un ancien client via un contexte flou ;

- naviguer dans 4 ans d’historique sans exploser.

👉 C’est LA feature qui fait remonter la satisfaction utilisateur.

Classifier, prioriser, router : le travail que les équipes détestent

Personne n’aime ouvrir 200 tickets, trier les mails entrants, prioriser les demandes internes ou classifier les dossiers. Bonne nouvelle : l’IA, si.

Elle peut :

- détecter le sujet réel d’une demande (pas celui du champ “objet”) ;

- déterminer l’urgence ;

- assigner la bonne équipe ;

- proposer le next-step logique.

👉 C’est le premier levier pour faire respirer les équipes back-office.

Identifier les anomalies invisibles aux humains

On ne parle pas de “fraude”. On parle de toutes les micro-incohérences qui font dérailler un workflow :

- champs contradictoires ;

- doublons d’entités ;

- valeurs hors plage logique ;

- comportements utilisateurs anormaux ;

- erreurs qui apparaissent uniquement sur des cas extrêmes.

Ce sont celles qui coûtent cher et que personne ne voit.

💡 Pro tip

Avant d’ajouter une feature IA, posez juste cette question :

“Quel utilisateur gagne combien de minutes par semaine grâce à ça ?”

Si la réponse n’est pas mesurable → abandon immédiat.

C’est la règle qui nous évite 90 % des fausses bonnes idées.

Pré-requis : comment savoir si votre logiciel est vraiment prêt pour l’IA

Avant d’ajouter de l’IA, il faut accepter une réalité simple : 80 % des logiciels métiers ne sont pas prêts. Pas pour des raisons techniques mais pour des raisons structurelles.

Voici les trois signaux qui, chez Yield, déterminent en 15 minutes si un projet IA est réaliste… ou voué à s’écraser.

Le métier est clair (ou pas du tout)

Une IA ne “déduit” rien : elle reproduit.

Si votre règle métier dépend de la personne qui traite le dossier, l’IA va juste rendre la confusion plus rapide.

L’indicateur implacable ? Si on vous demande “ça dépend du contexte” plus de deux fois, on arrête tout.

Les données sont utilisables (ou totalement toxiques)

On n’a pas besoin de Big Data. On a besoin de données cohérentes : mêmes champs, mêmes formats, même logique.

Vous êtes prêts si :

- une même info ne change pas entre trois systèmes ;

- les champs critiques sont systématiquement renseignés.

Vous ne l’êtes pas si :

- vos utilisateurs contournent le logiciel pour “aller plus vite” ;

- un simple export CSV fait remonter des horreurs.

Votre architecture tient debout (ou tient avec du scotch)

L’IA n’aime pas :

- les workflows opaques ;

- les permissions bricolées ;

- les services qui changent d’interface selon l’humeur ;

- les logs impossibles à lire.

On ne demande pas une architecture parfaite.

On demande un système où chaque étape existe pour une raison.

🔍 Test Yield

Demandez à un dev : “On trace où le flux complet d’une action utilisateur ?”

S’il hésite, ce n’est pas prêt.

Comment intégrer l’IA dans un logiciel métier sans tout casser

L’erreur classique : “on ajoute un endpoint IA et on verra”.

Résultat ? La feature marche en démo, explose en production, et personne ne comprend pourquoi l’IA donne des réponses différentes le mardi et le jeudi.

Voici la méthode qui évite 95 % des dérives - celle qu’on applique dans tous les projets IA métier que l’on pilote.

1. Commencer par un irritant métier, pas par une techno

On ne part jamais d’un modèle (“on veut du GPT-4o”).

On part d’un geste utilisateur qui fait perdre du temps.

Un seul.

Exemples :

- “Valider un dossier prend 12 minutes.”

- “On lit 20 PDF par jour pour trouver les 3 mêmes infos.”

- “On réécrit toujours les mêmes messages.”

Si l’irritant n’est pas mesurable → on arrête tout de suite.

2. Prototype en isolé (jamais directement dans votre logiciel)

On teste l’IA hors du produit, dans un bac à sable.

Le but, c’est de vérifier que le modèle comprend vraiment votre métier avant d’écrire une ligne de code côté application.

Ce proto permet de valider :

- la qualité des réponses ;

- la robustesse sur les cas tordus ;

- les risques d’ambiguïté ;

- le coût d’inférence.

Quand ça tient 30 cas d’usage réels → seulement là, on intègre.

3. Encadrer l’IA dans un flux contrôlé (pas en roue libre)

Dans un logiciel métier, l’IA ne doit jamais :

- décider seule ;

- modifier des données critiques sans validation ;

- contourner les règles métier.

On utilise l’IA comme :

- pré-remplissage ;

- suggestion contextualisée ;

- accélérateur de décision ;

- analyseur de contenus.

Mais l’utilisateur reste le gardien du workflow.

4. Versionner, loguer, tracer (sinon vous serez aveugles)

Une intégration IA sans traçabilité, c’est un ticket support assuré dans la semaine.

Au minimum :

- logs des prompts (anonymisés) ;

- logs des inputs métier ;

- version du modèle utilisé ;

- retour utilisateur (validation / correction).

Ça permet de comprendre où le modèle se trompe, pourquoi, et comment l’améliorer sans deviner.

5. Commencer petit : déployer sur 5 % des utilisateurs

Jamais en big bang.

Toujours avec un groupe pilote métier qui vit la réalité du terrain.

Lorsqu’on déploie une feature IA chez Yield :

- on expose d’abord 5 % des utilisateurs ;

- on observe 7 jours ;

- on corrige ;

- puis on élargit.

C’est ce cycle qui transforme une bonne idée IA en feature réellement adoptée.

💡 Règle Yield

Une IA utile doit survivre à trois tests :

- Comprendre vos données réelles (pas vos exemples propres).

- Accepter la contradiction (et ne pas s’effondrer en cas d’anomalie).

- Réduire une charge dès la première semaine (sinon elle ne sera jamais utilisée).

Conclusion - L’IA n’améliore pas un logiciel métier. Elle le révèle.

L’IA ne transforme pas un logiciel par magie.

Elle accélère ce qui est clair, expose ce qui est flou et amplifie tout ce qui était déjà fragile.

Les intégrations IA qui fonctionnent en 2025 sont celles qui :

- partent d’un irritant métier réel ;

- s’appuient sur des données propres et des règles stables ;

- sont cadrées, loguées, versionnées ;

- et restent sous contrôle de l’utilisateur.

Le reste - les assistants “génériques”, les features gadget, les démos qui font briller les yeux - disparaît dès la première semaine d’usage réel.

Chez Yield, on conçoit des intégrations IA qui tiennent en prod, parce qu’elles sont pensées pour le métier : pré-remplissage, résumé, extraction, recherche sémantique, routage, détection d’anomalies… des briques concrètes, mesurables, qui font gagner du temps dès le jour 1.

👉 Vous envisagez d’intégrer l’IA dans votre logiciel métier ? On peut vous aider à cadrer les cas d’usage, sécuriser l’intégration et transformer l’IA en vrai levier opérationnel - pas en effet d’annonce.

“L’IA va remplacer les développeurs.” Vous l’avez entendu aussi ? Mais dans le développement logiciel sur-mesure, la réalité est autre. Les projets sont complexes, spécifiques, souvent construits from scratch. Pas question de générer une app complète en trois prompts.

En revanche, ce qu’on voit très concrètement chez Yield, c’est autre chose :

- des cas d’usage IA bien ciblés, qui font gagner un temps précieux ;

- des intégrations simples qui fiabilisent les étapes critiques ;

- des automatisations qui soulagent les équipes, sans alourdir les process.

Pas besoin de former une AI Squad ni de tout repenser. Mais avec les bons outils, et les bonnes idées, l’IA devient un levier très concret pour mieux documenter, mieux tester, mieux comprendre les données, mieux collaborer produit / dev / métier.

Dans cet article, on partage 5 cas d’usage IA réellement utiles dans des projets web sur-mesure. Testés, adoptés, adaptables.

Pourquoi l’IA a vraiment un intérêt dans le dev sur-mesure

Le développement logiciel sur-mesure, ce n’est pas juste “coder une app” — c’est comprendre un besoin spécifique, poser une architecture propre, livrer avec qualité… souvent dans des environnements métier complexes.

👉 Et c’est justement là que l’IA peut faire la différence : pas pour remplacer les développeurs, mais pour accélérer, fiabiliser, et documenter là où ça compte.

Ce qu’on voit sur le terrain, côté Yield :

- Gagner du temps sur les tâches à faible valeur ajoutée : générer des jeux de données de test, formater une documentation, proposer des templates de tests unitaires…

- Rendre visible ce qui ne l’est pas : synthétiser des logs, analyser du legacy, détecter des patterns dans un historique projet.

- Faciliter le lien produit-dev : transformer une spec produit en ébauche de tests, d’API ou de règles métier.

- Automatiser certaines vérifications : reviewer une PR, analyser un prompt, suggérer une correction.

⚠️ Mais tout ça ne marche que si :

- les prompts sont bien cadrés (sinon, l’IA hallucine) ;

- les inputs sont propres (sinon, les réponses sont inutiles) ;

- et les usages sont ciblés (sinon, c’est juste une démo gadget).

💡 Ce qu’on répète souvent : une IA bien utilisée, c’est une IA qui fait gagner du temps sans créer de dette.

Cas #1 - Générer du code répétitif ou boilerplate

Certaines tâches reviennent encore et encore : créer des modèles CRUD, poser la base d’un composant frontend, générer une couche d’API ou d’accès aux données… Rien de complexe — mais beaucoup de copier-coller.

👉 Avec des prompts bien calibrés, une IA comme GPT-4 peut :

- générer un service TypeScript ou Python à partir d’un modèle métier ;

- proposer une structure d’API REST cohérente avec un use case ;

- créer les squelettes de tests unitaires basés sur un fichier de code.

Retour d’XP :

“Sur un projet d’outils RH, on utilisait un prompt maison pour générer les services backend à partir du modèle métier. Ça nous a vraiment accélérés sur la mise en place. Et comme c’était relu derrière, on gardait la maîtrise technique.”

— Simon, Lead Dev @Yield Studio

⚠️ À garder en tête :

- L’IA ne remplace pas les choix d’architecture.

- Il faut toujours relire, adapter, tester.

- C’est un outil pour accélérer, pas pour déléguer des décisions tech.

Bien utilisé, c’est un vrai booster sur les phases d’amorçage — surtout sur des architectures déjà balisées (Clean Architecture, DDD light…).

Cas #2 - Accélérer l’écriture de tests (unitaires, end-to-end, contractuels)

Écrire des tests est essentiel — mais reste parfois perçu comme une contrainte. Et sur des projets où les deadlines sont serrées, c’est souvent le premier poste sacrifié. Pourtant, bien accompagnée, l’IA peut réduire drastiquement le temps passé à écrire les tests… sans rogner sur leur qualité.

Concrètement, elle peut servir à :

- Générer un test unitaire complet à partir d’un service ou d’un composant React.

- Proposer des cas limites à tester automatiquement, y compris les erreurs.

- Suggérer une suite de tests e2e en partant d’un scénario métier rédigé.

Retour d’XP :

“Sur une plateforme de contrats, on a demandé à GPT de générer des tests à partir de nos scénarios Gherkin. C’était pas 100 % plug and play, mais ça posait déjà une bonne base. Le plus dur (la structure) était fait.”

— Claire, QA Engineer @Yield Studio

👉 L’IA est particulièrement utile pour les tests oubliés (erreurs, edge cases), pour produire vite une couverture de base sur un projet existant, pour onboarder une équipe dev sur un projet déjà lancé.

⚠️ À condition d’avoir :

- une logique métier claire (sinon les tests sont à côté) ;

- une stack testable (Cypress, Vitest, Jest…) bien en place.

Cas #3 - Booster la productivité avec un “pair dev IA”

Sur certains projets, surtout en phase de montée en charge, l’IA peut jouer un rôle inattendu : celui de coéquipier technique. Pas pour remplacer — mais pour soutenir le raisonnement, débloquer un problème, ou générer un brouillon de code plus vite.

Ce qu’on voit de plus en plus chez nos devs :

- Besoin d’un snippet rapide pour parser une date ISO complexe ? Le LLM propose plusieurs approches en quelques secondes.

- Une regex tordue à écrire ? On l’obtient en 2 prompts, testée et expliquée.

- Une lib mal documentée ? L’IA peut générer un exemple minimal pour gagner du temps.

Le vrai gain ? On passe moins de temps à chercher, à scroller sur Stack Overflow ou à déchiffrer des documentations opaques. Et plus de temps à réfléchir à la structure du code et aux vrais enjeux du projet.

Retour d’XP :

“Nos devs juniors utilisaient Cursor pour les petits blocages du quotidien. C’est pas magique, mais quand tu galères sur une regex ou un parsing un peu relou, ça te fait gagner 30 minutes. Et côté seniors, on sentait que ça fluidifiait les revues.”

— Hugo, Engineering Manager @Yield Studio

⚠️ Limite à poser impérativement : ne pas “copier-coller” sans relire. L’IA peut halluciner, ou générer du code inutilement complexe. Chez Yield, on garde la règle : ce que l’IA propose, c’est un point de départ — pas un livrable.

Cas #4 - Créer une documentation technique plus fluide (et vivante)

La documentation est souvent le parent pauvre d’un projet logiciel. Manque de temps, flemme, ou difficulté à bien formuler ce qu’on fait… Résultat : des pages obsolètes, des README vides, des devs perdus en onboarding.

C’est là qu’un LLM bien utilisé peut faire gagner un temps précieux.

Cas concrets vus chez Yield :

- Générer un premier brouillon de README à partir des noms de fichiers, commentaires et structure du projet ;

- Résumer une PR complexe en langage naturel pour mieux partager son contenu ;

- Expliquer un morceau de code métier à un·e dev non expert·e du domaine.

👉 L’IA n’écrit pas la doc à votre place. Mais elle vous aide à passer le cap du “syndrôme de la page blanche”. Et à garder une base claire, lisible, accessible à tous.

Retour d’XP :

“Sur un SaaS santé, on avait branché un bot sur nos repos pour proposer un résumé de PR à chaque merge. C’était imparfait, mais hyper utile en relecture ou pour onboarder. On l’a vite gardé dans le process.”

— Lucie, Product Builder @Yield Studio

⚠️ Attention à la dérive “doc générée à l’aveugle”. Ce n’est pas parce que l’IA écrit bien qu’elle comprend. On garde la main pour valider — et on évite les formulations floues ou imprécises.

Cas #5 - Générer des jeux de données de test réalistes

Tester une app avec des données factices, c’est souvent le cauchemar : prénoms bidons, dates incohérentes, données trop propres. Et pourtant, un bon jeu de test fait toute la différence pour détecter les bugs, simuler des cas limites… et valider des features avant la prod.

Là aussi, l’IA peut aider — si elle est bien cadrée.

Cas d’usage concrets :

- Générer des profils utilisateurs complets et réalistes (avec cohérence entre prénom, mail, date de naissance, etc.) ;

- Créer des scénarios métier riches : ex. utilisateurs inactifs depuis X mois, comptes incomplets, transactions en erreur…

- Simuler des comportements “extrêmes” : erreurs saisies, chaînes longues, formats inattendus.

👉 Utiliser un modèle GenAI ou une librairie boostée au prompt engineering permet de produire des jeux de données plus proches du réel, avec moins de scripts maison à maintenir.

Retour d’XP :

“L’IA nous a permis de générer des jeux de données métier avec des cas tordus (incohérences, doublons, profils incomplets). Pour la QA, c’était clairement un plus : on détectait plus de bugs, plus tôt.”

— Antoine, Tech Lead @Yield Studio

⚠️ On ne laisse pas un LLM créer n’importe quoi. On fixe des règles : format, cohérence, diversité. Et surtout, pas de données perso réelles en entrée. Jamais.

Conclusion — L’IA ne remplace pas les devs. Elle leur fait gagner du temps (quand elle est bien utilisée).

Utiliser l’IA dans un projet sur-mesure, ce n’est pas “suivre la tendance”. C’est identifier ce qui mérite d’être accéléré, enrichi, automatisé — sans sacrifier la qualité, la compréhension métier ou la maintenabilité.

👉 Générer du code, résumer un ticket, compléter un test, préparer un jeu de données : tous ces “petits” gains peuvent, à l’échelle d’un projet, transformer la vélocité.

Mais ça ne marche que si :

- on cible les bons cas d’usage, là où l’IA apporte une vraie valeur ;

- on intègre l’outil dans un cadre maîtrisé (inputs, outputs, responsabilités) ;

- et on garde une équipe responsable, qui comprend ce qu’elle livre.

Chez Yield, on ne déploie pas l’IA pour faire joli. On l’utilise pour aider les équipes à aller plus vite sans créer de dette— sur des produits métier où la robustesse compte.

👉 Vous explorez l’IA dans un contexte dev ? On peut vous aider à cadrer les bons cas, outiller vos équipes, et avancer concrètement.

“On pourrait mettre de l’IA.” Une phrase qu’on entend souvent — et qui peut tout vouloir dire… ou rien.

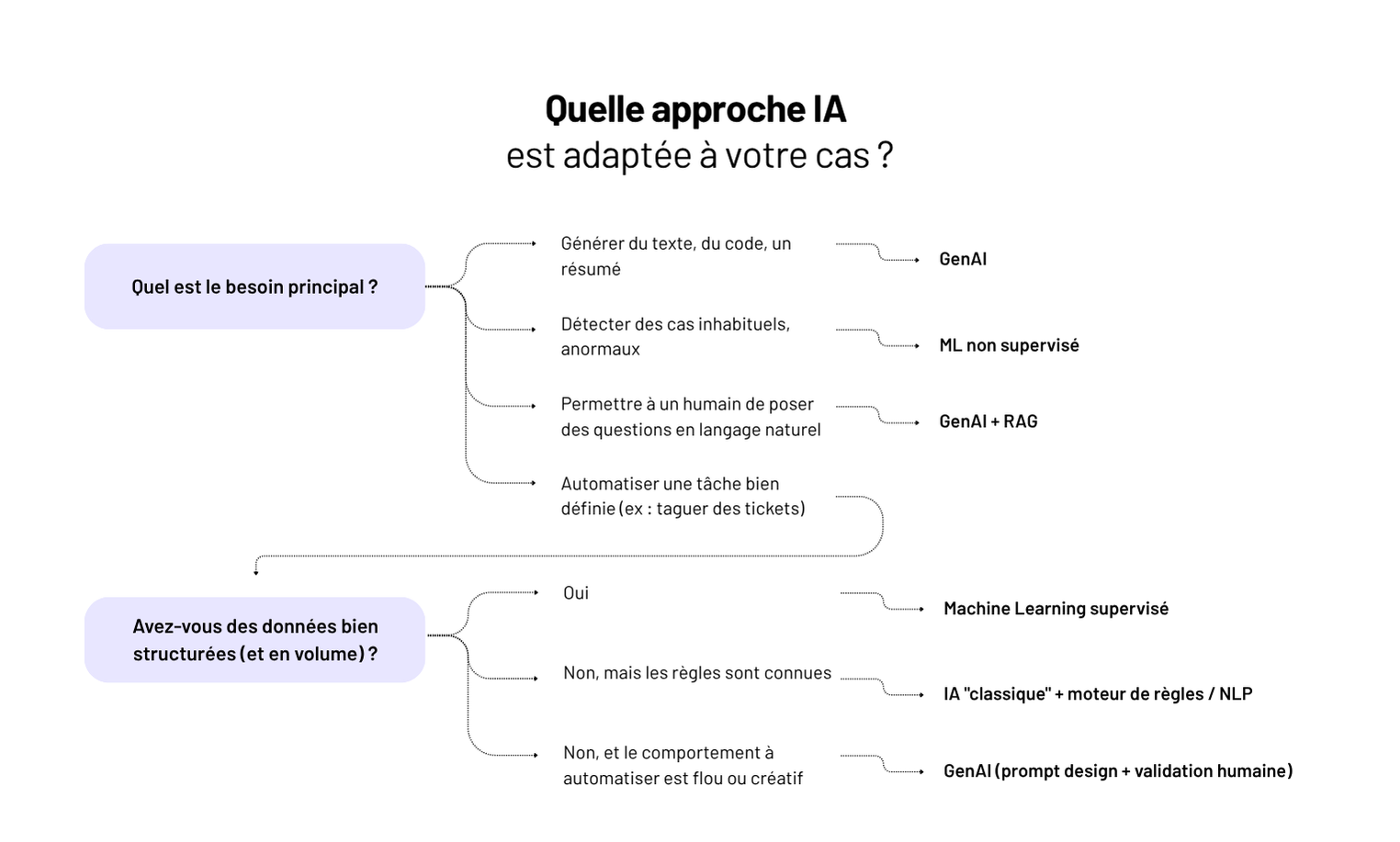

IA, machine learning, GenAI : trois termes partout, souvent mélangés, rarement compris. Et derrière, des décisions mal cadrées, des attentes floues, des projets qui patinent.

Chez Yield, on conçoit des produits web sur mesure. Et on intègre parfois de l’IA — mais jamais “pour faire de l’IA”. Seulement quand ça sert un usage, avec la bonne approche : algo maison, moteur ML, ou API GenAI.

Dans cet article, on vous aide à poser les bases :

- IA vs ML vs GenAI : les vraies définitions, sans jargon ;

- Ce que ça change sur un produit, une stack, une roadmap ;

- Et comment prendre les bonnes décisions côté produit et tech.

👉 Pour faire de bons choix, mieux vaut comprendre les fondamentaux — que suivre la hype.

IA vs ML vs GenAI : les vraies définitions

IA (Intelligence Artificielle)

C’est le concept global : faire exécuter à une machine des tâches qu’on associe à de l'intelligence humaine.

👉 Exemples : reconnaître des visages, classer des documents, planifier un itinéraire…

Mais c’est un terme fourre-tout. Tout ce qui est “un peu intelligent” y passe : moteur de règles, chatbot basique, modèle prédictif…

ML (Machine Learning)

C’est un sous-domaine de l’IA. Ici, la machine apprend à partir de données : elle ne suit pas des règles codées à la main, elle déduit des modèles à partir d’exemples.

👉 Exemples :

- prédire si un client va churner ;

- reconnaître une adresse postale sur un scan ;

- estimer la probabilité d’un retard logistique.

Il faut des données propres, structurées, suffisantes. Le ML est puissant, mais exigeant en préparation.

GenAI (IA générative)

C’est une autre branche : générer du texte, des images, du code, du son… à partir d’une consigne.

Elle repose souvent sur des LLMs (large language models), comme GPT, Claude ou Mistral.

👉Exemples :

- résumer un ticket client ;

- générer un mail de relance ;

- reformuler une fiche produit.

À retenir :

- IA = le domaine large, parfois flou ;

- ML = apprendre à partir de données ;

- GenAI = produire du contenu à partir d’un prompt.

Des cas d’usage concrets pour comprendre

Plutôt qu’un débat théorique, mieux vaut partir des problèmes concrets qu’on cherche à résoudre — et voir quelle approche IA/ML/GenAI est adaptée.

Classer automatiquement des documents

👉 Machine Learning supervisé

Exemple : classer des factures, des contrats, des CV.

On entraîne un modèle sur des données labellisées (ex. : “facture EDF”, “contrat freelance”) → il apprend à généraliser.

Automatiser une réponse client simple

👉 IA “classique” ou règles + NLP

Exemple : chatbot support qui répond à “Comment changer mon mot de passe ?”

On peut combiner détection d’intention, règles et base de connaissance. Pas besoin de GenAI.

Résumer un ticket ou reformuler un texte

👉 IA générative (LLM)

Exemple : un PM veut un résumé de 15 retours clients.

Un modèle comme GPT peut générer une synthèse exploitable, ou reformuler dans le ton de marque.

Détecter une anomalie métier (fraude, erreur, comportement inhabituel)

👉 Machine Learning non supervisé

Exemple : détection de factures atypiques, d’abus d’usage, ou d’activité incohérente.

Le modèle apprend la “norme” et alerte quand on s’en écarte.

Besoin : interroger ses données métier “en langage naturel”

👉 IA générative + intégration métier

Exemple : “Combien d’inscrits en mai par canal d’acquisition ?”

Un LLM traduit la question en requête sur la base de données — à condition d’avoir un schéma clair + couche de validation.

💡La clé, ce n’est pas “quelle techno est la plus puissante ?” mais “quelle techno résout votre problème avec le bon ratio effort/valeur ?”

Ce que ça change côté produit

Quand on intègre de l’IA, du ML ou de la GenAI dans une app, on ne parle plus d’une feature classique. Côté produit, il faut changer de posture : cadrer l’imprévisible, piloter par la valeur, et assumer une logique d’exploration.

Le besoin métier ne suffit pas. Il faut poser un comportement cible.

Une IA ne répond pas à “je veux automatiser ça” mais à “dans 80 % des cas, je veux éviter cette tâche”.

👉 Il faut traduire le besoin en cas d’usage clair, observable, avec un critère de succès réaliste. Pas une promesse floue d’intelligence.

La qualité se mesure différemment.

Pas de “ça marche / ça marche pas”. Il faut accepter du bruit, cadrer la tolérance à l’erreur, tester avec des données réelles.

➡️ On parle d’évaluation continue, pas de validation en spec.

Le design produit doit encadrer les limites.

Une GenAI qui hallucine ? Un modèle qui dérive ? Le rôle du PM, c’est aussi de définir les garde-fous : seuils, fallback, formulation des prompts, contexte affiché, etc.

👉 Une UI d’IA sans cadrage, c’est une UX qui déçoit — voire un produit inutilisable.

La méthode change : moins de ticketing, plus de prototypage.

Ce n’est pas une story = une PR. Il faut maquetter, tester vite, jeter si besoin.

💡 Chez Yield, on pose souvent un sprint 0 orienté “preuve de valeur” — pas de specs, juste : cas d’usage, données, test simple, go/no go.

Ce que ça suppose côté équipe

Adopter une démarche IA ou ML, ce n’est pas “ajouter une techno”. C’est changer la manière de penser, concevoir, et livrer un produit. Et ça suppose des responsabilités bien réparties dans l’équipe.

Côté produit : poser les bonnes questions.

On ne spécifie pas une IA comme un formulaire. Il faut cadrer autrement :

- Quelle tâche veut-on accélérer, automatiser, ou enrichir ?

- Quel niveau de confiance est acceptable ?

- Que fait-on quand le modèle se trompe ?

👉 Le PM devient l’orchestrateur de scénarios probabilistes, pas de parcours figés.

Côté tech : garantir la robustesse du système complet.

Utiliser un LLM ou un modèle ML, ce n’est pas juste un appel d’API.

- Est-ce qu’on comprend ce que le modèle fait vraiment ?

- Est-ce qu’on trace, loggue, mesure les sorties ?

- Est-ce qu’on gère bien les erreurs, les temps de latence, les versions ?

👉 Un système IA bien conçu, c’est observable, testable, rollbackable.

Côté design : rendre l’IA explicable et actionnable.

- Que fait la machine, et pourquoi ?

- Peut-on corriger, ajuster, affiner ?

- L’utilisateur a-t-il confiance, ou subit-il une “boîte noire” ?

👉 On design une expérience, pas juste une réponse IA.

Côté orga : sortir du cycle build–ship–forget.

Un produit IA, ça s’entraîne, ça s’ajuste, ça évolue.

- Qui est responsable des prompts ?

- Quand réentraîne-t-on le modèle ?

- Qui surveille la qualité en continu ?

👉 Chez Yield, on pose une gouvernance claire : ownership produit, cycle d’itération court, monitoring live.

💡 Ce qu’on voit : une bonne équipe IA, ce n’est pas une cellule d’experts. C’est une équipe pluridisciplinaire qui accepte l’incertitude — et sait structurer autour.

Bien choisir sa stack (et ses partenaires)

Pas besoin d’un LLM maison ou d’un data lake à six zéros pour intégrer de l’IA dans un produit. Mais il faut faire les bons choix — sinon, vous multipliez les coûts, les risques, et la dette technique.

Premier choix structurant : build ou buy.

Vous pouvez vous appuyer sur des modèles existants (OpenAI, Hugging Face, Claude, etc.) ou construire en interne.

- Si le besoin est standard (résumé, classification, suggestion…), des APIs externes suffisent.

- Si le besoin est spécifique ou sensible (modèle métier, données internes), il faut envisager un fine-tuning ou un modèle hébergé en local.

Ensuite : le chaînage des outils.

RAG, vecteurs, orchestrateurs (LangChain, LlamaIndex…), monitoring, guardrails… Une bonne stack IA, ce n’est pas “juste un appel à l’API”. C’est un système à concevoir comme un morceau d’architecture produit.

Et côté partenaires ?

Attention aux prestataires IA “full blackbox” ou aux intégrations magiques promises en 3 jours. Une bonne intégration IA, ça se pense côté métier, côté dev, et côté usage — pas juste côté algo.

💡 Ce qu’on fait chez Yield :

- Prioriser les cas d’usage, puis tester rapidement avec des composants existants ;

- Valider l’impact réel avant de choisir une stack longue durée ;

- Éviter la stack IA “bricolée” qui deviendra ingérable en prod.

Bonus : 5 questions à se poser avant d’ajouter de l’IA à son produit

Quel est le problème métier précis à résoudre ?

Pas “faire de l’IA” — mais gagner du temps, réduire des erreurs, améliorer l’expérience.

Les données nécessaires existent-elles ?

Modèle ML = données propres + étiquetées. GenAI = contexte clair + prompt bien formulé.

Quel niveau de tolérance à l’erreur est acceptable ?

Une prédiction à 90 % ? Une génération de texte imprécise ? Il faut cadrer ça dès le départ.

Le résultat est-il explicable, actionnable ?

Un utilisateur ne doit jamais se demander “pourquoi ça a répondu ça”.

Le ROI est-il mesurable ?

Gain de temps ? Moins de support ? Conversion augmentée ? Un bon projet IA s’évalue, pas juste “s’impressionne”.

💡 Vous n’avez pas besoin d’un modèle maison. Vous avez besoin d’un problème clair + solution testable.

Conclusion — Pas de magie, mais une vraie opportunité

IA, ML, GenAI… Derrière les buzzwords, une réalité simple : ces technologies peuvent vraiment transformer un produit — si on les intègre avec méthode.

Ce n’est pas un effet de mode. C’est un levier à intégrer dans une stratégie produit claire :

- des cas d’usage bien cadrés ;

- une stack qui tient en prod ;

- une équipe prête à en assumer les implications.

Chez Yield, on ne vend pas de promesse “AI-first”. On conçoit des produits utiles, testables, maintenables — avec ou sans IA.

Vous avez un cas d’usage IA à structurer, ou une opportunité GenAI à valider ? On peut vous aider à faire les bons choix. Sans bullshit. Et sans dette.

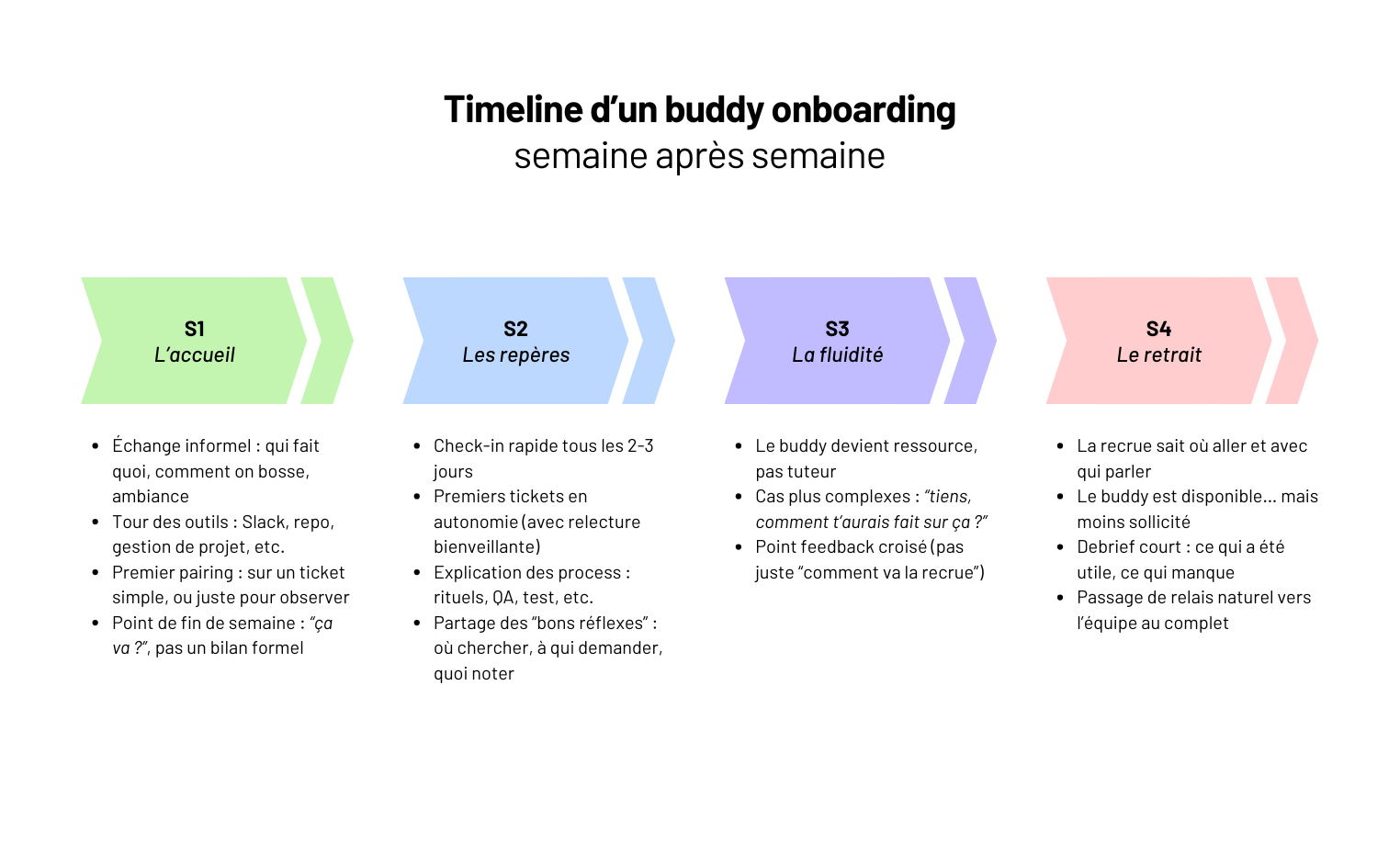

Premier jour, ordi prêt, doc Notion partagée, “n’hésite pas si tu as des questions”… Et puis ? Silence. Trois jours plus tard, la nouvelle recrue a toujours la PR de setup en brouillon. Personne n’a le contexte. Et l’équipe court sur d’autres sujets.

C’est comme ça que beaucoup d’onboardings se passent — même dans des équipes bienveillantes. Pas par négligence. Mais parce qu’on confond “accueillir” et “intégrer”.

👉 Un bon onboarding, ce n’est pas juste une checklist. C’est un vrai passage de relais : transmettre les réflexes, les décisions implicites, la manière de bosser ensemble. Tout ce qui ne s’écrit pas dans un wiki.

C’est là que le buddy onboarding change la donne. En plaçant une personne référente, dédiée à l’accompagnement, on fluidifie l’arrivée. On crée un lien humain. On réduit la phase “je galère dans mon coin”.

Chez Yield, on l’utilise sur nos projets tech à impact. Dans ces contextes où la montée en compétence rapide est déterminante, le buddy onboarding fait gagner des semaines.

Dans cet article :

- le vrai rôle d’un buddy (et ce qu’il n’est pas) ;

- quand ce modèle fonctionne vraiment ;

- comment l’appliquer sans le transformer en charge mentale ;

- et ce qu’on en retire, côté recrue comme côté équipe.

Prêt à faire de vos onboardings une vraie rampe d’accélération ?

Le principe du buddy : un repère, pas un manager

Un buddy, ce n’est pas un formateur. Ce n’est pas un manager. Et ce n’est pas “la personne sympa qui va répondre aux questions”.

C’est un repère clair pendant les premières semaines. Une personne de l’équipe, identifiée à l’avance, qui va :

- accueillir la nouvelle recrue dès le premier jour ;

- guider sur les usages informels : rituels, outils, habitudes de l’équipe ;

- répondre aux questions de terrain — sans formalisme, sans pression ;

- aider à débloquer les premiers sujets concrets.

Le but : éviter le flou. Ne pas laisser la recrue chercher seule qui peut l’aider, ce qu’elle peut oser demander, ou comment avancer sur sa première PR.

Ce qu’un buddy n’est pas :

- un lead technique bis ;

- une personne RH ;

- un coach sur tous les sujets.

👉 C’est un relai horizontal. Un binôme ponctuel, sur les 3 à 6 premières semaines, pour faire le lien humain et opérationnel.

Chez Yield, on choisit le buddy dans la future équipe de la recrue — pas hors contexte. Et on le prépare : objectifs clairs, timing réaliste, points d’étape.

Quand (et pourquoi) le mettre en place

Un système de buddy n’est pas réservé aux grandes entreprises. Il devient utile dès qu’une équipe tech dépasse 3 à 4 personnes, ou qu’on commence à accueillir plus d’un profil par an.

Pourquoi ? Parce qu’à ce stade, l’intégration ne peut plus reposer sur “tout le monde est dispo” ou “on répond au fil de l’eau”. Et parce que l’onboarding est rarement documenté à 100 %. Résultat : sans repère dédié, la recrue se débrouille — ou se bloque.

👉 Les cas où le système de buddy fait vraiment la différence :

- Première recrue tech dans une boîte produit : besoin de poser les bases culturelles.

- Croissance de l’équipe : plusieurs arrivées en 3 mois → risque de dilution du lien humain.

- Projet client structurant : nouvelle équipe montée rapidement → éviter les flottements.

- Recrutement à distance : quand le lien informel ne se crée pas naturellement.

Ce que ça évite ? Une recrue qui n’ose pas déranger, des pratiques d’équipe floues ou mal transmises, ou encore une montée en charge ralentie faute de repères.

💡 Chez Yield, on déclenche systématiquement un buddy onboarding dès qu’un nouveau profil tech rejoint un projet avec plusieurs devs en place. Ça crée du lien, du rythme, et une vraie courbe de progression — dès la première semaine.

Ce que doit (et ne doit pas) faire un buddy

Un buddy, ce n’est ni un manager bis, ni un guide spirituel. C’est un repère concret dans l’équipe. Quelqu’un à qui la recrue peut poser toutes les questions — sans pression, sans jugement.

👉 Ce qu’on attend d’un buddy :

- Être disponible, surtout la première semaine (daily informel, check-ins réguliers) ;

- Rendre l’informel accessible : usages de l’équipe, canaux de com, habitudes de dev ;

- Orienter sans imposer : aider à comprendre les pratiques, pas tout dicter ;

- Faire le lien avec l’équipe : présenter les rituels, les rôles, les dynamiques.

Mais aussi savoir poser des limites : un buddy n’est pas un tuteur à plein temps. Il ne fait pas de reporting RH. Il n’a pas à valider les choix de la recrue. Il accompagne, il ne pilote pas.

💡 Ce qu’on rappelle souvent chez Yield : être buddy, c’est être le premier contact, pas le seul référent. Le but est d’ouvrir les portes, pas de tout centraliser.

Et pour ça, le plus efficace reste la transparence :

- “Voici comment je fais, mais tu peux demander aussi à [X].”

- “Ce point-là, mieux vaut en parler avec [lead / PO / QA].”

🎯 Le buddy crée un sas de confiance. C’est ce qui fait passer une recrue de “je ne sais pas par où commencer” à “je sais à qui parler, et où chercher”.

Les bonnes pratiques autour du buddy

Un système de buddy ne fonctionne pas par magie. Il faut un cadre, des habitudes, et un peu d’intention. Voici ce qu’on recommande de mettre en place pour que ça marche — vraiment.

Chez Yield, on pose ces pratiques simples (et efficaces) :

- Un binôme défini dès l’arrivée, pas à l’arrache le jour J ;

- Un petit brief du buddy avant l’onboarding : contexte, rôle de la recrue, attentes côté équipe ;

- Un parcours d’intégration clair : doc interne, stack technique, projet en cours — le buddy n’est pas là pour tout expliquer à voix haute ;

- Des points réguliers la première semaine, puis un rythme plus espacé (daily café, point hebdo informel…) ;

- Un point de passage à 1 mois : pour partager les feedbacks des deux côtés, et ajuster si besoin.

💡 Pro tip : on utilise un simple template de buddy dans Notion, avec les actions à suivre, les infos utiles à transmettre, les liens vers les outils internes. Résultat : un accompagnement homogène, même avec des équipes qui tournent.

👉 Ce qu’on vise, c’est un onboarding fluide, humain, et sans perte d’information. Pas une checklist froide. Le buddy est là pour créer du lien — et faire en sorte que la recrue se sente attendue, pas juste accueillie.

Les limites du modèle (et comment les éviter)

Le système de buddy a ses vertus. Mais mal posé, il peut vite devenir une case à cocher inutile — ou pire, une fausse bonne idée qui fatigue tout le monde.

Voici les écueils qu’on croise le plus souvent :

❌ Un buddy désigné au dernier moment, sans explication, ni temps dédié → il improvise, ou fait le minimum.

❌ Un rôle flou : est-ce qu’il parle du projet ? des rituels ? de la culture d’équipe ? Résultat : la recrue n’ose pas poser les vraies questions.

❌ Un binôme imposé sans affinité → la relation reste distante, voire inexistante.

❌ Un buddy surbooké → il veut bien faire, mais n’a pas le temps d’accompagner. Et l’intégration en souffre.

Chez Yield, on contourne ces limites en posant des conditions simples :

- On choisit un buddy volontaire, avec un peu de dispo — pas juste “le dev qui connaît le projet”.

- On formalise ce qui est attendu, pour éviter les flous : lien humain, premiers jours, transmission des codes de l’équipe.

- On donne des rendez-vous dans le temps : un point dès l’arrivée, un autre à J+5, un bilan à 1 mois.

👉 Un buddy, ce n’est pas un mentor ni un manager. C’est un repère. Et ça, ça se construit. Pas besoin de grand moyen — juste de l’intention bien placée.

✅ Check-list : un buddy onboarding efficace, c’est…

Côté équipe :

- Un·e buddy volontaire et disponible

- Un périmètre de mission défini (accueil, pair, relais)

- Un point de contact clair pour remonter les blocages

- Un espace de suivi partagé (Notion, Slack, etc.)

Côté buddy :

- Un temps dédié chaque semaine (et pas “quand j’ai 5 min”)

- Des rituels : café de bienvenue, point hebdo, bilan de fin

- Une posture bienveillante — mais pas infantilisante

- Une transmission des “codes non écrits” de l’équipe

Côté nouvel arrivant :

- Un onboarding clair (outils, projet, stack)

- Une vraie place dans les rituels d’équipe

- Des premiers tickets à impact (pas juste du “starter pack”)

- Un espace pour poser ses questions sans filtre

💡 Chez Yield, on voit le buddy onboarding comme un accélérateur : 4 semaines bien posées pour créer de la confiance, de l’autonomie… et éviter les faux départs.

En résumé — Le buddy, c’est ce qui transforme un onboarding en intégration

Un onboarding réussi, ce n’est pas juste “accueillir quelqu’un” — c’est le mettre en situation de contribuer vite, bien, et avec confiance.

Et pour ça, rien ne remplace un repère humain : quelqu’un qui connaît les codes, les attentes, le fonctionnement quotidien. Pas pour tout expliquer. Mais pour montrer où chercher, à qui parler, comment s’intégrer.

Chez Yield, on voit le système de buddy comme un outil simple, mais structurant. Il fluidifie l’arrivée, renforce la cohésion, et transmet la culture sans jargon.

Pas besoin d’un programme complexe. Il suffit d’un cadre clair, de bonnes questions, et d’un peu de temps dédié.

Et vous ? Si vous voulez structurer un onboarding tech qui va plus loin qu’un Notion partagé, parlons-en.

“Ajouter une gestion des congés.” Vous avez déjà lu cette ligne dans une spec. Et derrière ? Trois semaines de malentendus : Qui peut valider quoi ? Quels cas limites ? Quels rôles ? Quelles règles ?

👉 Résultat : un développement en zigzag, une QA bancale, et une recette qui redécouvre les règles métier à la dernière minute.

C’est exactement ce que la BDD permet d’éviter. Pas en ajoutant une couche de complexité. Mais en écrivant les besoins comme des comportements attendus — testables, compréhensibles, utilisables par toute l’équipe.

Chez Yield, on utilise Gherkin sur les projets web complexes : pour poser une spec claire, éviter les effets tunnel, et faire travailler ensemble produit, dev et métier. Ce n’est pas une méthode de test. C’est une façon de construire du logiciel qui marche comme il faut, du premier coup.

Dans cet article, on vous partage notre méthode terrain pour utiliser Gherkin à bon escient :

- ce qu’est (vraiment) la BDD — et ce qu’elle n’est pas ;

- comment bien écrire un scénario utile (et lisible) ;

- comment intégrer Gherkin dans un process produit/dev/QA, sans le complexifier ;

- et ce que ça change, pour de vrai, sur la qualité livrée.

Ce qu’est (vraiment) la BDD — et ce qu’elle n’est pas

Behavior-Driven Development, ce n’est pas “tester en Gherkin”. C’est une méthode de collaboration. Pour aligner dev, produit et métier sur ce que doit faire l’application — et le rendre vérifiable, noir sur blanc.

👉 La BDD commence avant le code. Elle vise à clarifier le besoin sous forme de comportements : si telle situation se présente, alors tel résultat est attendu.

Ce que la BDD vous apporte (quand elle est bien faite)

- Une spécification vivante : écrite en langage naturel, lisible par toute l’équipe.

- Des tests automatisables dès le cadrage (pas en fin de dev).

- Une meilleure QA : les cas critiques sont déjà posés et documentés.

- Moins de frictions : on parle le même langage, dès le début.

Ce que la BDD n’est pas

- Un outil réservé aux QA techniques.

- Une obligation d’écrire tous les tests en Gherkin.

- Un framework magique qui “fait de la qualité”.

⚠️ Ce qu’on voit souvent sur le terrain : une équipe pose un framework BDD (Behat, Cucumber, SpecFlow…) sans changer ses pratiques. Résultat ? Des specs mal écrites, des tests inexploitables, et une perte de temps.

Chez Yield, on part toujours du besoin métier exprimé comme un scénario clair, puis on l’intègre dans la chaîne produit/dev/test. C’est ce qui permet d’éviter le classique “mais ce n’est pas ce qu’on avait compris”.

Comment bien écrire un scénario Gherkin (utile et lisible)

Un bon scénario Gherkin, ce n’est pas juste un test en langage humain. C’est une mise en situation concrète, partagée entre produit, tech et QA. Lisible, vérifiable, sans ambiguïté.

Le format de base

Feature: Validation d’un justificatif RH

Scenario: Un manager accepte un justificatif valide

Given un justificatif en attente

And un manager connecté

When il clique sur "Valider"

Then le statut passe à "Validé"

And un mail est envoyé au salarié

➡️ 3 mots-clés essentiels :

Given(contexte) — Ce qu’on suppose vrai au départWhen(action) — Ce que l’utilisateur faitThen(résultat attendu) — Ce qui doit se passer

Les règles qu’on applique chez Yield

Un seul scénario = un seul comportement testé

Pas de parcours à rallonge. Chaque scénario doit pouvoir rater ou réussir simplement.

Des noms de features explicites

“Validation RH” > “Feature RH n°2”. L’objectif doit être clair en un coup d’œil.

Des termes fonctionnels, pas techniques

“Un manager connecté” > “un user avec le rôle ROLE_MANAGER”.

Des cas alternatifs

On couvre aussi les cas d’erreur, d’accès refusé, etc. Le but : tester les chemins critiques, pas que le “happy path”.

Retour d’XP — structurer un backlog avec Gherkin

“Sur une app B2B avec des workflows métiers complexes, on a transformé la spec Word du client en 12 scénarios Gherkin clairs. Résultat : la QA savait exactement quoi tester, les devs n’ont pas eu de flou, et le client validait chaque scénario en lecture simple.”

— Clara, Product Strategist @Yield Studio

👉 Bien écrits, les scénarios Gherkin deviennent la boussole partagée de l’équipe. Pas un fardeau de plus.

Intégrer la BDD dans le cycle produit (sans lourdeur)

La méthode BDD ne remplace pas vos rituels produit. Elle les renforce — en apportant clarté, alignement et testabilité dès les premières discussions.

Chez Yield, on ne “fait pas du Gherkin” pour faire joli. On l’intègre là où ça sert le plus.

Dès la discovery : formaliser des cas concrets

On part souvent d’une phrase métier floue :

“Il faudrait que les RH puissent valider les demandes plus vite.”

➡️ On traduit ça en scénario, en atelier :

Scenario: La validation express d’un justificatif

Given un justificatif sans erreur

When un RH clique sur “Valider”

Then il est traité automatiquement

Résultat : tout le monde comprend ce qu’il faut construire — et pourquoi.

En refinement : prioriser les scénarios utiles

Chaque scénario devient une unité de découpage claire. On priorise les comportements les plus critiques, pas les composants visuels.

👉 Moins de specs vagues. Plus de cas testables.

En QA : automatiser ou tester à la main, sans surprise

Gherkin peut alimenter des tests automatiques (via Behat, Cypress…) ou servir de plan de test manuel. Mais surtout, il formalise ce qu’on veut tester, sans réinterprétation.

Retour d’XP — cadrer un MVP en 10 scénarios

“Sur un SaaS en B2B, on a démarré par 10 scénarios Gherkin prioritaires. Chaque sprint reprenait un à deux cas. En 6 semaines, on avait une V1 utile, testée, sans back & forth inutiles.”

— Thibaut, PO @Yield Studio

👉 Avec BDD, la spec devient un outil d’équipe. Pas un document figé entre deux silos.

Les pièges à éviter avec Gherkin (et comment les contourner)

Mal utilisé, Gherkin devient vite un nouveau jargon inutile. Voici les erreurs qu’on croise encore trop souvent — et ce qu’on recommande à la place.

❌ Écrire des scénarios pour tout… sans priorité

“On a 50 scénarios Gherkin mais aucun MVP en vue.”

Gherkin, ce n’est pas pour tout formaliser. C’est pour clarifier les comportements clés. Les 80 % les plus utiles.

Ce qu’on fait chez Yield : cadrer les 5 à 10 scénarios critiques. Ceux qui font la valeur du produit — ou ceux qui posent problème.

❌ Utiliser Gherkin comme un cahier de specs

“Chaque bouton, chaque champ… tout est en Gherkin.”

Résultat : des scénarios illisibles, inutilisables, jamais relus.

Un bon scénario Gherkin décrit un comportement métier, pas une UI.

Exemple :

Given un client non connecté

When il ajoute un produit au panier

Then il voit une pop-in de connexion

👉 Ce n’est pas du micro-détail. C’est une règle observable.

❌ Confondre test technique et scénario produit

Gherkin n’est pas du code. Ce n’est pas là pour tester que “l’élément X a une classe .active”. C’est là pour poser des comportements compréhensibles par tous.

Si le dev ne comprend pas la règle métier → c’est que le scénario est mal écrit.

Si le métier ne comprend pas le test → c’est que ce n’est pas du Gherkin.

💡 À retenir

Un bon scénario Gherkin :

- Se lit comme une mini-histoire ;

- S’ancre dans un usage réel ;

- Évite le flou (“ça doit marcher comme d’habitude”)

👉 Ce n’est pas du formalisme. C’est ce qui aligne produit, dev, QA… autour du même langage.

Bonus : un template de scénario Gherkin utile (à adapter à votre projet)

Feature: Relance automatique des impayés

Scenario: Un client reçoit une relance après 7 jours d'impayé

Given une facture en statut "en retard" depuis 7 jours

And le client a un email valide

When le job de relance est déclenché

Then un email de relance est envoyé

And l’action est tracée dans l’historique

Scenario: Aucune relance si le client a déjà été relancé

Given une facture en retard

And une relance envoyée il y a moins de 7 jours

When le job s’exécute

Then aucun mail n’est envoyé

💡 Ce type de scénario sert aussi de test, de doc, et de spec. Trois en un. C’est ça, le vrai gain.

Conclusion — Bien utilisé, Gherkin devient un outil de clarté

La plupart des projets web se perdent non pas à cause de la tech… mais à cause des malentendus. Une règle mal comprise, une exception non gérée, un flou qui traîne.

Gherkin ne résout pas tout. Mais bien intégré, il permet à toute l’équipe de parler le même langage. Produit, métier, dev, QA : on part d’un scénario clair, on construit en confiance, on teste sans interprétation.

Chez Yield, on l’utilise pour cadrer les cas critiques, sécuriser les sprints, et poser une spec qui vit — pas un cahier des charges figé. Pas besoin de 100 scénarios. Juste les bons, bien écrits, partagés.

👉 Si vous construisez un produit sur mesure, et que vous voulez réduire les frictions produit/tech, Gherkin peut vraiment faire la différence. Encore faut-il l’utiliser comme ce qu’il est : un outil de conversation, pas un formalisme de plus.

Besoin de structurer vos règles produit sans tout recoder 3 fois ? On peut vous aider.

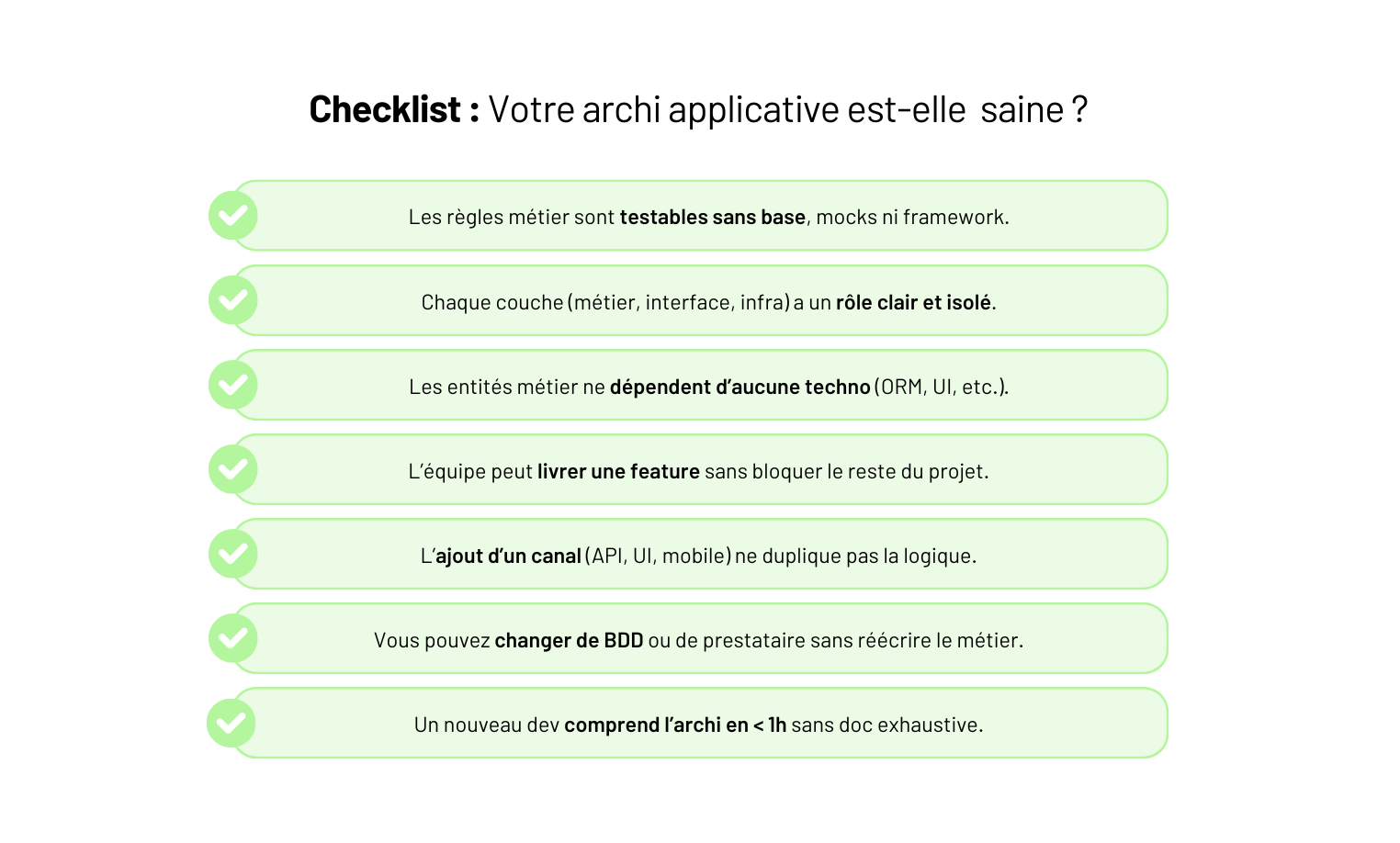

Vous avez une première V1 qui tourne. Un produit qui prend de l’ampleur. Des besoins qui s’empilent : nouvelle feature, nouveau canal, nouvelle équipe. Et à chaque évolution, c’est plus dur d’avancer.

Vous sentez que “l’archi ne suit pas” — mais par où reprendre les choses sans tout casser ?

C’est là que le sujet architecture devient critique. Ce qui vous permet de livrer vite, de garder la maîtrise, et d’éviter les tickets “ça casse ailleurs” à chaque sprint.

Chez Yield, on conçoit des applications sur mesure. Et une chose est sûre : ce n’est pas la taille du projet qui impose une architecture — c’est la volonté de livrer propre, de faire évoluer sans dette, et de structurer dès le début ce qu’on ne veut pas subir plus tard.

Dans cet article, une méthode claire pour poser les bases d’une architecture applicative qui tient :

- les vraies questions à se poser avant de schématiser ;

- les blocs essentiels (et comment les découper intelligemment) ;

- les patterns utiles (et ceux à manier avec recul) ;

- et surtout : comment garder une archi vivante… pas juste jolie dans Notion

Prêt à concevoir une application qui tient la route — pas juste qui passe en staging ?

Ce qu’on attend d’une architecture en 2025

Une “bonne archi”, ce n’est pas une architecture à la mode. C’est une architecture qui sert votre produit — aujourd’hui, et demain.

👉 En 2025, les attentes sont claires. Une architecture applicative doit permettre de :

Évoluer sans tout casser

Un nouveau use case ? Un canal de plus ? Un connecteur tiers ?

L’archi doit permettre de brancher, étendre, adapter — sans effet domino.

Délivrer vite, sans sacrifier la qualité

Pas de choix technique bloquant. Pas de monolithe incompréhensible.

Une équipe doit pouvoir livrer des features en parallèle, tester sans friction, corriger vite.

S’adapter à plusieurs rythmes

Côté back, ça avance à un rythme. Côté front, un autre. Idem pour les apps mobiles, les API partenaires…

L’archi doit isoler les sujets, pas tout lier dans un gros bloc figé.

Rester compréhensible

Pas une cathédrale. Une architecture compréhensible en 30 min par un dev qui débarque.

Documentation, conventions, structure de dossiers : tout doit aider à onboarder vite.

S’outiller sans s’enfermer

CI/CD, monitoring, sécurité, logs… ça fait partie de l’archi.

Mais attention aux stacks magiques impossibles à maintenir. Une bonne archi laisse de la place au changement sans tout refaire.

💡 À retenir

Votre architecture, c’est votre produit en version technique. Elle doit suivre son cap, absorber ses évolutions… et ne jamais devenir son propre problème.

Avant de schématiser : poser les bonnes questions

Avant d’ouvrir Whimsical ou de choisir votre stack, commencez par cadrer le vrai contexte. Une architecture utile, c’est une réponse à un produit, une équipe, une durée de vie — pas un modèle copié-collé.

👉 Les questions qu’on pose systématiquement chez Yield :

Quel type de produit ?

App B2B critique, outil interne, app mobile terrain ? Chaque usage impose ses contraintes (scalabilité, dispo, UX…).

Quel rythme d’évolution ?

Un sprint par mois ou trois features par semaine ? Plus ça bouge, plus l’archi doit être modulaire.

Quelle complexité métier ?

Des règles simples ou des cas tordus à la volée ? Ça change tout sur le découpage logique et la place du domaine.

Quelle durée de vie ?

Un POC ? Un SaaS pour 5 ans ? Même un projet court mérite une base claire si on veut itérer sans douleur.

Quelle équipe ?

Seniors autonomes ou juniors à onboarder ? L’archi doit rester lisible, testable, explicable.

💡 Ce qu’on fait souvent chez Yield : un atelier flash “architecture produit” avec lead dev + PO + CTO. En 2 heures, on cale le vrai contexte. Ça évite de schématiser trop tôt… ou à côté.

Les blocs fondamentaux à structurer

Pas besoin de 15 couches pour poser une bonne architecture. Ce qu’on cherche, c’est une structure claire, évolutive, et maintenable.

Chez Yield, on découpe en 4 grands blocs — chacun avec un rôle net, des limites claires, et peu de dépendances croisées.

1. Le cœur métier : vos règles, pas votre base

C’est ici que vit la vraie valeur : les objets métiers, les statuts, les règles de gestion, les workflows… Tout ce qui fait que “votre produit fonctionne comme ça”.

Ce bloc ne doit dépendre de rien d’autre : ni de la base, ni d’un framework, ni d’une interface. C’est ce qui permet de faire évoluer le produit sans tout recoder.

2. La couche d’accès : APIs, UI, CLI…

Elle expose le cœur métier à l’extérieur : une API pour un front, une interface admin, une app mobile, un webhook.

Chaque canal a ses propres contraintes (auth, pagination, ergonomie…) — mais ne doit jamais embarquer de logique métier. On veut pouvoir faire évoluer un canal sans impacter les autres.

3. Les adaptateurs : le pont entre les mondes

C’est là que les technos concrètes vivent : persistance, notifications, appels à Stripe ou Sendinblue…

Ce sont des “ponts” entre votre métier et le reste. En les isolant, vous pouvez changer d’outil ou de prestataire sans réécrire tout le code métier.

4. L’infrastructure : ce qui exécute et surveille

Environnements, CI/CD, logs, sécurité, déploiement… Tout ce qui permet à l’app de tourner — proprement, en continu, sans stress.

Ce bloc doit être présent dès la V1, même en simple. Ce n’est pas une surcouche : c’est ce qui transforme du code en produit.

💡 À retenir

Ce découpage n’est pas dogmatique. Mais si l’un de ces blocs déborde sur un autre, vous allez le sentir très vite : devs qui bloquent, features qui cassent, tests impossibles…

Un bon design, c’est souvent juste une séparation nette entre ce qui décide (métier) et ce qui exécute (technique).

Les patterns utiles — et ceux à manier avec recul

Tous les projets n’ont pas besoin d’Event Sourcing ou de DDD complet. Mais certains patterns peuvent vraiment simplifier l’architecture — si on les pose au bon moment, pour les bonnes raisons.

Voici ceux qu’on utilise le plus souvent chez Yield (et ceux qu’on évite… ou qu’on réserve à des cas bien cadrés).

✅ Les patterns qu’on applique régulièrement

DTOs (Data Transfer Objects)

On isole les échanges entre les couches (UI ↔ API ↔ métier ↔ base). Ça clarifie les flux, protège la logique, facilite les tests.

→ Surtout utile côté API, pour découpler la ressource exposée de l’entité réelle.

Application services

Une méthode = une action métier. Ils orchestrent les appels au domaine, aux adaptateurs, aux validations.

→ Lisible, testable, clair : pas de logique dispatchée dans 3 listeners.

Ports & Adapters (aka Hexagonal)

On isole les dépendances externes derrière des interfaces (mail, DB, Stripe…).

→ On teste le métier “en local”, sans friction, et on change de techno sans douleur.

Domain Events simples

Quand une action métier déclenche des effets secondaires (ex : “commande validée” → envoi d’un mail), on passe par un event interne.

→ Ça évite que chaque service connaisse tout le monde.

⚠️ Les patterns qu’on réserve à des cas bien spécifiques

Event Sourcing / CQRS pur

Oui, ça peut être puissant. Mais ça complexifie tout : stockage, lecture, débogage.

→ On le pose uniquement si le métier l’exige (audit, rollback, règles ultra-complexes).

Microservices “by default”

Découpler pour découpler, c’est risquer de tout ralentir.

→ On commence souvent monolithe modulaire — puis on extrait quand un domaine a une vraie vie propre (techno, perf, équipe dédiée…).

Architecture “orientée framework”

On ne veut pas que Symfony (ou Nest, ou Django) impose sa vision du monde.

→ L’architecture doit survivre à un changement de framework. Le métier reste, le reste s’adapte.

💡 Une bonne architecture, ce n’est pas empiler des patterns. C’est savoir lesquels vous servent — et lesquels vont vous ralentir.

Faire vivre l’architecture — ou comment éviter qu’elle vous freine

Une bonne architecture ne se fige pas. Elle évolue avec le produit, les équipes, les usages. Le piège ? La traiter comme une big picture figée — qu’on ne remet plus jamais en question.

👉 Ce qu’on applique systématiquement chez Yield pour garder une architecture vivante :

Revue régulière, pas réécriture annuelle

Tous les 2 à 3 mois, on cale un point rapide : qu’est-ce qui coince, où l’archi freine-t-elle, quels patterns ont dérivé ? Mieux vaut une archi itérative qu’un “refacto complet” tous les deux ans.

Documentation minimale, utile, à jour

Pas besoin de 40 pages en PDF. Une carte claire du découpage, des liens vers les modules clés, deux exemples d’usage par bloc — suffisent souvent. Et surtout : à jour dans Git ou Notion, pas dans la tête d’un seul dev.

Architecture observable = architecture maîtrisée

Si vous ne tracez rien, vous ne comprenez rien. Logs, métriques, alertes : l’archi doit inclure l’observabilité dès la V1. C’est ce qui permet de diagnostiquer vite — et d’ajuster sans peur.

Prévoir les transitions

Une archi propre n’est pas figée — mais elle prévoit les migrations. Dual-write, feature toggles, versions d’API : autant de leviers pour évoluer sans casser. Ce n’est pas “technique”, c’est stratégique.

Conclusion — Une bonne architecture, c’est ce qui vous fait livrer vite, bien, longtemps.

Pas besoin de schémas complexes. Une architecture applicative, c’est une base claire qui soutient votre produit à chaque évolution — pas un ornement technique.

👉 Ce qu’on retient chez Yield :

- Le bon moment pour structurer, c’est dès maintenant, pas quand ça casse.

- Une archi utile, c’est une archi qui isole les responsabilités : métier, accès, adaptateurs, infra.

- Les bons patterns sont ceux qui simplifient — pas ceux qui alourdissent.

- Une architecture, ça se fait vivre : doc à jour, rituels d’archi, migrations maîtrisées.

Vous sentez que votre archi ralentit l’équipe ? Ou que la prochaine évolution risque de tout casser ? On peut vous aider à poser une base solide — ou à remettre de l’ordre sans repartir de zéro.

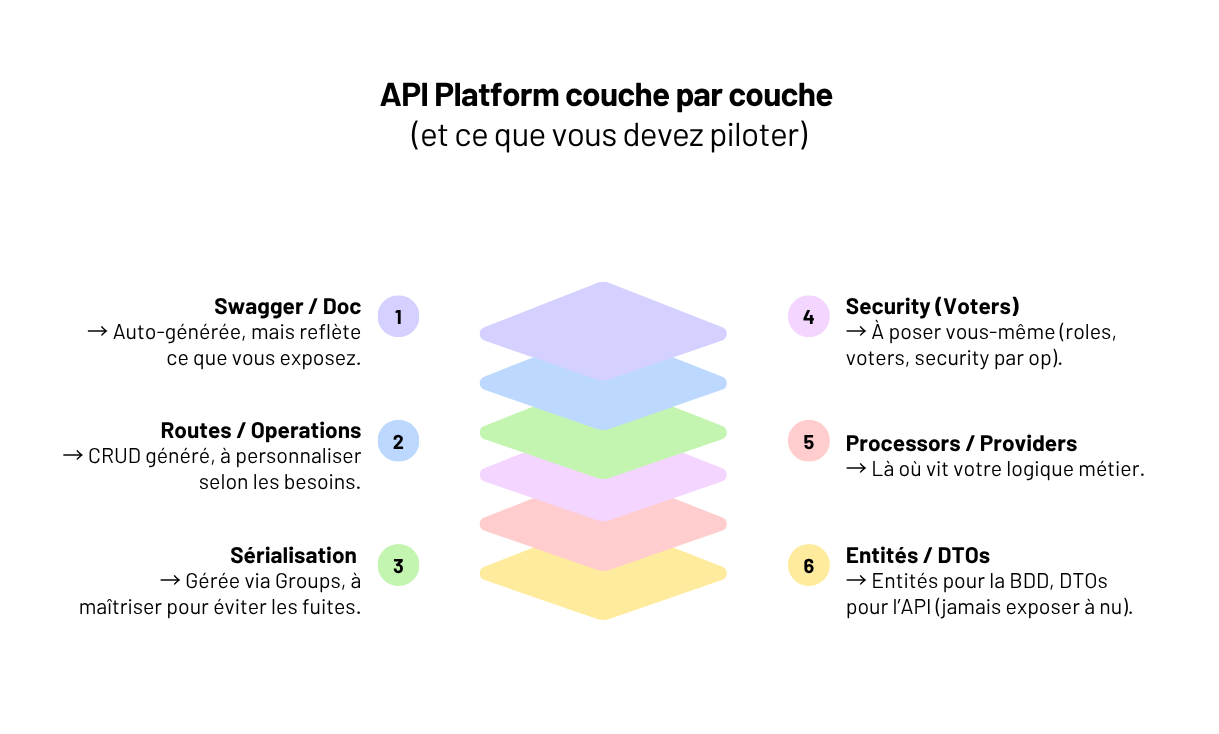

Créer une API REST en Symfony avec API Platform : le tuto complet (et réaliste)

Un extranet RH qui expose des données sensibles. Un SaaS qui ouvre son API à des clients tiers. Une app mobile qui repose sur un backend stable, versionnable, documenté...

👉 En 2025, presque tous les produits web pros ont besoin d’une API REST.

Mais une API, ce n’est pas juste trois routes en JSON. C’est un contrat. Une interface à maintenir. Une base à faire évoluer sans tout casser.

Et c’est là qu’API Platform entre en jeu : rapide à poser, complet, bien intégré à Symfony.

Mais aussi : verbeux, parfois opaque, et vite source de bugs… si on ne sait pas ce qu’il fait exactement.

Chez Yield, agence de développement web, on conçoit des APIs critiques : back-offices interconnectés, portails clients complexes, outils internes à forte logique métier. On a vu les forces d’API Platform — et les problèmes quand on l’utilise comme une boîte noire.

Dans cet article : un vrai guide. Pas un tuto où tout marche au premier composer req.

Une base propre, testable, versionnable, maintenable. Avec les bonnes conventions, les pièges à éviter, et les patterns qu’on applique pour que l’API tienne — en prod, sur la durée.

Setup — poser une base propre

API Platform s’installe en 2 lignes. Mais si vous partez comme ça, vous exposez une base fragile.

Avant de générer quoi que ce soit, posez une structure claire :

composer create-project symfony/skeleton my-api

composer require api orm security lexik/jwt-authentication-bundle

Ensuite, séparez les rôles :

- Vos entités Doctrine vont dans src/Domain

- Vos ressources API (DTOs, config) dans src/Api

- Et surtout : aucune entité exposée directement

Configurez Doctrine sans auto-mapping global. Vous gardez la main sur ce qui est mappé — et ce qui ne l’est pas.

Activez JWT et posez les bases de votre auth dès maintenant. Même si c’est simplifié, vous évitez d’y revenir en urgence dans 3 sprints.

Enfin : prévoyez une base de test propre (env.test, fixtures, factories). Pas un MySQL local bricolé.

🎯 Objectif ici : une base versionnable, testable, maintenable — pas juste une API qui “répond”.

Exposer une ressource — mais penser produit

Créer une ressource API avec API Platform, c’est rapide. Trop rapide, parfois.

Un #[ApiResource] sur une entité Doctrine, un coup de GET /orders, et ça “marche”.

Sauf que :

- Vous exposez peut-être toute la base sans contrôle.

- Vous n’avez aucun input propre pour les créations.

- Et votre Swagger montre des champs que vous ne vouliez pas montrer.

👉 Ce qu’on pose systématiquement chez Yield :

Une vraie ressource métier

Prenons Order :

- contient un client, un statut, une liste de lignes ;

- en lecture : vous voulez tout exposer ;

- en écriture : certaines infos sont calculées, d’autres saisies ;

Résultat : on découpe proprement.

- Lecture → un DTO

OrderOutput, exposé en GET - Écriture → un DTO

OrderInput, exposé en POST, avec validation dédiée

Ces deux classes sont déclarées comme ApiResource, chacune avec son normalizationContext et denormalizationContext.

Pas besoin de contrôleur — des providers et processors suffisent dans 90 % des cas.

Des groupes de sérialisation clairs

Sans groups, vous exposez tout. Avec trop de groupes, c’est ingérable.

Gardez ça simple : read, write, et des cas métier (read:client, write:admin, etc.)

Une logique métier hors des entités

Pas de if ($this->status === 'cancelled') dans votre modèle Doctrine.

Utilisez les processors pour encapsuler les règles produit : statut, droits, erreurs.

🚨 Exemple : une API exposait un champ status modifiable en direct → tout le workflow de commande est tombé en prod. Depuis : DTO + processor obligatoire.

Structurer vos DTO sans complexifier

Pas besoin de tout découper façon clean architecture.

Un DTO = un use case métier. Ce qui entre (POST), ce qui sort (GET).

Et si votre domaine est bien pensé, vous pouvez réutiliser vos Value Objects côté API.

Attention au PATCH

Le PATCH part sur du merge par défaut. C’est pratique, mais risqué.

Un champ mal contrôlé, et vous écrasez une donnée calculée ou critique.

👉 Ce qu’on recommande souvent : utiliser PUT explicite, ou un processor qui filtre finement les champs modifiables.

Gérer la validation proprement

Vos contraintes doivent être sur les DTOs, pas dans les entités :@Assert\NotBlank, @Assert\Choice, @Assert\Email… API Platform les prend en charge nativement.

Et surtout, il renvoie des erreurs 422 lisibles côté front — ce qui évite bien des allers-retours avec les équipes produit.

Une ressource, ce n’est pas une entité. C’est une interface pensée pour les usages réels — pas une photo de la base à un instant T.

Gouverner les cas complexes — auth, logique, subresources

Exposer une ressource simple, c’est fait. Maintenant viennent les vrais enjeux.

Et là, API Platform ne vous mâche plus tout.

Sécuriser les accès

Vous pouvez — et devez — sécuriser chaque opération directement dans la ressource :

[ApiResource(

operations: [

new Get(security: "is_granted('ROLE_ADMIN')"),

new Post(securityPostDenormalize: "is_granted('ROLE_USER')")

]

)]

C’est lisible, testable, et ça évite les listeners planqués.

On ajoute vite JWT (lexik/jwt-authentication-bundle), un user provider propre, et un mapping de rôles maîtrisé.

Pas juste ROLE_USER. Dans un vrai produit, vous avez des rôles hiérarchiques, des scopes, des accès par périmètre.

👉 Mettez des Voter métier en place dès la V1. C’est ce qui vous sauve à S+6.

Et côté Swagger : pensez à filtrer les endpoints selon les droits (swagger_context) pour éviter de documenter des opérations invisibles ou interdites.

Implémenter la logique métier proprement

Dès que ça dépasse le CRUD, sortez du mode automatique.